AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

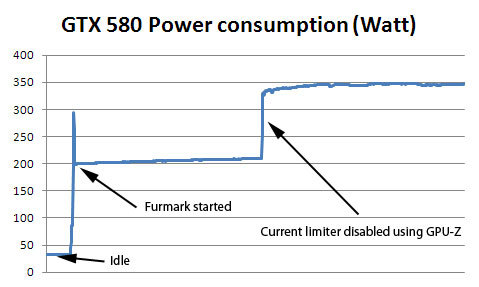

Geforce GTX 580 i Furmark – utan spärrar

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

// Jay-C

CPU: i7 2600K @ 4.5GHz 1.35V (load) w/ H80i v2 | GPU: GTX 1660 GAMING

SSD: MX500 500GB | MB: P8Z68-V Pro | RAM: 2x8GB G.Skill 2133 MHz CL11

APU: X-Fi Titanium Pro | PSU: AX850

Samla alla dina betalkort, gratis valutaväxling, Google Pay m.m. med Curve. £5 bonus med länken: https://www.curve.app/join#EAVGZ56E

Phenom II x4 955, Radeon 4870 1 GB, 4GB DDR3 1333MHz, Corsair VX 550W

Intel Core i9-12900KF 5.2GHz+ HT Custom loop

MSI RTX 4080 Gaming X Trio 3030MHz

Asus ROG Maximus Apex Z690 (WI-FI)

Corsair Dominator Platinum 6200mhz 32GB CL36

Asus 34" TUF VG34VQL1B, NZXT H9 Flow, Corsair HX1200i, 970 Evo Plus, Asus ROG Strix Flare MX, Logitech G502 PS

Tråden om Skägg!

My cave...

Ryzen 5 3600@4,3Ghz - 16GB CL16 - RTX 3070 - Kingston Fury M.2 2TB

🎧Schiit Hel + DT-770 PRO - NAD C316 - B&W 685 - LG 65" OLED B6

Watch Series 5 4G - Macbook Pro 13" 2015 - iPhone 11 PRO 256GB

Chassi: Antec 300 ][ CPU: AMD FX 8320 4,2Ghz ][ Kylning: Zalman CNPS14X ][ Ram:8,00 Gb DDR3 1600 ][

Moderkort: ASUS M5A99 ][ Skärm: ASUS MX279H ][ Grafik: ______ ][ Psu: Corsair CX600M ][

SSD:OCZ Vertex plus 120gb

i7 2600k | P8P67Deluxe | Noctua NH-D14 | KFA2 GTX1080 EXOC | Corsair 750W | Corsair Obsidian 800D | Dell U2412M

America's Army: Proving Grounds

Chassi: Antec 300 ][ CPU: AMD FX 8320 4,2Ghz ][ Kylning: Zalman CNPS14X ][ Ram:8,00 Gb DDR3 1600 ][

Moderkort: ASUS M5A99 ][ Skärm: ASUS MX279H ][ Grafik: ______ ][ Psu: Corsair CX600M ][

SSD:OCZ Vertex plus 120gb

“There will be people that are burdened by only having the capacity to see what has always been instead of what can be.

But don’t you let that burden you.”

Chassi: Antec 300 ][ CPU: AMD FX 8320 4,2Ghz ][ Kylning: Zalman CNPS14X ][ Ram:8,00 Gb DDR3 1600 ][

Moderkort: ASUS M5A99 ][ Skärm: ASUS MX279H ][ Grafik: ______ ][ Psu: Corsair CX600M ][

SSD:OCZ Vertex plus 120gb

Intel Core i9-12900KF 5.2GHz+ HT Custom loop

MSI RTX 4080 Gaming X Trio 3030MHz

Asus ROG Maximus Apex Z690 (WI-FI)

Corsair Dominator Platinum 6200mhz 32GB CL36

Asus 34" TUF VG34VQL1B, NZXT H9 Flow, Corsair HX1200i, 970 Evo Plus, Asus ROG Strix Flare MX, Logitech G502 PS

Citera, tack!

Har du läst tråden om strandhögtalare och andra musiklådor?

~Pelle~

~Pelle~

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

AMD Ryzen 5 3600 | 4x8GiB 18-20-16-36-52-2T DDR4-3400 | MSI B450-A Pro Max AGESA 1.2.0.7 | Sapphire RX 480 Nitro+ OC 8GiB | Crucial MX500 500GB | PNY CS900 2TB | Samsung 850 EVO 500GB | Samsung PM961 512GB | Scythe Kamariki 4 450W

2600K @ 4.5 Ghz , Asrock extreme 6, 16GB 1600mhz Kingston, XFX R9 290X@1100/1300 (Arctic cooler 3) ,Corsair 550D ,

Noctua D14, 1TB WD Black, Samsung 830 RAID0, Windows 7.

If you follow the herd you are going to have to step through a lot of manure. Have the courage to trust in yourself and follow your own path.

Intel Core i9-12900KF 5.2GHz+ HT Custom loop

MSI RTX 4080 Gaming X Trio 3030MHz

Asus ROG Maximus Apex Z690 (WI-FI)

Corsair Dominator Platinum 6200mhz 32GB CL36

Asus 34" TUF VG34VQL1B, NZXT H9 Flow, Corsair HX1200i, 970 Evo Plus, Asus ROG Strix Flare MX, Logitech G502 PS

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

Intel Core i9-12900KF 5.2GHz+ HT Custom loop

MSI RTX 4080 Gaming X Trio 3030MHz

Asus ROG Maximus Apex Z690 (WI-FI)

Corsair Dominator Platinum 6200mhz 32GB CL36

Asus 34" TUF VG34VQL1B, NZXT H9 Flow, Corsair HX1200i, 970 Evo Plus, Asus ROG Strix Flare MX, Logitech G502 PS

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

Intel Core i9-12900KF 5.2GHz+ HT Custom loop

MSI RTX 4080 Gaming X Trio 3030MHz

Asus ROG Maximus Apex Z690 (WI-FI)

Corsair Dominator Platinum 6200mhz 32GB CL36

Asus 34" TUF VG34VQL1B, NZXT H9 Flow, Corsair HX1200i, 970 Evo Plus, Asus ROG Strix Flare MX, Logitech G502 PS

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

Intel Core i9-12900KF 5.2GHz+ HT Custom loop

MSI RTX 4080 Gaming X Trio 3030MHz

Asus ROG Maximus Apex Z690 (WI-FI)

Corsair Dominator Platinum 6200mhz 32GB CL36

Asus 34" TUF VG34VQL1B, NZXT H9 Flow, Corsair HX1200i, 970 Evo Plus, Asus ROG Strix Flare MX, Logitech G502 PS

Burk: Asus Maximus XI z390, i7 9900ks @5100mhz, cache 4800mhz, Corsair Platinum ddr4 3600mhz @4400mhz quad 16gig (18-22-22-44 2t), 1st Asus Strix 1080ti + EK @2070/12000mhz, Samsung 840 pro 240 gig x2 raid0, 1 tb 2.5" WD Red, Skärm: Acer x34p, TJ07 custom water, Ljud: HiFiman X v2 + EONE MK2 Muses

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |