EVGA GTX 1080 Ti | Intel Core i9-9900K | Fractal Design Celsius S24 | ASUS ROG Strix Z390-I | 32 GB DDR4 @3200Mhz | Corsair SF750 | Samsung 970 Evo Plus 1 TB (M.2) | Crucial MX 500 & 300 1TB (2,5") | Louqe Ghost S1 Ash | AOC AGON AG271QG, Eizo Foris FS2333 & TCL 75EP660 | Windows 11 64-bit

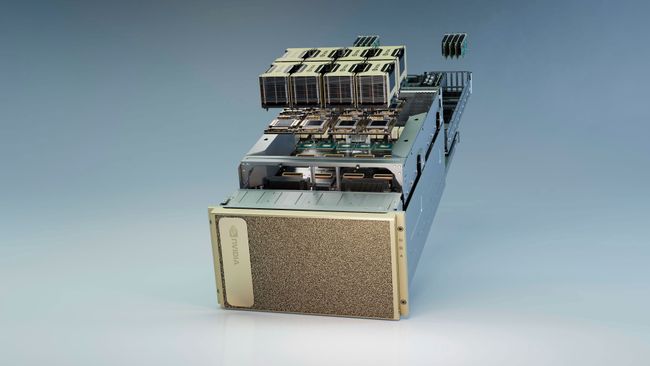

Nvidias Ampere-arkitektur gör premiär i datacenterkortet A100

Senast redigerat

Visa signatur

Visa signatur

Corsair Obsidian 1000D* Corsair AX1600i* Asus Z790 Prime-A* Intel 13900K* 32GB G-Skill DDR5 7600Mhz/36* Asus RTX 4090* Corsair MP600 1TB* Samsung 980 Pro 1TB

Visa signatur

"Gravity is a myth, the earth sucks."

Senast redigerat

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Visa signatur

Engineer who prefer thinking out of the box and isn't fishing likes, fishing likes is like fishing proudness for those without ;-)

If U don't like it, bite the dust :D

--

I can Explain it to you, but I can't Understand it for you!

Visa signatur

Hur många datorer är för många?

Senast redigerat

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Visa signatur

Stationär: AMD Ryzen 7 7800X3D | ASUS ROG Strix B650E-F Gaming WIFI | G.Skill 32GB DDR5 6000MHz CL30 Trident Z5 Neo RGB | Gigabyte 4090 Gaming OC | BeQuiet! Dark Rock 4 Pro | Samsung 980 Pro 1TB M.2 & Intel 660P 1TB M.2 | Corsair RM850x v2 White Series | Phanteks P500A D-RGB | Acer X34GS | Corsair Strafe RGB MX Silent | Razer Deathadder v.2 | Logitech PRO X 7.1

Laptop: AMD Ryzen 7 6800HS | 16GB 4800MHz DDR5 | RTX 3060 140W | 15,6" 144Hz FHD IPS 16:9

Visa signatur

5900X | 6700XT

Visa signatur

Hur många datorer är för många?

Visa signatur

Hur många datorer är för många?

Senast redigerat

Senast redigerat

Visa signatur

Ryzen 5800X ROG STRIX X570-f GAMING FlareX DDR43600 cl 14-14-14-34 EVGA FTW3 Ultra RTX 3090

Visa signatur

Ryzen 5800X ROG STRIX X570-f GAMING FlareX DDR43600 cl 14-14-14-34 EVGA FTW3 Ultra RTX 3090