Observera att samma trivselregler gäller i kommentarstrådarna som i övriga forumet och att brott mot dessa kan leda till avstängning. Kontakta redaktionen om du vill uppmärksamma fel i artikeln eller framföra andra synpunkter.

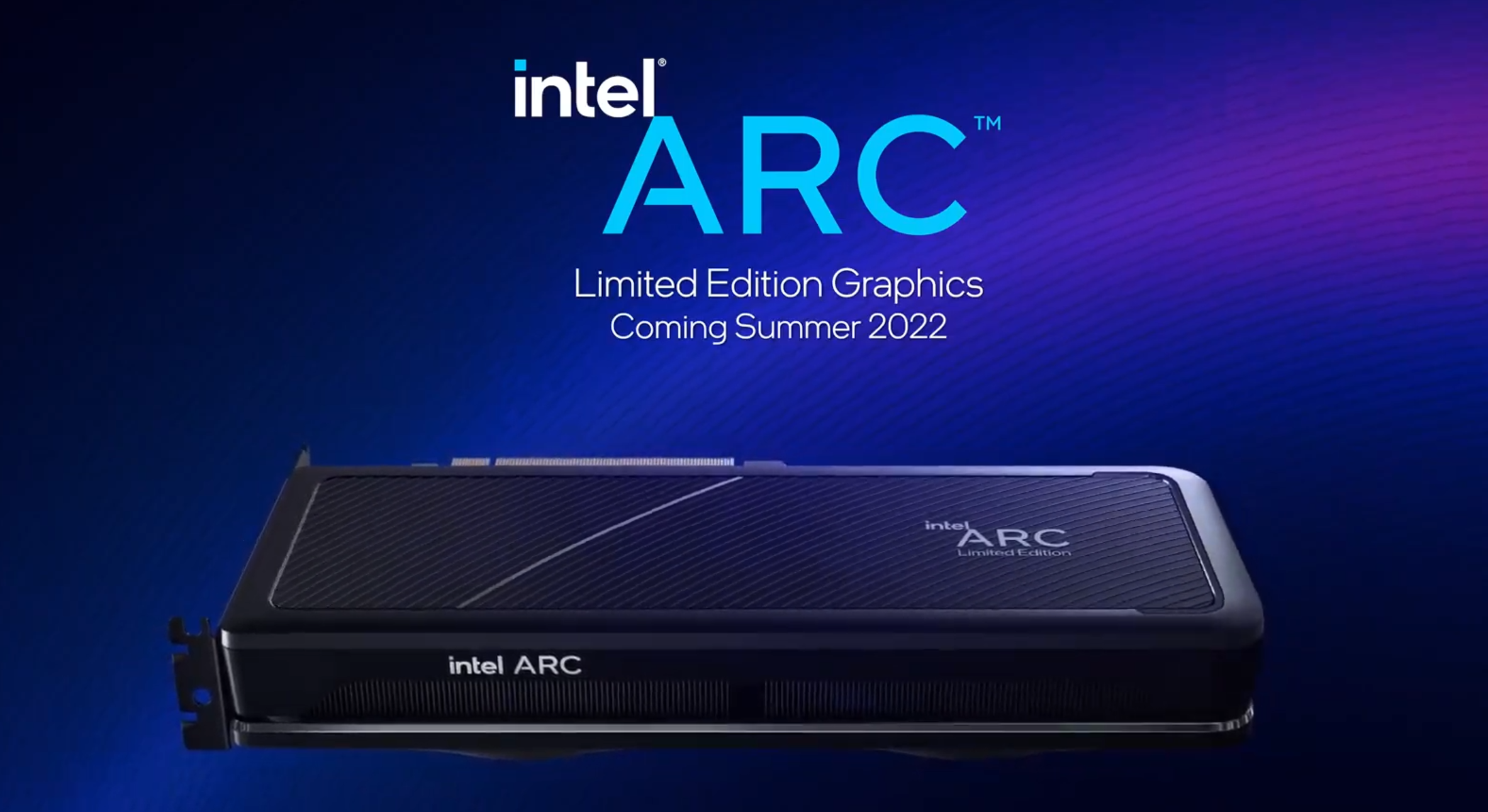

Intel avtäcker grafikkorten Arc för bärbara datorer

Visa signatur

Visa signatur

Processor: Motorola 68000 | Klockfrekvens: 7,09 Mhz (PAL) | Minne: 256 kB ROM / 512 kB RAM | Bussbredd: 24 bit | Joystick: Tac2 | Operativsystem: Amiga OS 1.3

Visa signatur

Rigg: Intel i7 4790K @ 4,7 GHz delid | Noctua NH-U12S | Asus Z97-A | Corsair 2x4+2x8 GB 2133 MHz DDR3 RAM | EVGA RTX 2080 XC Ultra GPU | Intel SSD 2x 800 GB | Acer Predator XB271HU IPS skärm | M-Audio AV42 monitorer | HyperX Cloud 2-lurar | HyperX Pulsefire FPS mus

Visa signatur

MSI X99A GODLIKE GAMING | i7-6950X 4.3GHz | 64GB RAM 3200MHz | RTX 2080

Nintendo Switch | PlayStation 5 | Xbox Series X

Visa signatur

WS: i9 13900K - 128GB RAM - 6.5TB SSD - RTX 3090 24GB - LG C2 42" - W11 Pro

LAPTOP 1: Lenovo Gaming 3 - 8GB RAM - 512GB SSD - GTX 1650

LAPTOP 2: Acer Swift 3 - 8GB RAM - 512GB SSD

SERVER: i5 10400F - 64GB RAM - 44TB HDD

NALLE: Pixel 7 Pro

Visa signatur

13900KS | 32GB 6400 DDR5 | 4090 FE | Samsung G8 Oled

ASUS ROG Strix Z790-F Gaming | Fractal Torrent White | Corsair HX1200

Visa signatur

Ryzen 5900X @ Stock, MSI Suprim X 3080 @ game mode.

Visa signatur

ASUS ROG STRIX B450-F GAMING - AMD Ryzen 5 3600 3.6 GHz 35MB - Cooler Master - Hyper 212 Black Edition - Corsair 16GB (2x8GB) DDR4 3200Mhz CL16 Vengeance LPX - Kingston A2000 500GB M.2 NVMe - Fractal Design Define C Svart - 2 X Noctua NF-P14s redux-1200 140mm PWM - Corsair RM650X 650W v2 - ASUS GeForce GTX 1060 6GB DUAL OC - Raijintek Morpheus II Heatpipe VGA Cooler - 2 X Noctua NF-P12 120mm PWM - OS Debian 10 Stable

Visa signatur

Ryzen 9 5950X, 32GB 3600MHz CL16, SN850 500GB SN750 2TB, B550 ROG, 3090 24 GB

Har haft dessa GPUer: Tseng ET6000, Matrox M3D, 3DFX Voodoo 1-3, nVidia Riva 128, TNT, TNT2, Geforce 256 SDR+DDR, Geforce 2mx, 3, GT 8600m, GTX460 SLI, GTX580, GTX670 SLI, 1080 ti, 2080 ti, 3090 AMD Radeon 9200, 4850 CF, 6950@70, 6870 CF, 7850 CF, R9 390, R9 Nano, Vega 64, RX 6800 XT

Lista beg. priser GPUer ESD for dummies

Visa signatur

Visa signatur

Senast redigerat

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Senast redigerat