Fractal Design Define C, ASUS PRIME Z370-A

Intel Core i7 8700K 3.7 GHz 12MB

HyperX Predator DDR4 3200MHz 16GB( PC4-25600 CL16 16-18-18 )

Palit GTX 1070 TI, Samsung NVMe SSD 960 EVO M2

Seasonic Focus+ 750W 85+ GOLD PSU

Nvidia påstås utrusta grafikkort med 48 GB GDDR6X

Star citizen - swedish umbrella. En svensk union för er spelare och organisationer som tycker om demokratiska val.

https://robertsspaceindustries.com/orgs/SWEUMB

Discord:

https://discord.com/invite/j5AkGERJz3

AMD Ryzen 5800X | MSI RTX 3060 Ti Gaming X Trio | Cooler Master HAF 912 Plus

Phanteks P400A RGB : Asus Prime X570-P : Ryzen 9 5900X : Corsair H100X : 32GB G.Skill Trident Z Neo 3600CL14 : Sapphire Nitro+ 6800 XT : Xiaomi 34" Curved 3440x1440 : Playseat Evolution Alcantara : Thrustmaster T300RS GT / Ferrari SF1000 Edition Add-on : HP Reverb G2

AMD Ryzen 5800X | MSI RTX 3060 Ti Gaming X Trio | Cooler Master HAF 912 Plus

ASUS ROG STRIX Z790-E GAMING WiFi * I9-14900K

DDR5 64GB 6800 CL32 * NVIDIA RTX 3090 PNY XLR8 REVEL

Samsung NVMe M.2 990 PRO 2 TB & Samsung SATA 960 EVO 2 TB

Sound Blaster AE-7 * AW3423DW * Win 11 Pro

Ryzen 7800X3D, be quiet! pure rock 2, RTX 4070 Ti Super, Corsair 32GB 6000MHz CL36, Corsair TX850M

Fractal Design Define C, ASUS PRIME Z370-A

Intel Core i7 8700K 3.7 GHz 12MB

HyperX Predator DDR4 3200MHz 16GB( PC4-25600 CL16 16-18-18 )

Palit GTX 1070 TI, Samsung NVMe SSD 960 EVO M2

Seasonic Focus+ 750W 85+ GOLD PSU

7800x3d, 64GB 6000cl30, Gigabyte X670 Gaming X AX (F9d) 12TB m.2/nvme, 8TB SSD, WD 2x12TB 5400rpm, XFX 7900xt, SoundBlasterX AE-5+, HP X34", Fractal Design Define 7, Corsair HX750, Topping MX3s, Ino Audio piMx, Dan Clark Audio Aeon 2 closed..

LG B1 65", Topping e70, Topping pa5 II plus, Guru Audio Junior+ (primärt) / Canton GLE 90, Nintendo Switch OLED, Pico 4 VR

R < ROG G17 | R9 5900HX | 32GB 3200 MHz | RTX 3070 >

G < R9 5900X | 32GB 2666MHz | ROG RTX 3090 Ti >

B < RK96 | Leobog Hi75 | Deathadder V2 Pro >

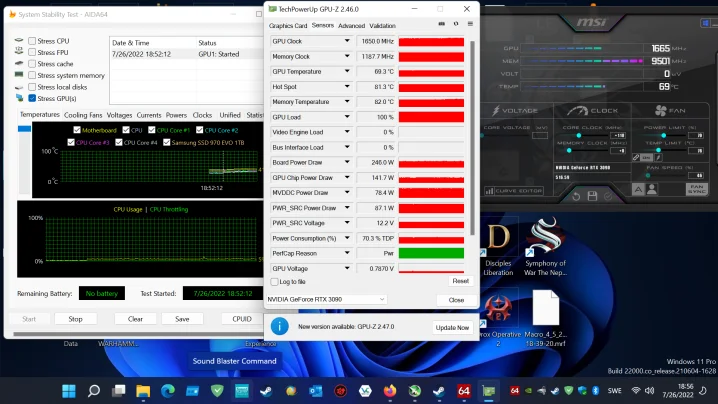

ASUS ROG STRIX Z790-E GAMING WiFi * I9-14900K

DDR5 64GB 6800 CL32 * NVIDIA RTX 3090 PNY XLR8 REVEL

Samsung NVMe M.2 990 PRO 2 TB & Samsung SATA 960 EVO 2 TB

Sound Blaster AE-7 * AW3423DW * Win 11 Pro

|AMD Ryzen 9 5900X| |ASUS ROG Strix B550-F| |Crucial Ballistix 32GB CL16@3600MHz| |PNY RTX 4090 XLR8 Gaming| |Samsung 990 Pro 2TB| |Samsung 970 Evo Plus 1TB| |Samsung 860 Evo 1TB| |Corsair RM1000| |Fractal Design Define R5| |LG OLED 48" C2 Evo|

Star citizen - swedish umbrella. En svensk union för er spelare och organisationer som tycker om demokratiska val.

https://robertsspaceindustries.com/orgs/SWEUMB

Discord:

https://discord.com/invite/j5AkGERJz3

SPELA: 13900K - Gaming X Trio 4090

LEVA: OnePlus 12 - MacBook Air M2 13"

PLÅTA: Canon C70, R3, 1DX mkII, BMPCC6K

LYSSNA: KRK Rokit RP8 G4, Beyerdynamic DT 1990 PRO

FLYGA: DJI FPV, Avata

Intel i5 12600k OC 5.2GHz | Arctic Freezer II 240 | MSI Pro Z690 A | 2x 16Gb Corsair LPX 3200MHz | Asus Tuf 4070 Ti | Corsair Rm850x V3 | 2x 1Tb Samsung 980 m2 | 7x Noctua A14x25

Asus ROG Strix B650E-F - AMD Ryzen 7 7800X3D - 32GB DDR5 - Galax RTX 4090 Hall Of Fame OC Lab - Corsair MP700 - WD Black SN850 - WD Black SN850X - Samsung QVO 870 - WD Black HDD - Noctua NH-U12A Chromax - Fractal Design Define 7 - Seasonic Prime Ultra Gold 1000W - Alienware AW3423DWF QD-OLED