AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

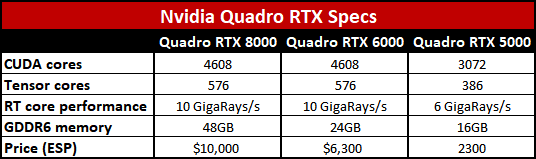

Nvidia tillkännager arkitekturen "Turing" med GDDR6-minne och fokus på ray tracing

Fractal Design Meshify 2 Compact w/ Dark Tint | Intel i5 12600K | Asus ROG Strix B660-F | 32 GB Corsair DDR5 5600 MHz CL36 | MSI Geforce RTX 3060 TI Ventus 2X OCV1 | 512 GB Samsung Pro 850 SSD + 2TB WD Black SN850 NVME PCI-E 4.0 | Corsair RM750X |

MSI X99A GODLIKE GAMING | i7-6950X 4.3GHz | 64GB RAM 3200MHz | RTX 2080

Nintendo Switch | PlayStation 5 | Xbox Series X

Ryzen 9 5950X, 32GB 3600MHz CL16, SN850 500GB SN750 2TB, B550 ROG, 3090 24 GB

Har haft dessa GPUer: Tseng ET6000, Matrox M3D, 3DFX Voodoo 1-3, nVidia Riva 128, TNT, TNT2, Geforce 256 SDR+DDR, Geforce 2mx, 3, GT 8600m, GTX460 SLI, GTX580, GTX670 SLI, 1080 ti, 2080 ti, 3090 AMD Radeon 9200, 4850 CF, 6950@70, 6870 CF, 7850 CF, R9 390, R9 Nano, Vega 64, RX 6800 XT

Lista beg. priser GPUer ESD for dummies

Intel i5 12600K | Asus TUF Gaming Z690-Plus D4 | Asus Geforce RTX 3060 Ti | 32 GB DDR4 | Fractal Design North | Corsair iCue Link H100i | Cooler Master V750 Gold i Multi

“Problems that remain persistently insoluble should always be suspected as questions asked in the wrong way.” ― Alan W. Watts

Fractal Design Meshify 2 Compact w/ Dark Tint | Intel i5 12600K | Asus ROG Strix B660-F | 32 GB Corsair DDR5 5600 MHz CL36 | MSI Geforce RTX 3060 TI Ventus 2X OCV1 | 512 GB Samsung Pro 850 SSD + 2TB WD Black SN850 NVME PCI-E 4.0 | Corsair RM750X |

My Rig https://classic.prisjakt.nu/list.php?ftg_check=on&exclude_ftg...

Fel av mig! Men sjutton vad snabba ni är på att kommentera vad andra gör och inte gör rätt och fel... :/

[Gigabyte EP35-DS4][Intel Core 2 Duo E8400 3.0 Ghz][2x2GB Corsair XMS 2][Gainward GTX 570][Sandisk Extreme II 480GB][Corsair HX 620W][Fractal Design Define XL R4][Acer GD245HQBID]

[AMD Ryzen 9 3900X] [ASUS GeForce RTX 2080 Ti] [LG OLED 55 C9 som skärm] [Samsung HW-Q96R till ljudet]