Observera att samma trivselregler gäller i kommentarstrådarna som i övriga forumet och att brott mot dessa kan leda till avstängning. Kontakta redaktionen om du vill uppmärksamma fel i artikeln eller framföra andra synpunkter.

Cinebench 2024 lanserat – testar återigen grafikprestanda

Visa signatur

Visa signatur

Huvuddator: 7800X3D, 2x16GB G.Skill Flare X5 6000MHz CL30, Asus B650E-F, KFA2 RTX 4090 SG, 6TB NVMe/SATA SSD, 42" LG OLED C3 Evo

Never fade away...

Folda för Sweclockers! https://www.sweclockers.com/forum/trad/1348460-faq-kom-igang-...

Visa signatur

Huvuddator: 7800X3D, 2x16GB G.Skill Flare X5 6000MHz CL30, Asus B650E-F, KFA2 RTX 4090 SG, 6TB NVMe/SATA SSD, 42" LG OLED C3 Evo

Never fade away...

Folda för Sweclockers! https://www.sweclockers.com/forum/trad/1348460-faq-kom-igang-...

Senast redigerat

Visa signatur

DATOR i bruk: ASUS ROG STRIX B550-F Gaming, Ryzen 7 5900X. 4x16 GB Ballistix MAX RGB @ 3800 MT/s 16-17-18-34-51 (1T)/~58 ns. MSI RTX 4090 Ventus x3. Samsung 980 Pro 1 TB. EK AIO Elite 360.

DATOR 2011 års modell: Underbara Sandy Bridge, i7 2600K@4,7 GHz på ett P67 Sabertooth-bräde. Radeon HD 7770

Visa signatur

Huvuddator: 7800X3D, 2x16GB G.Skill Flare X5 6000MHz CL30, Asus B650E-F, KFA2 RTX 4090 SG, 6TB NVMe/SATA SSD, 42" LG OLED C3 Evo

Never fade away...

Folda för Sweclockers! https://www.sweclockers.com/forum/trad/1348460-faq-kom-igang-...

Visa signatur

Huvuddator: 7800X3D, 2x16GB G.Skill Flare X5 6000MHz CL30, Asus B650E-F, KFA2 RTX 4090 SG, 6TB NVMe/SATA SSD, 42" LG OLED C3 Evo

Never fade away...

Folda för Sweclockers! https://www.sweclockers.com/forum/trad/1348460-faq-kom-igang-...

Visa signatur

DATOR i bruk: ASUS ROG STRIX B550-F Gaming, Ryzen 7 5900X. 4x16 GB Ballistix MAX RGB @ 3800 MT/s 16-17-18-34-51 (1T)/~58 ns. MSI RTX 4090 Ventus x3. Samsung 980 Pro 1 TB. EK AIO Elite 360.

DATOR 2011 års modell: Underbara Sandy Bridge, i7 2600K@4,7 GHz på ett P67 Sabertooth-bräde. Radeon HD 7770

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Visa signatur

Huvuddator: 7800X3D, 2x16GB G.Skill Flare X5 6000MHz CL30, Asus B650E-F, KFA2 RTX 4090 SG, 6TB NVMe/SATA SSD, 42" LG OLED C3 Evo

Never fade away...

Folda för Sweclockers! https://www.sweclockers.com/forum/trad/1348460-faq-kom-igang-...

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Visa signatur

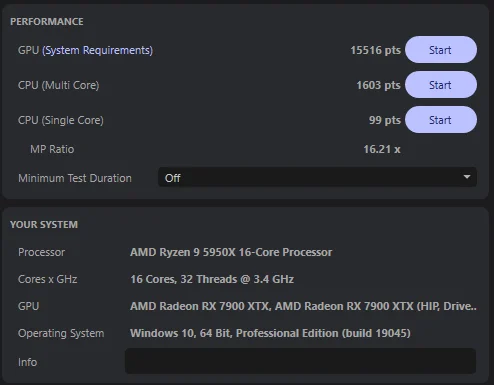

Intel i9-12900K | Asus STRIX Z690-I | 32 GB DDR5-6400 CL30 | AMD Radeon RX 7900 XTX | WD Black SN850 1 TB

Asus ROG Loki SFX-L 750W | SSUPD Meshlicious | Arctic Cooling Freezer II 280 | Alienware AW3423DWF

Visa signatur

DATOR i bruk: ASUS ROG STRIX B550-F Gaming, Ryzen 7 5900X. 4x16 GB Ballistix MAX RGB @ 3800 MT/s 16-17-18-34-51 (1T)/~58 ns. MSI RTX 4090 Ventus x3. Samsung 980 Pro 1 TB. EK AIO Elite 360.

DATOR 2011 års modell: Underbara Sandy Bridge, i7 2600K@4,7 GHz på ett P67 Sabertooth-bräde. Radeon HD 7770

Visa signatur

*5600|B350M-A|32GB|A750|GX750W|Core V21|280AIO|1TB+2TB.

AMD Ryzen 5(Zen3) @4891|Asus Prime|Corsair 2x16 RGB PRO 3200C16 @3800C18|Intel Arc LE @2740MHz|Seasonic Focus| Thermaltake mATX kub|Arctic freezer II| NVMe SSD PCIE 3.0x2 Kingston A1000 1500/1000 + 2,5" HDD Toshiba 1TB & Samsung 1TB i RAID 0.

Visa signatur

Huvuddator: 7800X3D, 2x16GB G.Skill Flare X5 6000MHz CL30, Asus B650E-F, KFA2 RTX 4090 SG, 6TB NVMe/SATA SSD, 42" LG OLED C3 Evo

Never fade away...

Folda för Sweclockers! https://www.sweclockers.com/forum/trad/1348460-faq-kom-igang-...

Visa signatur

i7-2700K 5 GHz | 16 GB DDR3-1600 | ASUS Maximus V Gene Z77 | GTX 980

i7-4790K 4.8 GHz | 32 GB DDR3-2133 | ASUS Maximus VII Gene Z97 | GTX 980

Visa signatur

Bärbar:Lenovo Legion Pro 7i 16 - Intel Core i9-14900HX - RTX 4080 12GB GDDR6 - 32 GB DDR5-5600MHz - 2x4TB M.2 SSD | LG UltraGear 38GN950 | Acer Predator XB271HU | Klipsch Reference R-51PM | Hifiman Sundara Stealth Revision | Shure MV7 | Glorious GMMK Pro | Logitech Pro X Superlight | Platta: Ipad 9th Gen | Nätverk: Unifi Dream Router

Twitch: https://www.twitch.tv/revolt_III

Visa signatur

Ryzen 7 7800X3D | MSI MAG B650 Tomahawk WiFi | G.Skill Trident Z5 Neo 2x16GB 6000MHz CL30 | Arctic Liquid Freezer II 360 | Sapphire Nitro+ 7900 XTX | WD Black SN850 2TB + Samsung 860 EVO 2x2TB | Corsair AX1000

Visa signatur

Intel i5 12600k OC 5.2GHz | Arctic Freezer II 240 | MSI Pro Z690 A | 2x 16Gb Corsair LPX 3200MHz | Asus Tuf 4070 Ti | Corsair Rm850x V3 | 2x 1Tb Samsung 980 m2 | 7x Noctua A14x25

Visa signatur

De du

Visa signatur

Huvuddator: 7800X3D, 2x16GB G.Skill Flare X5 6000MHz CL30, Asus B650E-F, KFA2 RTX 4090 SG, 6TB NVMe/SATA SSD, 42" LG OLED C3 Evo

Never fade away...

Folda för Sweclockers! https://www.sweclockers.com/forum/trad/1348460-faq-kom-igang-...

Visa signatur

Intel i9-12900K | Asus STRIX Z690-I | 32 GB DDR5-6400 CL30 | AMD Radeon RX 7900 XTX | WD Black SN850 1 TB

Asus ROG Loki SFX-L 750W | SSUPD Meshlicious | Arctic Cooling Freezer II 280 | Alienware AW3423DWF

Visa signatur

Intel i5 12600k OC 5.2GHz | Arctic Freezer II 240 | MSI Pro Z690 A | 2x 16Gb Corsair LPX 3200MHz | Asus Tuf 4070 Ti | Corsair Rm850x V3 | 2x 1Tb Samsung 980 m2 | 7x Noctua A14x25