Nej samma nivå är inte frågan men när folk pratar ner AC och vi redan ser 10% gain så blir man konfunderad. Hade nVidia eller AMD släppt en drivrutin som gav 10% gain så skulle det vara hyllat, nu när vi redan idag ser 10% (in best of cases) så pratar foilk som det är inget väsentligt.

Sen som sagt så vet vi inte vad som är aktiverat idag i dagens AC switchar i spel. Kan vara så att en del redan finns utanför AC switchen, typ köa upp i Copy que, och därför blir det svårt att isolera vad dagen effekt är.

Ok, låt oss säga att jag är mer positiv om vad AC kommer ge PC

Men såklart, du har inte fel i sak om konsol vs PC.

Fast det är till stor del motsägelsefullt då du sen säger att Compute är en del av Grafiken. ACE används flitigt för att ta emot och dela ut tasks till CUs och det är därför GCN har lyckats så bra i parallella syften där ACE står för dels fördelningen av resurserna, prioriteringarna, och switchningarna. Det är också tack vare ACE som tasks inte behöver tugga i väntan på att andra tasks blir klara utan de kan göras async. Detta kan, som du säger, användas för en del saker en CPU gör men idag finns det gått om uträkningar som ska göras parallellt med graphic ques där uppenbarligen ACE gör ett fenomenalt jobb.

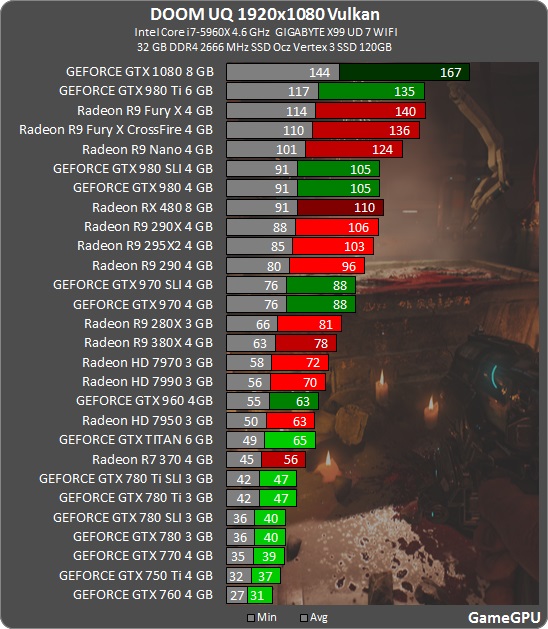

Kort och gott gör ACE i DX12 och Vulkan det som nVidia gör med drivrutiner i DX11, fördelar jobbet. Det är tack vare ACE strukturen som GCN är i Tier 3 och Maxwell i Tier 2:

https://msdn.microsoft.com/en-us/library/dn899127(v=vs.85).as...

Nej, ACEär med och tar emot kommandona och delar ut den till CU (grafikkortet engines). Det är uppsättningen ACE + GPC som ser till att kommandona fördelas ut, hållas koll på och prioriteras till CU. CU gör bara beräkningarna men har absolut noll koll varför den gör det eller riktigt vad den räknar. Man måste se det som att typ lägga pussel, CPU skickar kommandon hur varje bit ska ligga samtidigt (parallellt) och ACE prioriterar upp hur man gör det effektivt och just parallellt. Typ börja med kanterna på pusslet (Prioritera), en del CU ska organisera bitar och en del ska lägga bitar (Fördelningen). Varje individuell CU jobbar men det vet inte med vad, det är ACE som vet att CPUn vill ha ett färdigt pussel i slutändan när det når pipen.

Allt måste köas, oavsett vad det handlar om så det är ganska självklart att hur köer hanteras och hur många köer som kan hanteras är ganska vitalt.

Det du länkar till bekräftar det. Poängen men DX12 är också att du flyttar över "kontrollen" av vad Draw Calls ska leda till från CPU/Drivrutiner till GPUn, men någon på andra sidan måste fortfarande lösa biffen.

Lite om hur Compute kan användas/användas för maximera pipen bättre finns här:

http://www.slideshare.net/gwihlidal/optimizing-the-graphics-p...

Det är också därför du ser direkta gains på CGN med de nya APIerna mot DX11, gains som inte nVidia får. nVidia har som sagt använt Drivurtiner och extra CPU trådar för att recompila jobben till sina "engines".

Still, ACE är med i jobbet att fördela ut, prioritera, omprioritera och resursfördela dessa kommandon till CUs. Så ja det är helt rätt men ja det är till stor del tack vare hur CGN jobbar med ACE.

Det enda jag har sagt hela tiden är att ACE är med för att se till att GPUn kan jobba med parallella tasks och är med och hanterar vad som går in i CU delen. Det du nämner om och om ovanför är bara bekräftelser men jag får känslan av att du tror CPUn skickar direkt till CU och ACE ligger "vid sidan om"?