Fast det behöver inte vara cpun som är orsaken till den låga prestandan, det nya heta spåret är att nvidia korten helt enkelt inte presterar fullt ut på Ryzen.

Sen ang simspel, jag har kört med 6700/3770k och du kan i dem spelen göra att det blir stutterfest om du belastar spelen med fler bilar, det händer inte med äldre 8kärniga Xeon sandybride cpu.

Forza e inte sim

Jag har själv testat, i mitt fall var det så här:

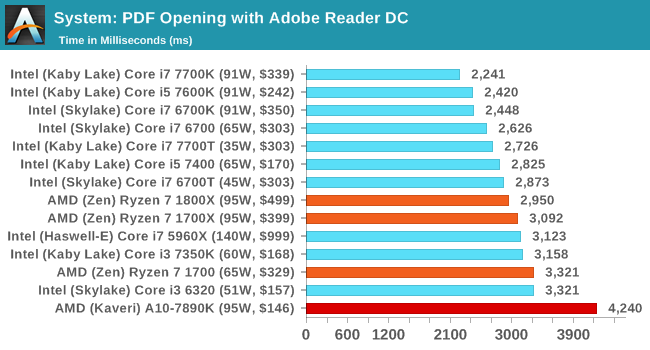

Med tanke på att Core 0 är belastad till 100% i båda fallen, FPS är låst till 60 och grafikkortet i inget av fallen var över 60% usage var det just den enkeltrådiga prestandan som var begränsande faktor, det är väl ingen hemlighet att en 7700K har 20-30% bättre enkeltrådig prestanda? Ryzen pendlade mellan att harva kring 50-54, med drops ner till 30 och peakar på 59-60. 7700K ligger stensäkert på 60, någon gång flimrade 59 förbi. Med min förra CPU, 4690K, låg jag mellan 50-60 relativt konstant. Samma grafikkort alla tre gånger, och ändring av grafikinställningar påverkade inte ett jota.

Och nej, Forza är ingen realistisk simulator, men det använder sig likväl av samma modell som en, dvs. ganska så tunga fysikuträkningar för hur bilen skall bete sig, och förmodligen är det det som ligger på Core0 och tuggar.

Är spelet dåligt optimerat, har Ryzen mer samlad prestanda om man räknar samlad prestanda över alla cores? Svar ja.

Kan andra spel med denna typ av fysikmotorer ha varit förutseende och optimerat för fler trådar? Svar ja.

Faktum kvarstår, den absoluta majoriteten av spel är optimerade för att köras i få trådar på högpresterande kärnor, och ingen vet när, eller om det ens sker inom rimlig tid, spelen kommer optimeras för flera lågpresterande kärnor. Det känns rimligt att det måste ske snart, då det känns som att tillverkarna börjar få svårt att komma ner i transistortäthet, och klockfrekvenserna ligger så pass högt redan, men någon fast tidsplan ligger inte direkt...