Observera att samma trivselregler gäller i kommentarstrådarna som i övriga forumet och att brott mot dessa kan leda till avstängning. Kontakta redaktionen om du vill uppmärksamma fel i artikeln eller framföra andra synpunkter.

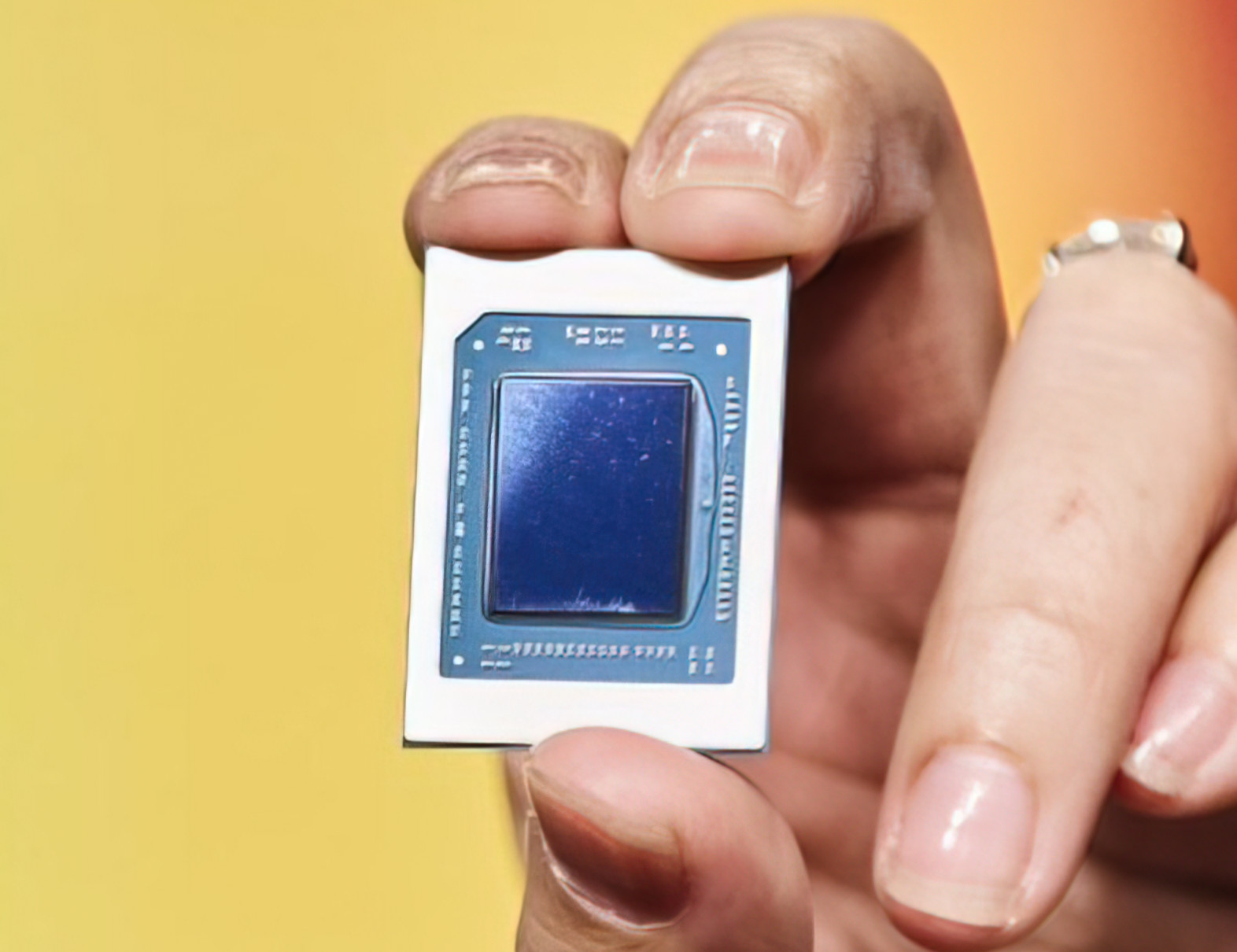

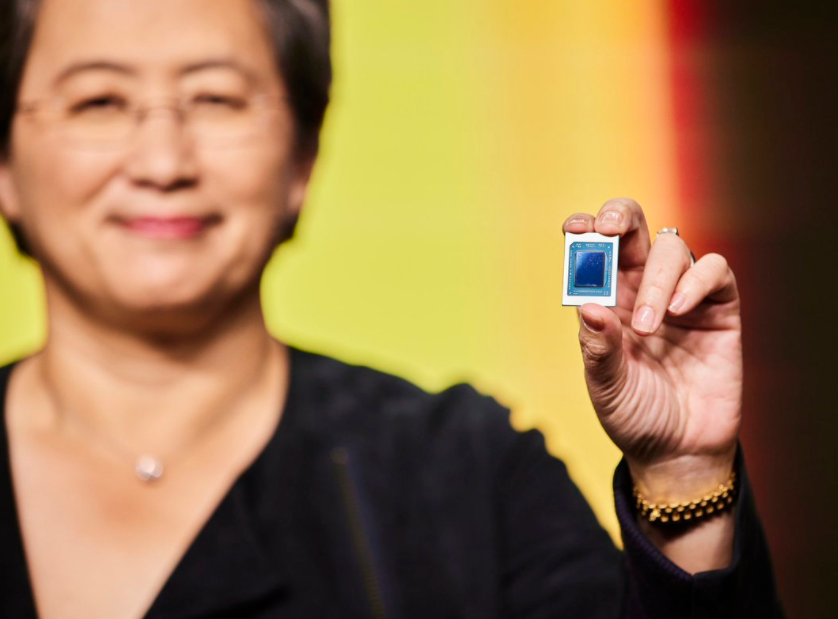

Stort lyft i grafikprestanda med AMD:s Ryzen 6000 för bärbara datorer

Visa signatur

Senast redigerat

Visa signatur

AMD Thunderbird 1.33 GHz (133 MHz Bus), Epox 8K7A, 1 x 256MB Corsair PC2100 DDR SDRAM, 20.5GB 7200 RPM Western Digital EIDE, Visiontek GeForce 3

Visa signatur

AMD Ryzen 7 5800X3D | EVGA GeForce RTX 3080 10GB FTW3 ULTRA | ASUS ROG Strix B450-F Gaming | Corsair RM750X V2 | Crucial Ballistix Sport LT 3200MHz 16GB | Samsung 980 Pro 1TB | Crucial MX500 2TB | NZXT H500

Senast redigerat

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Senast redigerat

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Visa signatur

R5 5600G, Asus ROG STRIX X470-F Gaming, WD SN850X 2TB, Seasonic Focus+ Gold 650W, Aerocool Graphite v3, Tittar på en Acer ET430Kbmiippx 43" 4K. Lyssnar på Behringer DCX2496, Truth B3031A, Truth B2092A. Har också oscilloskop, mätmikrofon och colorimeter.

Visa signatur

R5 5600G, Asus ROG STRIX X470-F Gaming, WD SN850X 2TB, Seasonic Focus+ Gold 650W, Aerocool Graphite v3, Tittar på en Acer ET430Kbmiippx 43" 4K. Lyssnar på Behringer DCX2496, Truth B3031A, Truth B2092A. Har också oscilloskop, mätmikrofon och colorimeter.

Visa signatur

Lian-Li Tu150 (fläktmoddad) w Corsair SF750 Platinum SFX / Asus Strix B550-i Itx / Ryzen 5600x @ 4.92.. Scythe Fuma 2 / Crucial Ballistix 2x16 3600@4000 / WD Black SN850 NVME + Kingston A2000 NVME / MSI Radeon RX 6800 referens / 2x120mm Noctua NF-A12x15 golv. 2x120mm Noctua NF A12x25 In och Utblås. Fläktmod tak 1x140mm Noctua NF A14 utlblås via kammare baktill. Samsung 34" c34j791 3440x1440.

Senast redigerat

Visa signatur

Ryzen 5800X ROG STRIX X570-f GAMING FlareX DDR43600 cl 14-14-14-34 EVGA FTW3 Ultra RTX 3090

Visa signatur

"The irony of the Information Age is that it has given new respectability to uninformed opinion."