AMD Ryzen 7 9800X3D 5.4Ghz +NH-D15 Chromax

MSI RTX 5080 Gaming Trio OC 3390mhz

Asus ROG Strix X870-F Gaming WIFI

Corsair Dominator Platinum 6200mhz 32GB CL36

Samsung G9 49”/240hz, NZXT H9 Flow, Corsair RM850X ATX 3.1

Rykte: Nvidia Geforce RTX 4090 slukar 600 watt

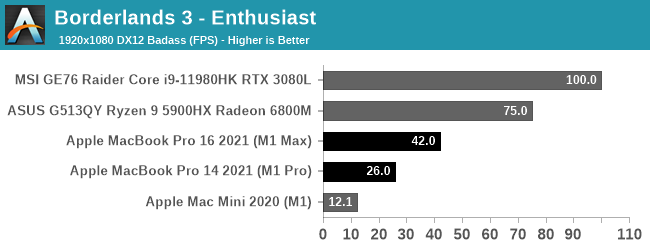

Laptop 1: MB Pro m1

Laptop 2: MSI GT73VR TITAN

PC: gtx 1070 - 4770k

Asus ROG STRIX B550-F / Ryzen 5800X3D / 48 GB 3200 MHz CL14 / Asus TUF 3080 OC / WD SN850 1 TB, Kingston NV1 2 TB + NAS / Corsair RM650x V3 / Acer XB271HU (1440p165) / LG C1 55"

NAS: 6700K/16GB/Debian+ZFS | Backup (offsite): 9600K/16GB/Debian+ZFS

Asus ROG STRIX B550-F / Ryzen 5800X3D / 48 GB 3200 MHz CL14 / Asus TUF 3080 OC / WD SN850 1 TB, Kingston NV1 2 TB + NAS / Corsair RM650x V3 / Acer XB271HU (1440p165) / LG C1 55"

NAS: 6700K/16GB/Debian+ZFS | Backup (offsite): 9600K/16GB/Debian+ZFS

Ryzen 5800X ROG STRIX X570-f GAMING FlareX DDR43600 cl 14-14-14-34 EVGA FTW3 Ultra RTX 3090

GTX 260 SC | GTX 280 SLI | GTX 280 Tri SLi | GTX 590 Quad SLi | GTX 980 ti | RTX 2080 Ti Strix OC | RTX 3090 Strix OC | RTX 4090 Strix OC

The Way It's Meant to be Played|NVIDIA

ASUS MAXIMUS Z790 APEX Encore | i9-14900KS (delidded/direct-die) | 2x24GB G.Skill 8000 M-die | Corsair AX1600i | Samsung 990 PRO 4TB | Corsair 7000D Airflow | 15x Corsair ML Pros (8x ML120 Pro, 7x ML140 Pro) | Rads 360+360+420 | LG C3 48" 120Hz

Ryzen 5800X ROG STRIX X570-f GAMING FlareX DDR43600 cl 14-14-14-34 EVGA FTW3 Ultra RTX 3090

“When a clown moves into a palace he doesn’t become a king, the palace instead becomes a circus.”

Lätt som Paj

*5800X|B550M|64GB|RX7800XT|GX750W|Core V21|280AIO|2TB+2TB|1440p 240Hz

AMD Ryzen 7 @4,95GHz|Gigabyte Aorus Elite(rev1.3)|Corsair 2x32 LPX Vengeance 2666C16 @3600C20|Asus DUAL OC @990mV, 3,2/2,6GHz|Seasonic Focus| Thermaltake mATX kub|Arctic freezer II| NVMe SSD PCIE 4.0x4 Samsung 980 Pro 7000/5100 + 2,5" HDD Toshiba 1TB & Seagate 1TB i RAID 0|Acer Nitro XV272Uz 27" IPS 270Hz @240Hz.

Asus ROG STRIX B550-F / Ryzen 5800X3D / 48 GB 3200 MHz CL14 / Asus TUF 3080 OC / WD SN850 1 TB, Kingston NV1 2 TB + NAS / Corsair RM650x V3 / Acer XB271HU (1440p165) / LG C1 55"

NAS: 6700K/16GB/Debian+ZFS | Backup (offsite): 9600K/16GB/Debian+ZFS

[AMD Ryzen 9 9950X][Gigabyte X870E Aorus Elite][G.Skill Trident Z5 NEO DDR5 6400Mhz 32GB CL-32-39-39-102][ASUS GeForce RTX 3090 ROG Strix OC][Samsung 990 PRO M.2 NVMe SSD 2TB, Seagate FireCuda Gaming Hub 16TB][Noctua NH-D15 chromax.black][Corsair AX1600i][Xigmatek Elysium][Samsung S27B970D]

My Rig https://classic.prisjakt.nu/list.php?ftg_check=on&exclude_ftg...

Fel av mig! Men sjutton vad snabba ni är på att kommentera vad andra gör och inte gör rätt och fel... :/

Krusidullen är stulen

CPU: 5900x. Mem:64GB@3200 16-17-17-34-1T. (ImDIsk)

GPU: 1080 Ti@ca 6-7%OC. Sound: SB-Z -> toslink (DTS)-> old JVC. MB Realtek to Z-2300 for VOIP.

AMD Ryzen 7 9800X3D 5.4Ghz +NH-D15 Chromax

MSI RTX 5080 Gaming Trio OC 3390mhz

Asus ROG Strix X870-F Gaming WIFI

Corsair Dominator Platinum 6200mhz 32GB CL36

Samsung G9 49”/240hz, NZXT H9 Flow, Corsair RM850X ATX 3.1

f0rest stan | Citera mera | Ryzen 9600X - ASUS Prime 9070 XT

CPU: 5900x. Mem:64GB@3200 16-17-17-34-1T. (ImDIsk)

GPU: 1080 Ti@ca 6-7%OC. Sound: SB-Z -> toslink (DTS)-> old JVC. MB Realtek to Z-2300 for VOIP.

CPU: 5900x. Mem:64GB@3200 16-17-17-34-1T. (ImDIsk)

GPU: 1080 Ti@ca 6-7%OC. Sound: SB-Z -> toslink (DTS)-> old JVC. MB Realtek to Z-2300 for VOIP.