Skrivet av AMDDDDD:

Hur kommer man ikapp AMD om man betalar 6300 för en propp kontra 3300? Hur är nästan dubbla priset justified när det är max 20% i prestandaskillnad?

Nu finns, hör och häpna, det en och annan som använder CPUn för annat än spel. Men om vi bara håller oss till spelprestanda och plockar bort GPU-delen ur ekvationen så var det inte någon "max 20%" i SweClockers 9900K test av spel.

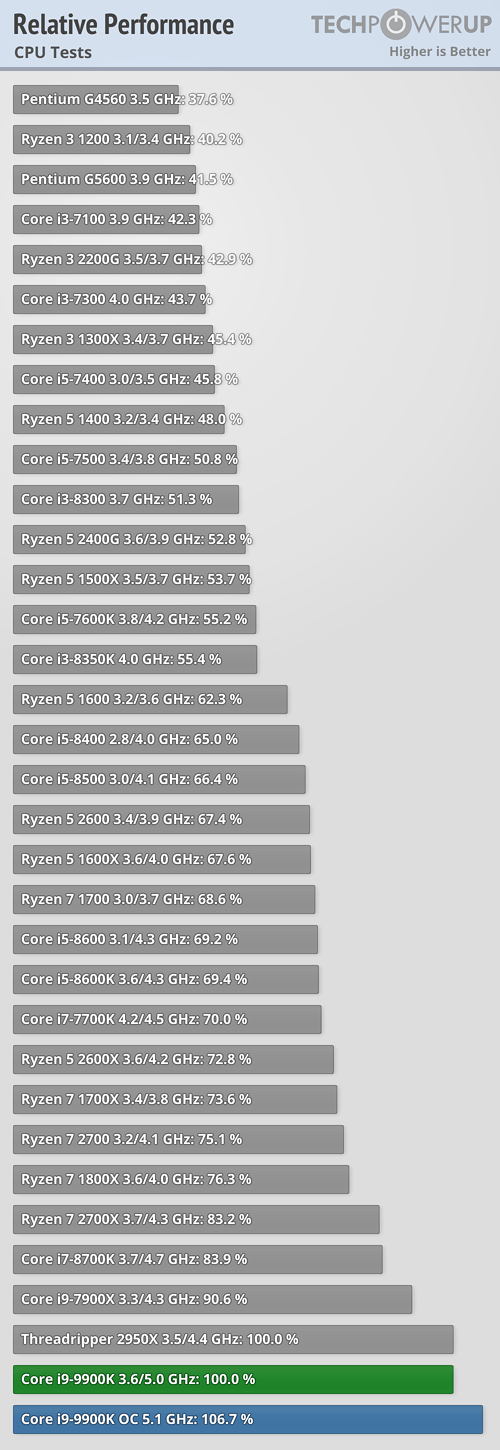

Redan i7-8700K var i genomsnitt 25 % snabbare och som mest 31 % snabbare jämfört med 2700X. i9-9900K var 35 % snabbare i genomsnitt och som mest 42 % snabbare.

Ja, det var i 720p med RTX 2080 Ti. Men innan någon opponerar sig mot "ingen använder ju den upplösningen" så är det bra att hålla i bakhuvudet att spel (när det inte är GPU-bundna), likt majoriteten av alla applikationer vi kör på skrivbordet, är primärt begränsade av heltalsprestanda.

Nu för tiden är också spel bättre på att dra nytta av CPU-kärnor är normalapplikationen. För den typiske datoranvändaren är (och lär så förbli) den viktigaste egenskapen: vilken prestanda får mitt system i heltalsberäkningar som pågår i relativt kort tid (tiotals sekunder) när några få CPU-kärnor är lastade.

Skrivet av pv2b:

Kriget över kärnantal är egentligen rätt märkligt och lustigt att se.

AMD designar en enda arkitektur som ska skala ner ända från en 2C/4T upp till monster med över hundra trådar. Detta med Infinity Fabric som gör deras design modulär och skalbar. AMD:s styrka med deras arkitektur är just att de kan skala antalet kärnor på ett väldigt kostnadseffektivt sätt, särskilt med chiplets, medan Intels motsvarande arkitektur blir mycket dyrare eftersom de måste trycka in flera kärnor på större och större kiselbrickor...

Samtidigt som Intel har processproblem så provocerar AMD att Intel gör större och större CPU:er. Som blir dyrare och dyrare, vilket ytterligare spär på AMD:s fördelar i pris.

Det här är inget annat än Intel som faller på sitt eget grepp. AMD tvingar in dem i en konkurrens i ett område som Intel inte är bra på. Till vilken nytta, egentligen?

Det finns ju en gräns till hur många kärnor en dator behöver innan man bara lägger på kärnor bara för att. Med det sagt så är det ju sjukt trevligt att vi inte sitter och bygger datorer med 4C/4T idag.

AMD tillverkar väl ändå två kretsar just nu. En med 4 kärnor + iGPU samt en med 8 kärnor (2x CCX med fyra kärnor var).

Hur är det att "skala" om man alltid är tvungen att ta till en krets som idag är >200 mm²? Framförallt när den direkta konkurrenten får in 8C + iGPU på <180 mm² samt klarar sig på 100 mm² om det handlar om 2C modeller.

Att ha få kretsar har en uppenbar fördel: det är en stor engångskostnad associerad med varje kretsdesign. Nyckelordet där är "engångskostnad". Det finns alltid en volym enheter när det kommer vara bättre att dela upp sina SKUs på flera kretsar. Denna volym bestäms av hur mycket billigare det är att tillverka en skräddarsydd krets med färre kärnor jämfört med att stänga av kärnor på en större modell.

Både AMD och Intel använder sig just nu av extremt vältrimmade tillverkningsprocesser. Tar man 2C + iGPU och använder denna utbyteskalkylator så får man att med 300 mm "våfflor" och 0,1 defekter per cm² får Intel ett utbyte på 90 % (totalt 512 kretsar) medan AMD får ett utbyte på 81 % (totalt 212). D.v.s. i detta fall ger Intels skräddarsydda 2C+iGPU lösning 2,4 gånger fler kretsar per "våffla".

Har ändrat åsikt kring kärnornas krig. Tyckte initialt det var öken för vore rätt kontraproduktivt för desktop om man började prioritera fler kärnor, fast på bekostnad av lägre prestanda per kärna.

Nu verkar både AMD och Intel ändå lärt sig av Intels tidigare HEDT-serier där prestanda för normalanvändaren i praktiken var sämre med den dyrare HEDT-plattformen p.g.a. lägre prestanda per kärna. Det som i stället fått stryka på foten är energieffektivitet, ett mindre problem för en stationär dator kanske... Men det kritiska här är att man ser till att i alla fall inte minska enkeltrådprestanda i sin jakt på fler kärnor, helt rätt prioriterat för desktop!

Det andra som gjort att jag ändrat åsikt kring detta krig är: om det verkligen blir ett race mot väldigt många kärnor kommer vi äntligen få se x86 gå i graven. Det är en design som överlevt sig själv lite väl många gånger nu.

Orsak: när man börjar skruva upp antalet kärnor kombinerat med att Moores lag i praktiken är död så förstärks kraftigt nackdelarna som finns med x86 som har extremt mycket skräp i bagaget och som får offra rejält med transistorer för att kompensera för en del riktigt dåliga designbeslut för multicore som inte kan ändras utan att bryta bakåt kompatibilitet.

Apples senaste CPU har ~50 % högre IPC jämfört med Intel, Ipad Pro har numera mer CPU-råkraft än vad allt utanför "släpbara" x86-laptops mäktar med.

Både Cavium (ThunderX2) och sedan ungefär en månad tillbaka även Ampere (eMAG) har 32-kärnor server ARMs med IPC på x86 nivå. Dessa kostar <$1000, har 32-kärnor (ThunderX2 har 128 trådar) och det är på 14/16 nm. Men prestanda då? Dessa matchar Intel/AMD väldigt väl, ThunderX2 är trots allt vad Cray just nu bygger sin toppmodell med!

För ett par månader sedan gick ARM själva ut med nyheten att man kommer ge sig in både på desktop-marknaden och även servermarknaden, d.v.s. man kommer designa CPU-modeller specifikt för dessa områden (och inte bara stoppa in mobil CPUer i en laptop som var fallet i de Win10 ARM-laptops som lanserades i våras). AnandTech har tittat lite på desktop-versionen, den överträffade till och med deras gissningar på IPC vilket betyder att man nu är helt ikapp AMD/Intel på den punkten.

Huawei är ett av företagen som kommer använda sig av server-designen, första produkten blir en monolitisk 64-kärnors CPU med skalbarhet upp till 4S. Att man tillverkar denna på TSMCs 7 nm process pekar på att det ändå inte är någon gigantisk krets.

Även Intel går mot MCM, men MCM är något man tar till när man inte kommer längre på andra sätt. En monolitisk 64-kärnors CPU kommer vara väsentligt snabbare i en rad arbetsuppgifter jämfört med en 64-kärnors MCM. Det är normalt ~10x högre bandbredd och 2-5 gånger längre latens inom en krets än mellan kretsar, så alla laster som har nytta av dessa egenskaper kommer kraftigt föredra den monolitiska designen.

Skrivet av pv2b:

3 GHz är väl inte en "serverklocka", det är ju där de flesta konsument-CPU:er ligger? Om vi inte tittar på de lite mer entusiastinriktade CPU-er med K och X i modellnamnen.

3 GHz är väl ändå rätt långt då även bärbara i3 och i5 nu ligger runt 4 GHz strecken i maxfrekvens? Den 28 W TDP NUC jag använder som primärsystem för tillfället maxar på 4,5 GHz (och faktum är att den är snabbare på rätt många frekvent förekommande moment för mig som programutvecklare än både min 2700X och jobbets nya dual Xeon 6140 Gold byggserver som ändå boostar till 3,7 GHz).

GB4 jämförelse mellan i7-8559U (som presterar i stort sett identiskt med i7-7700K i enkeltrådat) och 2700X, vad tror du ger mest för normalanvändaren: 20 % högre enkeltrådprestanda för heltalsberäkningar eller 60 % högre multitrådprestanda för heltalalsberäkningar?

Att AMD jobbat på SIMD-prestanda (vilket är orsaken till deras "dubbla flyttalsprestanda") är väldigt bra, detta har snabbt blivit väldigt viktigt och ju mer maskininlärning används ju viktigare kommer detta att bli (även om just maskininlärning också använder SIMD för heltal, men även det lär AMD ha dubblat sin prestanda i).

Men på skrivbordet är alla former av flyttalsintensiva program nischer. De är viktiga för vissa personer, kör själv väldigt mycket som beror av just flyttals SIMD-prestanda, men det är på det stora hela rätt smala nischer. Det enda som spelar en relevant roll i t.ex. spel, eller programutveckling som jag håller på med, är prestanda för heltalsberäkningar (något som 64-bitars ARM kommer kliva förbi x86 på, man är redan ikapp och förbi i IPC, men efter i frekvens än så länge).

Skrivet av Ozzed:

Det radikala som händer är att AMD börjar använda chiplets, vilket gör att det blir mycket billigare per kärna, samt att IMC och IO kan läggas på en separat krets, så jag tror inte att priset kommer sticka iväg på AMD, men prestanda per kärna lär få sig ett rejält lyft i och med att de tillverkas på en separat 7nm-wafer medans IMC och IO ligger kvar på 14. Ska intel svara på det med en molotitisk design lär de få stora problem med dålig yield.

Hur är det radikalt? Både IBM och även Intel har gjort liknande saker tidigare.

IBM har flera CPU-kretsar (som förövrigt officiellt kört på 5,2 GHz på 65 nm) kopplade till en I/O-krets i vissa av sina mainframe designer. Nuvarande POWER8/POWER9 finns i två varianter, en med minneskontroller integrerad i CPU och en med extern minneskontroller (som även innehåller en massiv L4 eDRAM cache, vilken det även spekuleras AMD kommer använda). Man har båda varianterna då de är lämpliga till olika saker, en extern minneskontroller ökar latensen vilket är negativt för vissa laster.

Intels variant i detta är kanske inte lika uppenbar, men det är Arrandale. Intel han aldrig integrera en GPU i Westmere för mobila enheter så lösning blev en separat krets som innehåll minneskontroller, iGPU samt I/O.

Fungerade riktigt bra, men ställer man en likvärdigt klockad Nehalem eller Westmere mot Arrandale så ser man att många applikationer presterar likvärdigt men finns de som presterar klart bättre med Nehalem/Westmere och deras integrerade minneskontroller.

Ja, det är en billigare lösning. Men det är inte en lösning helt utan nackdelar sett till prestanda och strömförbrukning. Huvudvärken för både AMD och Intel (som lanserat Cascade Lake AP som är en MCM) är att 64-bitars ARM börjar riktigt få snurr på sakerna för servers och där är det fortfarande fullt möjligt att tillverka monolitiska kretsar som matchar vad x86 nissarna planerar med MCM. ARM förväntar sig upp till 96 kärnor per monolitisk krets på 7 nm (vet inte hur man kom fram till just "96" och inte ~100 men det var är vad man sagt)!!!