R7 5800X3D / RTX 4070 / 32GB Ram / 1 + 2 TB M.2 SSD / X570 Bräda / 850w Nätagg.

32 Tums Skärm 1440p 144hz Curved VA panel.

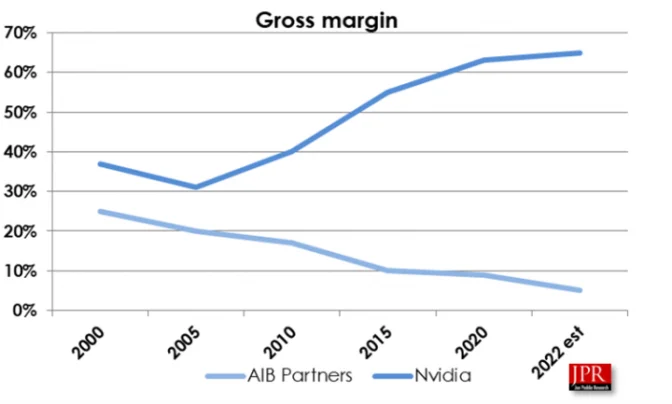

Nvidia prisjusterar Geforce RTX 4000-serien i Europa

WS: i9 13900K - 128GB RAM - 6.5TB SSD - RTX 3090 24GB - LG C2 42" - W11 Pro

LAPTOP 1: Lenovo Thinkpad E14 G5 - 16GB RAM - 512GB SSD

LAPTOP 2: Acer Swift 3 - 8GB RAM - 512GB SSD

SERVER: i5 10400F - 64GB RAM - 44TB HDD

NALLE: Pixel 9 Pro XL

CPU: i9-13900K + Cooler Master ML360L ARGB V2 || GPU: Gainward RTX 4090 Phantom GS.

MoBo: Asus Rog Strix Z790-F Gaming || RAM 32 GB Kingston Fury Beast CL40 DDR5 RGB 5600 MHz.

PSU: Corsair RMe 1000W 80+ Gold || Chassi: Phanteks Eclipse P500A D-RGB.

Lagring: Kingston Fury Renegade M.2 NVME 2TB + Samsung 860 QVO 1TB.

Skärmar: 27" 1440p 144 Hz IPS G-sync + 27" 1440p 155 Hz VA || OS: Win 11 Home.

14900K

5080

5070 Ti

9070 XT

3070

Jag äger minst en databehandlingsmaskin.

|Workstation: AMD Ryzen 9 7900X 4.7GHz | ASRock X670E | AMD Radeon 7900 XT | 32GB DDR5 | NVMe 2.0TB | HDD 4.0TB |

|Fedora Srv VM Host: AMD Threadripper 2920x | ASUS PRIME X399-A | 24GB DDR4 | 10TB Storage |

|HTPC: AMD Ryzen 3 2200G 3.7 GHz | Gigabyte B450M DS3H | Radeon Vega 8 | 8GB RAM | SSD 120GB | *Test rig för div Linux distar, drivers m.m.

|Workstation: AMD Ryzen 9 7900X 4.7GHz | ASRock X670E | AMD Radeon 7900 XT | 32GB DDR5 | NVMe 2.0TB | HDD 4.0TB |

|Fedora Srv VM Host: AMD Threadripper 2920x | ASUS PRIME X399-A | 24GB DDR4 | 10TB Storage |

|HTPC: AMD Ryzen 3 2200G 3.7 GHz | Gigabyte B450M DS3H | Radeon Vega 8 | 8GB RAM | SSD 120GB | *Test rig för div Linux distar, drivers m.m.

Intel i5 12600k OC 5.2GHz | Arctic Freezer II 240 | MSI Pro Z690 A | 2x 16Gb Corsair LPX 3200MHz | Asus Tuf 4070 Ti | Corsair Rm850x V3 | 2x 1Tb Samsung 980 m2 | 4x Noctua A14x25 2xT30, 1x Noctua A12x25, 3x ek loop

Moderkort: Gigabyte X570 AORUS MASTER rev 1.2 Processor: AMD Ryzen 7 5800X3D Kylning: Corsair be quiet! Dark Rock Pro 4 Minne: 32 GB Crucial Ballistix 3600 MHz Grafikkort: AMD Radeon™ RX 9070 XT Taichi 16GB OC Hårddiskar: Corsair Force MP600 1TB M.2, Seagate BarraCuda 4TB 5400rpm Nätagg: Corsair RM850x V2 Chassi: Fractal Meshify 2 Compact Skärm: LG C3 77 tums TV

Intel i5 12600k OC 5.2GHz | Arctic Freezer II 240 | MSI Pro Z690 A | 2x 16Gb Corsair LPX 3200MHz | Asus Tuf 4070 Ti | Corsair Rm850x V3 | 2x 1Tb Samsung 980 m2 | 4x Noctua A14x25 2xT30, 1x Noctua A12x25, 3x ek loop

Intel i5 12600k OC 5.2GHz | Arctic Freezer II 240 | MSI Pro Z690 A | 2x 16Gb Corsair LPX 3200MHz | Asus Tuf 4070 Ti | Corsair Rm850x V3 | 2x 1Tb Samsung 980 m2 | 4x Noctua A14x25 2xT30, 1x Noctua A12x25, 3x ek loop

Dator 1: AMD Ryzen 9 7950X3D, 64 GB Kingston Fury DDR5 5600 MHz CL36 , Asus Radeon 7900XTX TUF OC, Be Quiet Dark Base Pro 900 rev.2 Black Case, Asus ROG Crosshair X670E Hero Mobo , Be Quiet 1500W PSU, Win11 Pro 64-bit, Creative Soundblaster AE7

Dator 2: Intel Core i7 9700k, 32GB DDR4 Corsair 3000 MHz, Asus TUF Z390 Mobo, Asus Radeon 6800 XT TUF, Be Quiet 850 PSU, Win10 Pro 64-bit, Asus TUF GT502 Case

[Gigabyte EP35-DS4][Intel Core 2 Duo E8400 3.0 Ghz][2x2GB Corsair XMS 2][Gainward GTX 570][Sandisk Extreme II 480GB][Corsair HX 620W][Fractal Design Define XL R4][Acer GD245HQBID]

Intel i5 12600k OC 5.2GHz | Arctic Freezer II 240 | MSI Pro Z690 A | 2x 16Gb Corsair LPX 3200MHz | Asus Tuf 4070 Ti | Corsair Rm850x V3 | 2x 1Tb Samsung 980 m2 | 4x Noctua A14x25 2xT30, 1x Noctua A12x25, 3x ek loop

Intel i5 12600k OC 5.2GHz | Arctic Freezer II 240 | MSI Pro Z690 A | 2x 16Gb Corsair LPX 3200MHz | Asus Tuf 4070 Ti | Corsair Rm850x V3 | 2x 1Tb Samsung 980 m2 | 4x Noctua A14x25 2xT30, 1x Noctua A12x25, 3x ek loop

Rigg: Corsair Carbide Air 540 | Gigabyte X570 Elite | R7 3700X | Corsair Hydro H70 V1 | 16 GB G.Skill RGB CL16@3200 MHz | Powercolor RX7900 XTX Red Devil | Samsung EVO 960/500 GB | Samsung QVO 870 8TB | Corsair AX860 | Ljud: Monitor Audio GS20 Frontar | Monitor Audio GSLCR Center | KEF Q7 Surround | Epik Legend Subwoofer | Denon 2310 Reciever

7900xtx och 7800x3d är min setup. Så nu vet ni det om jag kritiserar AMD ibland.