Skrivet av Buddaz112:

Inte för att vara den. Skall de också införa samma skitkontakt som är ett skämt på hög nivå.

Jaha HBM var inte bra när AMD körde det och nu påstår Intel att de är bäst med samma minne standard.

Det finns fördelar och nackdelar med olika teknikval, i fallet HBM är det ändå bra att AMD testade tekniken i konsumentprodukter. Slutsatsen blev att för konsumentprodukter väger nackdelarna (högt pris) tyngre än fördelarna (väldigt bra perf/W och exceptionellt hög bandbredd).

Intel, Nvidia och AMD använder alla HBM för datacenter GPUer. För dessa överväger fördelarna med HBM. Dessa GPUer är så stora och krävande att andra minnestekniker inte kan leverera tillräckligt med prestanda och/eller effektbudgeten skulle sprängas för att nå motsvarande bandbredd med GDDR.

Skrivet av Dem8n:

Kul för Intel antar jag, jag äger dock inget datacenter, vad betyder denna nyhet för mig, någon som kan förklara?

Någon här som äger ett?

Indirekt betydelse av detta är att likt Nvidia och AMD används samma grundläggande programvara för GPGPU både i datacenter som för konsumentprodukter.

Intels "svar" på Nvidias CUDA (som i nuläget totalt dominerar GPGPU) heter OneAPI, ett väldigt omfattande ramverk som Intel redan jobbat på under flertalet år och som de lägger väldigt stora resurser på. Kikar man på tester av Intel Arc ser vi att det finns mer jobb att göra på programvara för 3D-grafik.

Enda gången Nvidias VD gjort någon kommentar kring Intels GPU-satsning är när han kommenterade OneAPI. De kommentarer som kom från Jensen var naturligtvis nedlåtande, det är hans jobb att spela ned konkurrenter. Att han överhuvudtaget kände sig tvingad att kommentera OneAPI indikerar nog ändå att Nvidia inser att Intel har något som kan utmana CUDA!

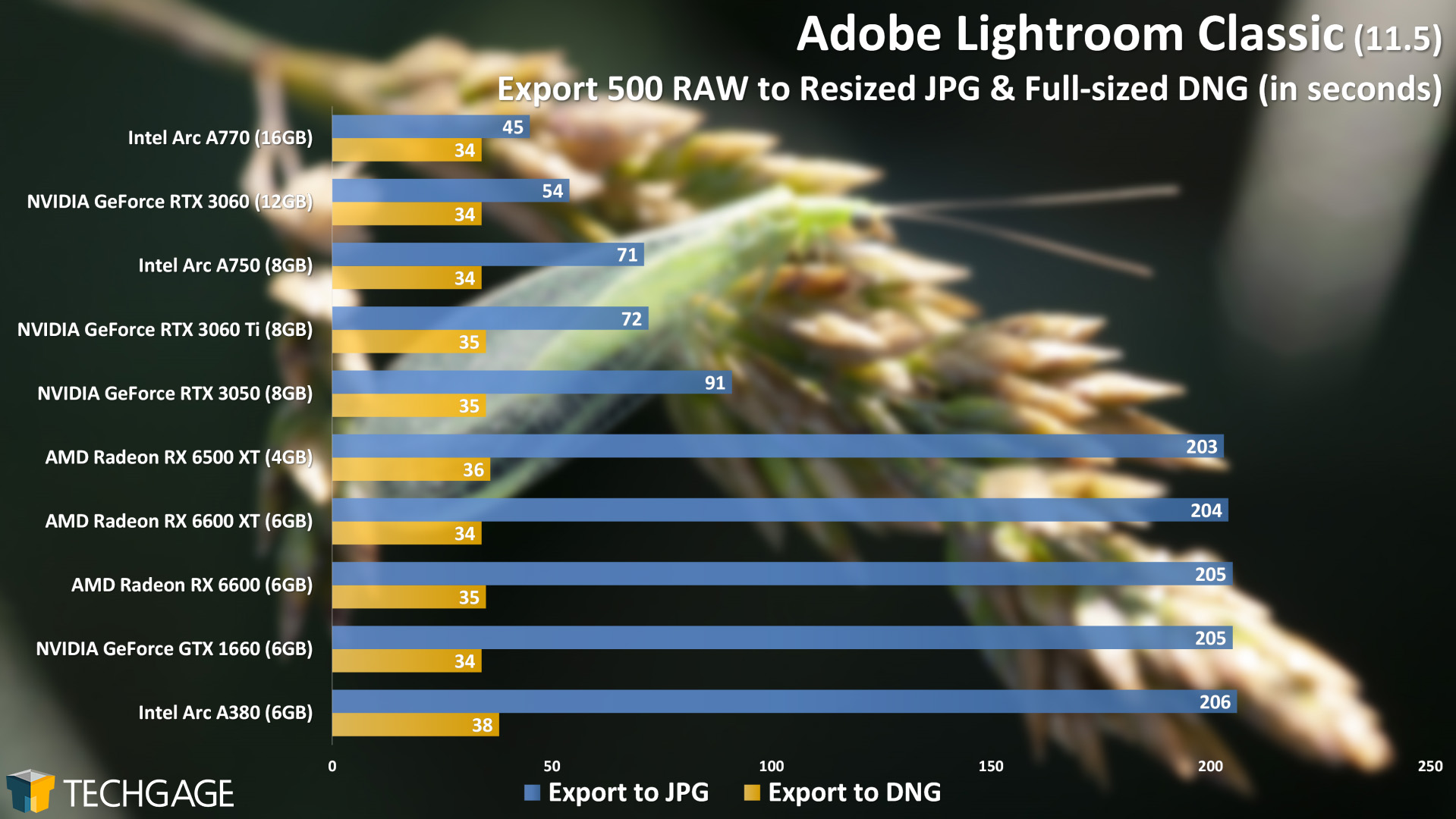

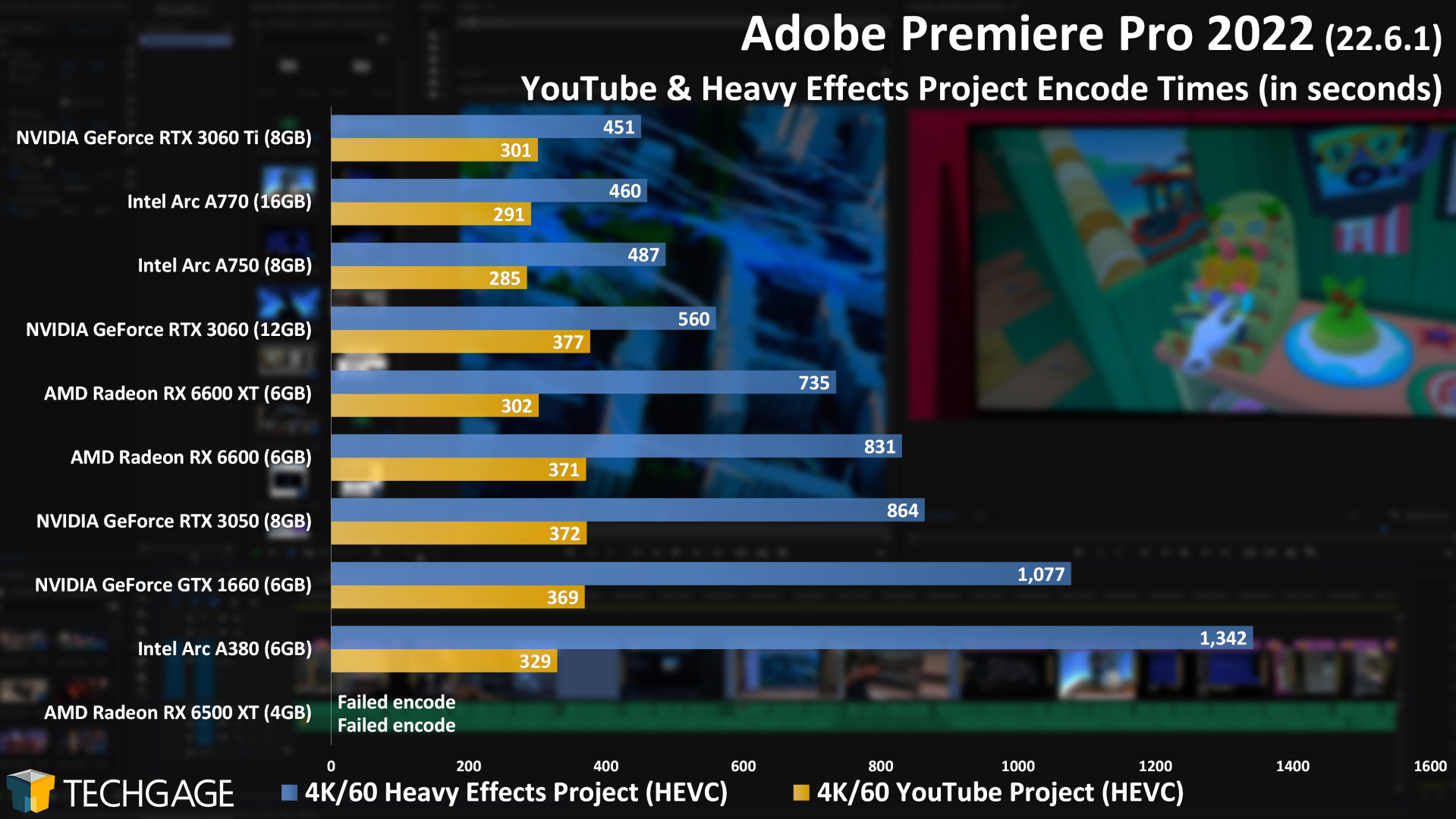

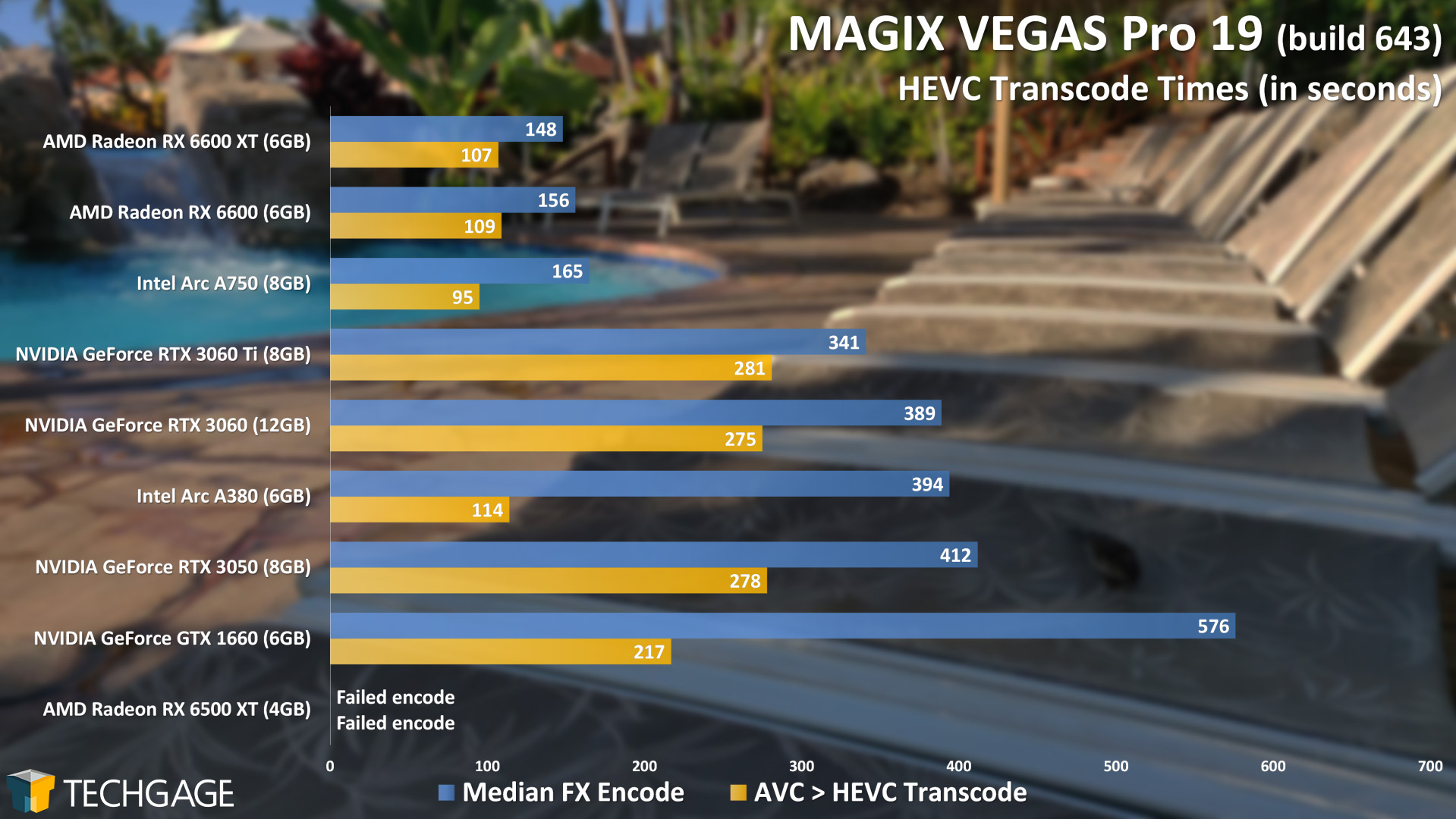

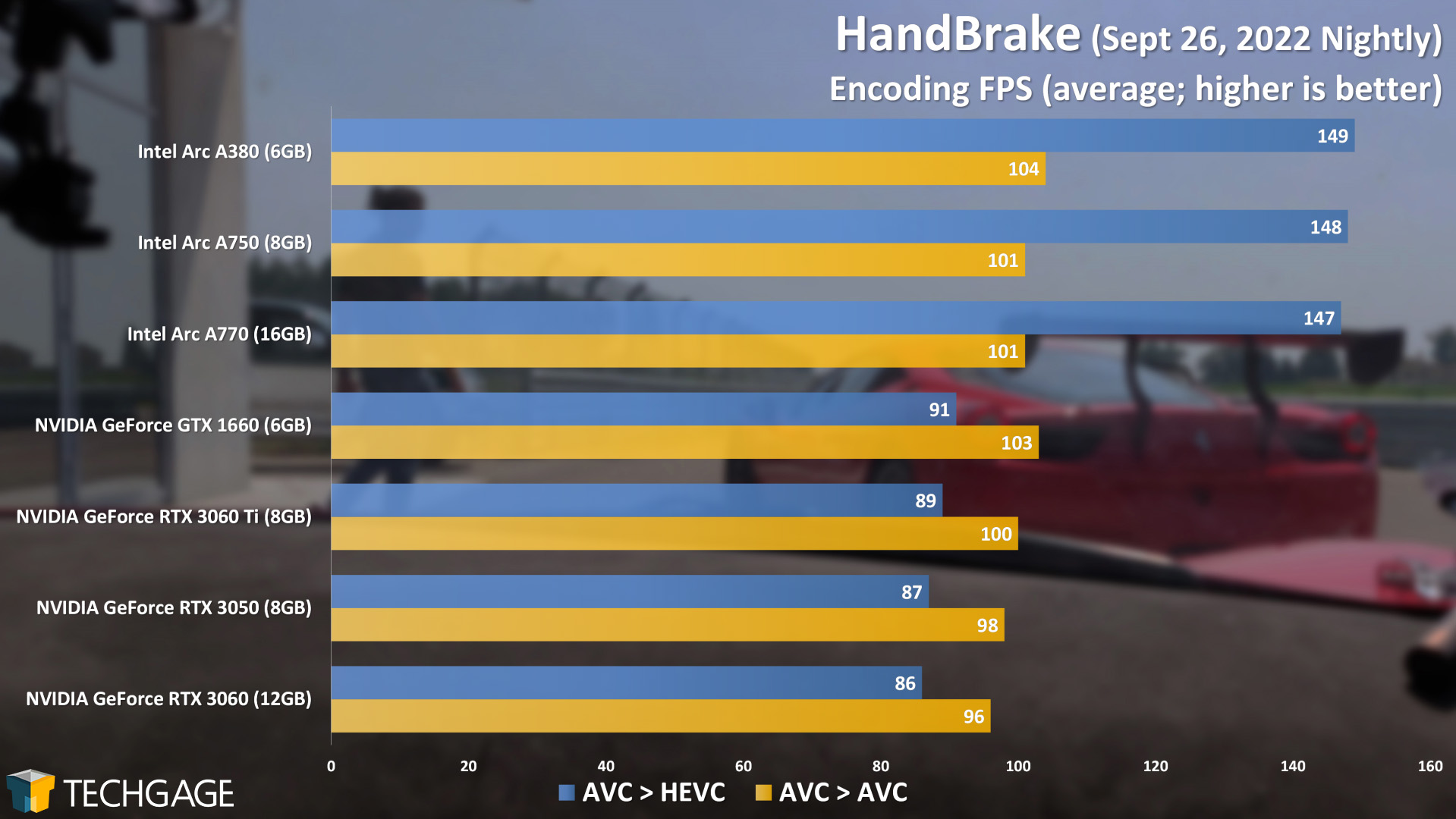

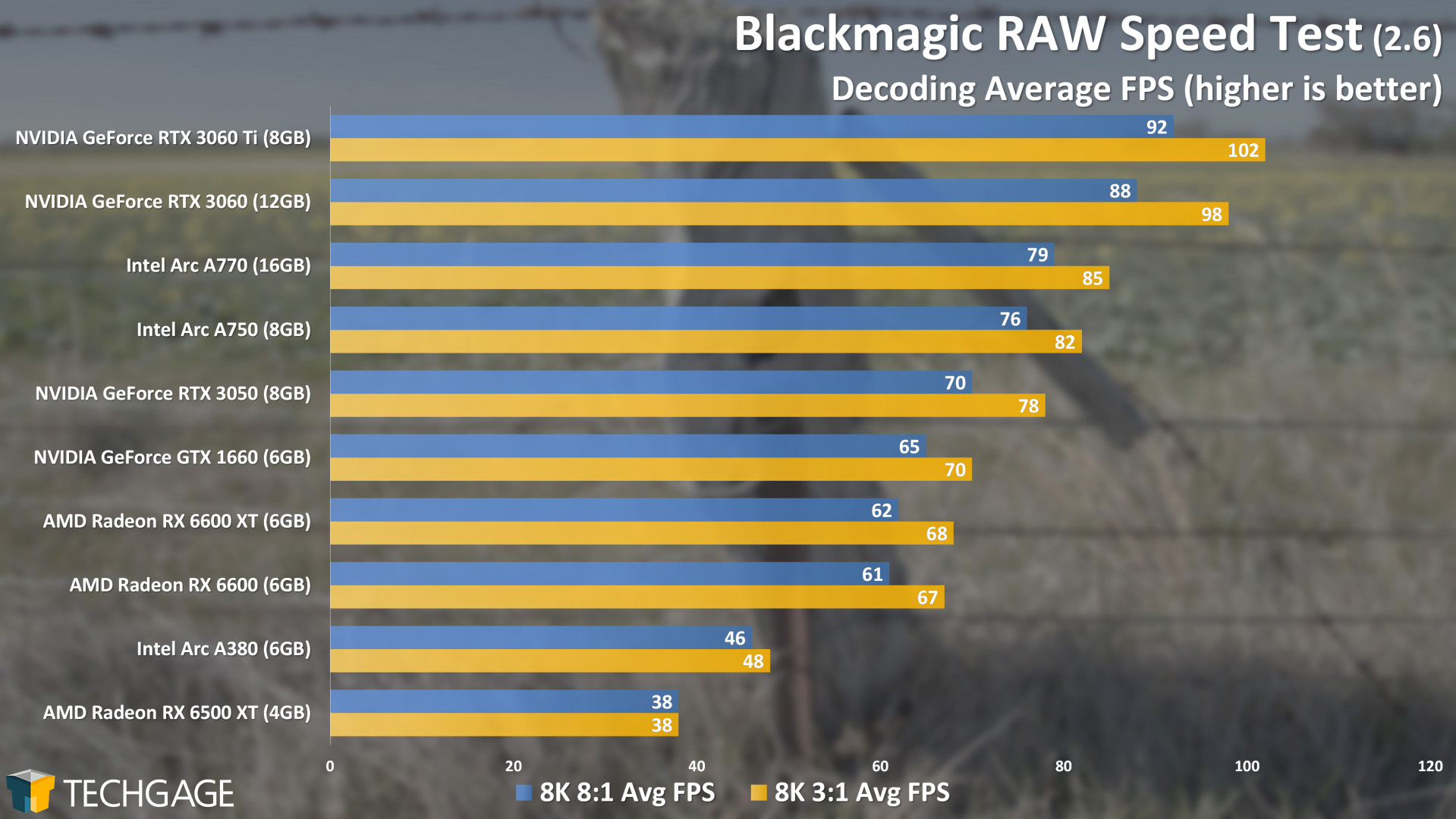

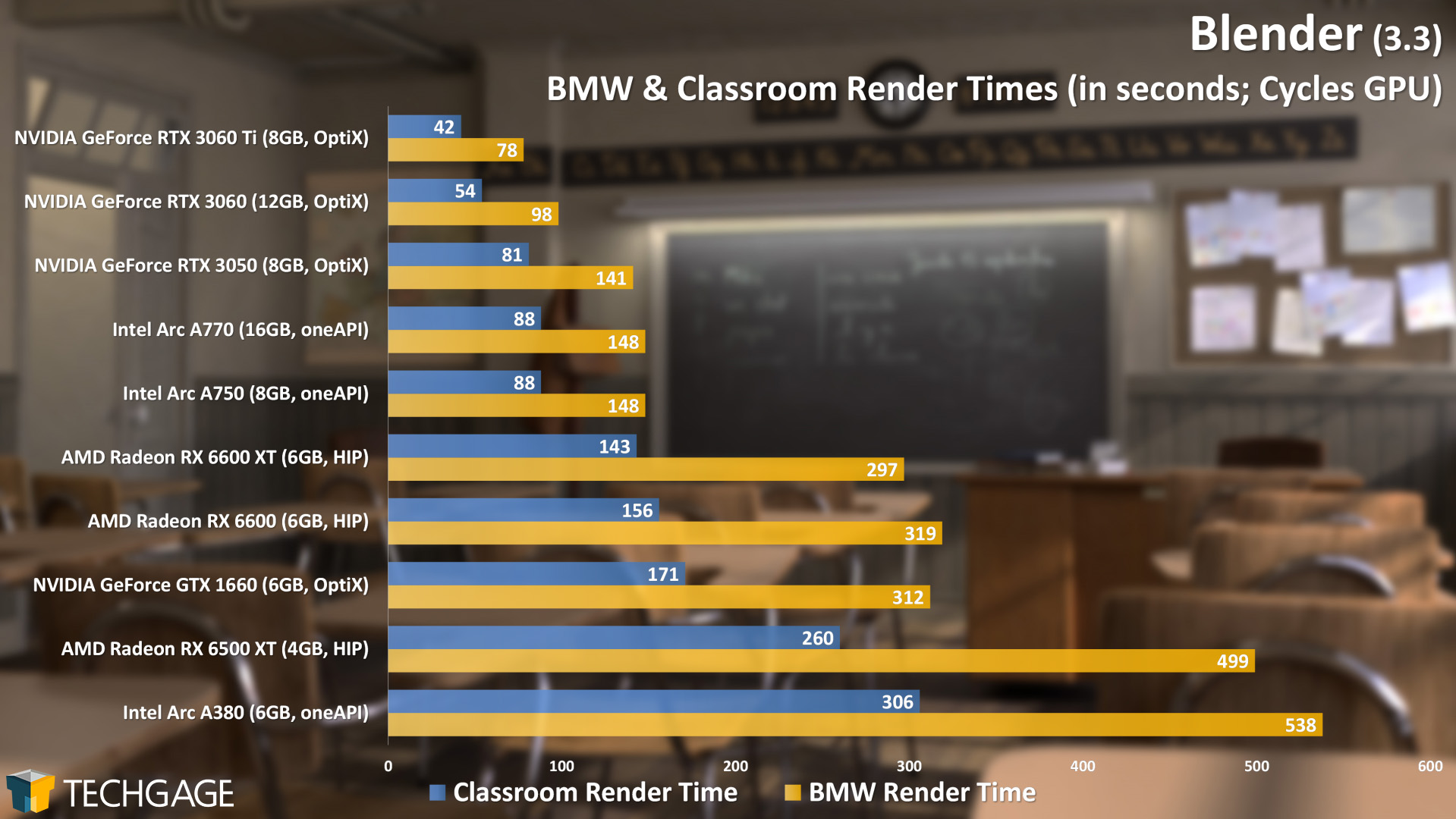

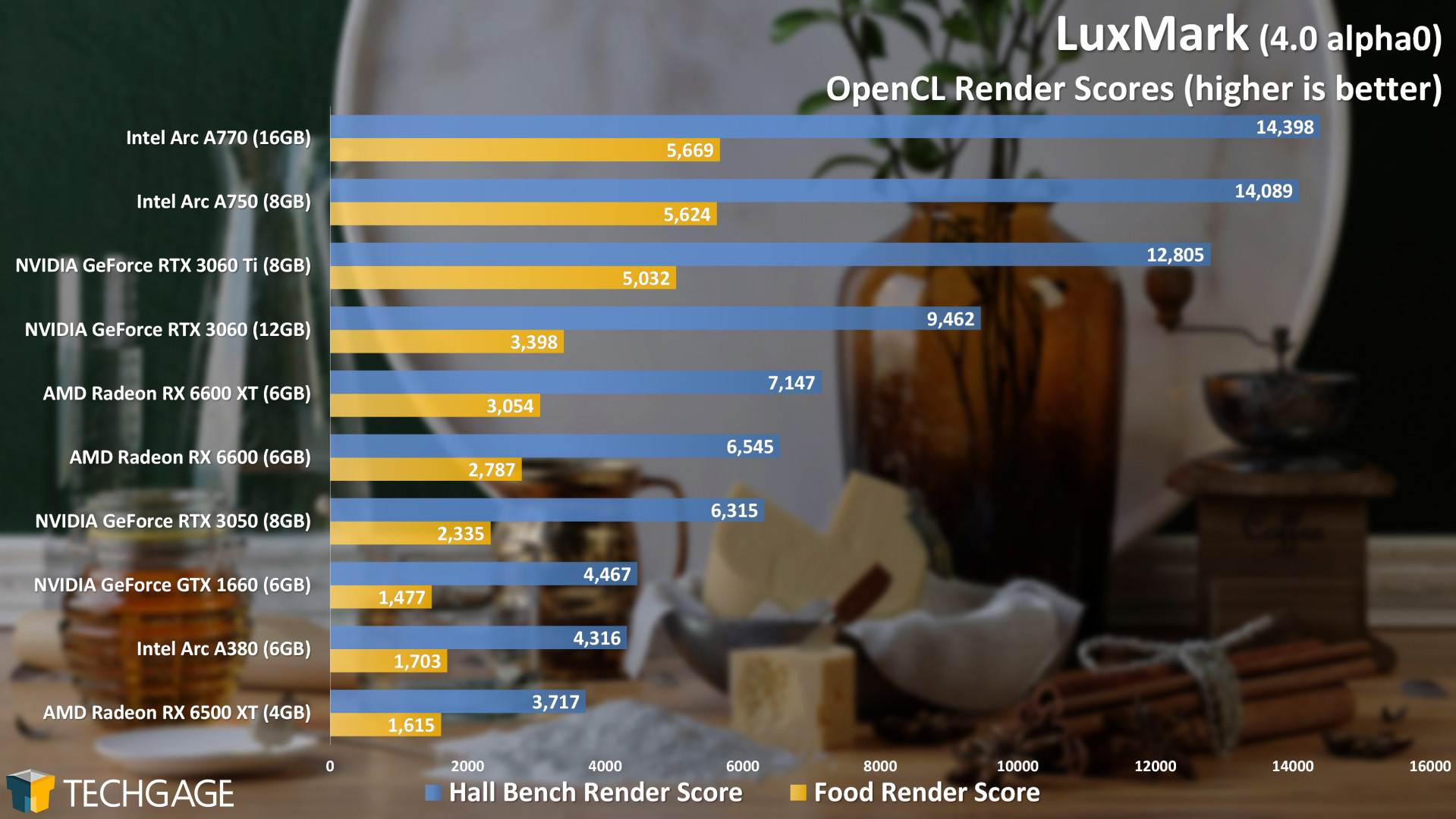

Till skillnad från vad vi ser för speltitlar så uppvisar Intels GPGPU-stöd redan nu direkt lysande prestanda och man har redan en väldigt brett stöd i olika programvaror. Arc presterar redan på förväntad nivå mot CUDA. Mot OptiX som används i 3D-rendering ligger man efter Nvidia, men Intel har motsvarande HW-stöd som Nvidia och man jobbar på ramverk som kommer motsvara OptiX (kommer nog först till Blender, det under 2023).

Klicka för mer information

Visa mer

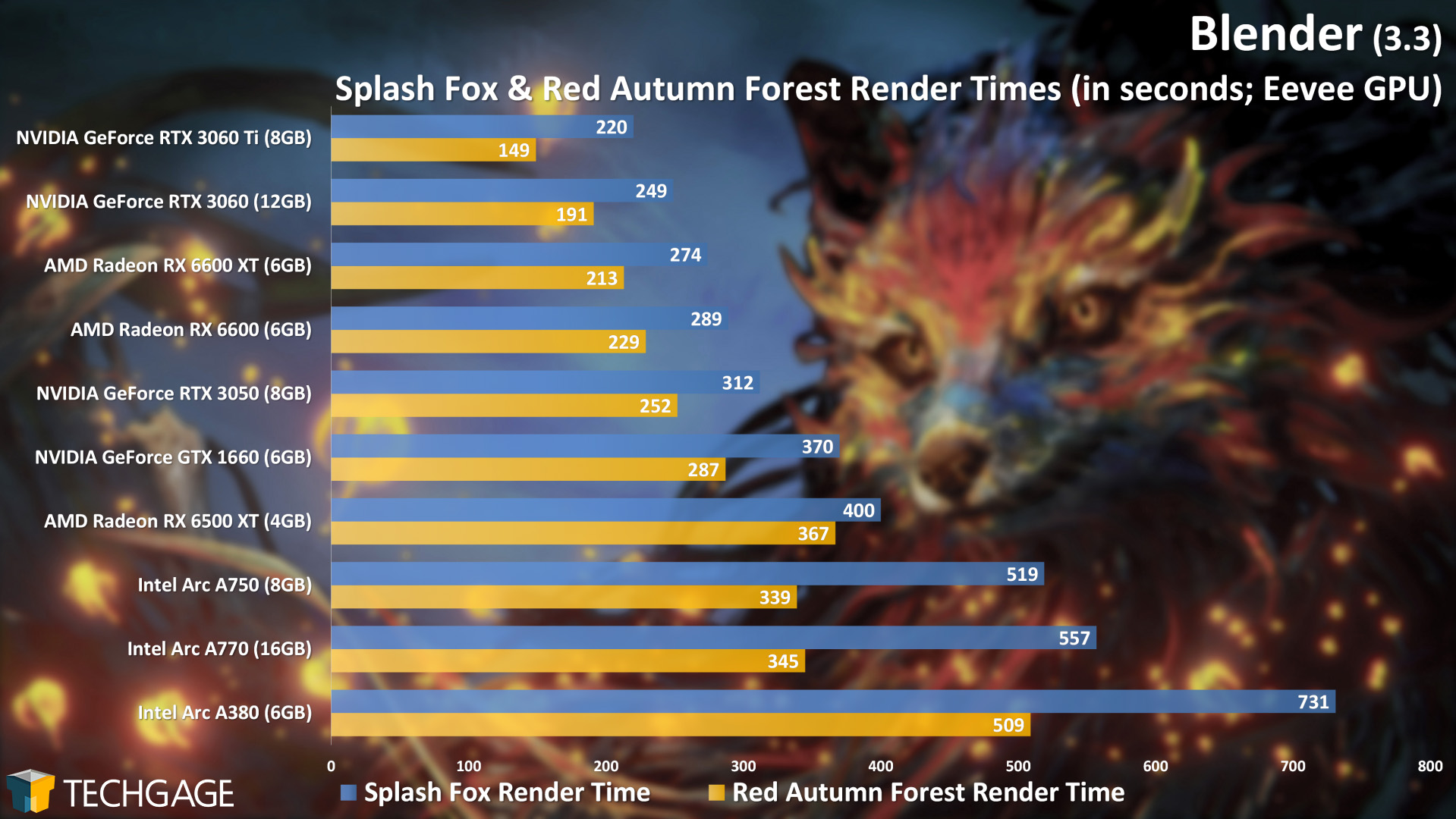

Enda som sticker ut åt det negativa håller är Blender Eevee, men då detta i praktiken är traditionell 3D grafik indikerar det bara att Intel har hemläxa att göra på 3D-grafiksidan (fokus har uppenbarligen legat på GPGPU då det är vad man måste ha i datacenter).

Vill man se detta med "glaset halvfullt" ögonen så betydligt detta rimligen att det finns en hel del prestanda att hämta vad det gäller spelprestanda om/när man får ordning på 3D-grafik delen i drivarna.

Klicka för mer information

Visa mer