För denna gången så ska jag svara. Kommande recensioner och spel kommer nog få dig att ändra uppfattning om inte testerna jag ska länka till längre ner gör det. Låt oss se och blicka över några saker först:

Du verkar totalt ignorera att DX12 mer eller mindre är framtaget för att lyfta bort alla tidigare restriktioner (GCN och Mantle+konsol APU'erna har vi att tacka här till initiativet). Dessa restriktioner märks inte hos nvidia-GPU'er då det det i grunden är en typisk DX11 arkitektur som nyttjar sin (relativt svaga) beräkningskapacitet, och inte nog med det, utan även i många spel också en gameworks miljö med frenetiskt kodade drivers för att få det att fungera såpass bra. Det är inte några rader kod... Det är en ren mardröm och något som kostat nvidia multum. Eftersom du gillar att programmera så utgår jag ifrån att du vet det också. AMD fungerar dock tillfredsställande i många DX11 spel, men fokuserar desto hårdare på framtiden och konstruera GPU'er som är beräkningsmonster.

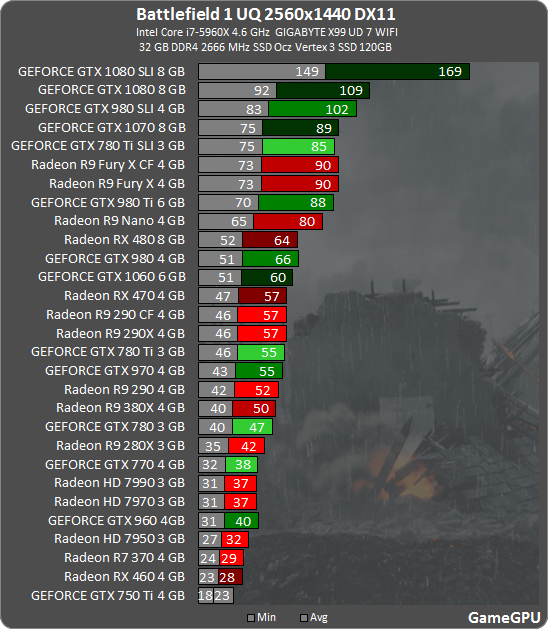

Exempel på helt nytt test i DX11 Battlefield 1 där Fury X går om/precis matchar GTX1070 för att visa att korten inte är "handikappade" i DX11 miljö som du många gånger fått det att låta:

http://gamegpu.com/images/stories/Test_GPU/Action/Battlefield_1/new/b1_2560.png

Vad som är möjligt med DX12 är en gamechanger. CPU skalning, massivt minskad overhead och funktioner som SIF som finns i AMD's GCN GPU'er men också async compute. Hur väl man implementerar det är en annan sak. Att man lägger större ansvar hos spelproducenterna är på tiden. Specifik vendorcode och optimeringar av vars arkitektur funktioner. Vi kan dock utgå ifrån att dom utnyttjar dom fördelar genom en low-level API som DX12 (och Vulkan) vilket vi fått se prov på i Doom (och fler spel/kommande spel).

Sedan DX12 blev officiellt så har det gått relativt snabbt med tanke på hur länge tidigare API'er har hållt i sig och hur tröga övergångarna har varit. Den här gången är AMD i princip ensamma om att vända hela industrin till low-level API. Nvidia måste sätta sig vid ritbordet och ta fram en helt ny arkitektur för att bli av med dessa problem som dom dras med. Vi har kvar samma 31+1 kö sedan Kepler gen.2. Lastbalansering i Pascal är bara ett plåster på såret med Maxwell i grunden. Att allokera beräkningskluster för att köra data+grafik är bara ett desperat försök för att hänga på AMD's tåg, och ett relativt dumt drag då det redan som vi väl känner till är en GPU med hög duty iom dess simpla design/DX11 grund.

DX12 tester

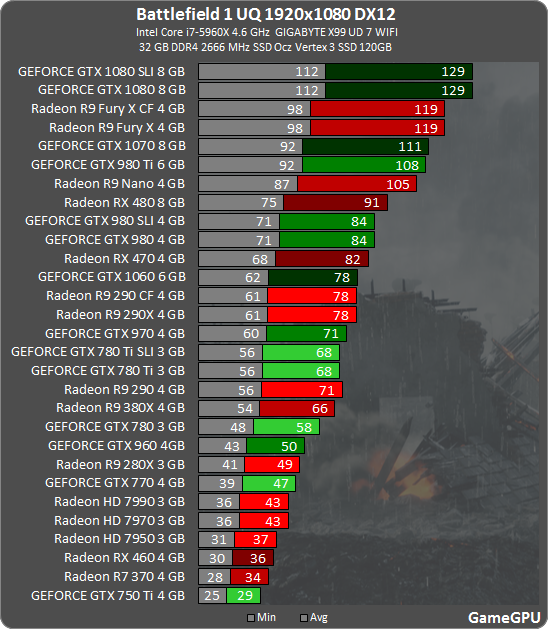

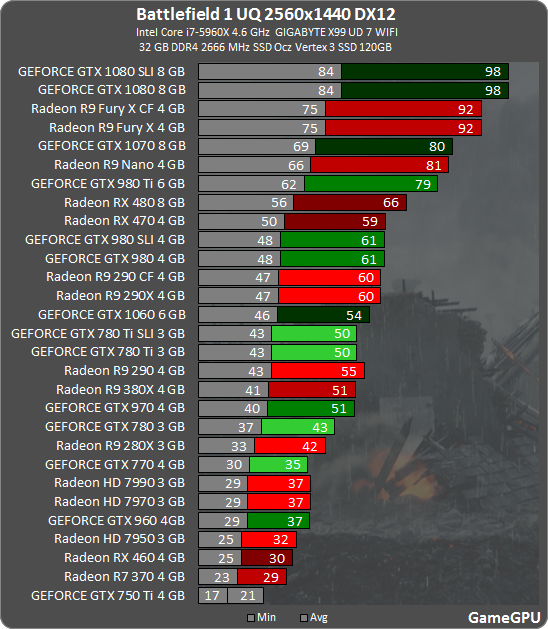

Vi fick vi se Ashes of Singularity och det är så uttjatat så jag tänker inte ens ta upp det spelet. Vi kan istället titta på färska tester som först nu sista månaderna har tagit fart, speciellt BF1 som du var inne på. Jag vill också poängtera att BF1 inte utnyttjar SIF hos AMD-gpu'er, utan bara async compute, vilket du tidigare uttalat dig om att det inte ger så mycket. Vi börjar med BF1:

1080p

http://gamegpu.com/images/stories/Test_GPU/Action/Battlefield_1/new/b1_1920_12.png

1440p

http://gamegpu.com/images/stories/Test_GPU/Action/Battlefield_1/new/b12560_12.png

Vi kan härmed konstatera att:

Deus Ex: Mankind Divided

1080p

http://www.guru3d.com/index.php?ct=articles&action=file&id=25647&admin=0a8fcaad6b03da6a6895d1ada2e171002a287bc1

1440p

http://www.guru3d.com/index.php?ct=articles&action=file&id=25648&admin=0a8fcaad6b03da6a6895d1ada2e171002a287bc1

Vi kan härmed konstatera att:

Fury X presterar över GTX1080 i 1080p och jämt i 1440p, endast dess överklockade variant går förbi

390X går om GTX1070...

RX470 passerar både GTX1060 och GTX980

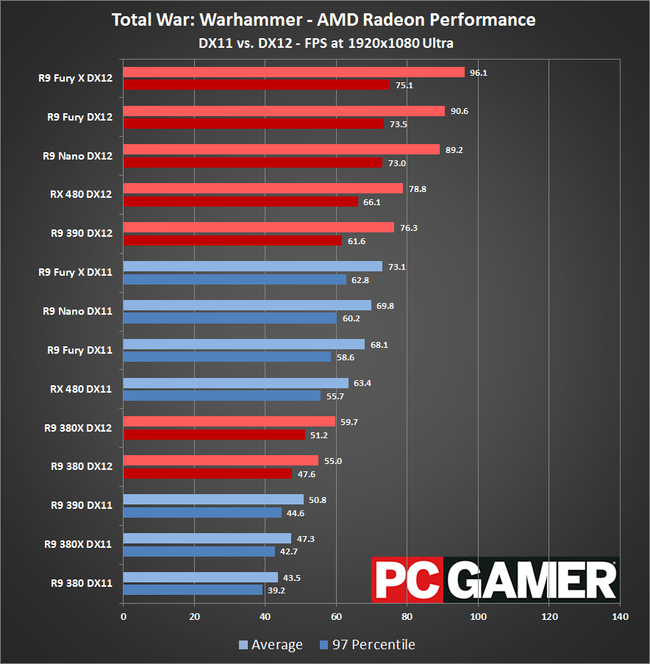

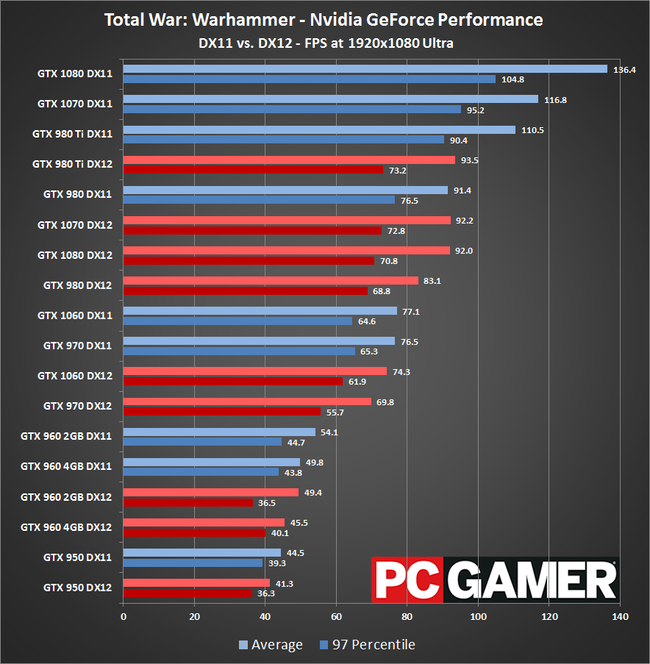

Total War: Warhammer

1080p

http://www.guru3d.com/index.php?ct=articles&action=file&id=25652&admin=0a8fcaad6b03da6a6895d1ada2e171002a287bc1

1440p

http://www.guru3d.com/index.php?ct=articles&action=file&id=25653&admin=0a8fcaad6b03da6a6895d1ada2e171002a287bc1

Vi kan härmed konstatera att:

Hitman (ja det är ett spel och fungerar utmärkt på bägge aktörer)

1080p

http://www.guru3d.com/index.php?ct=articles&action=file&id=25644&admin=0a8fcaad6b03da6a6895d1ada2e171002a287bc1

1440p

http://www.guru3d.com/index.php?ct=articles&action=file&id=25645&admin=0a8fcaad6b03da6a6895d1ada2e171002a287bc1

Vi kan härmed konstatera att:

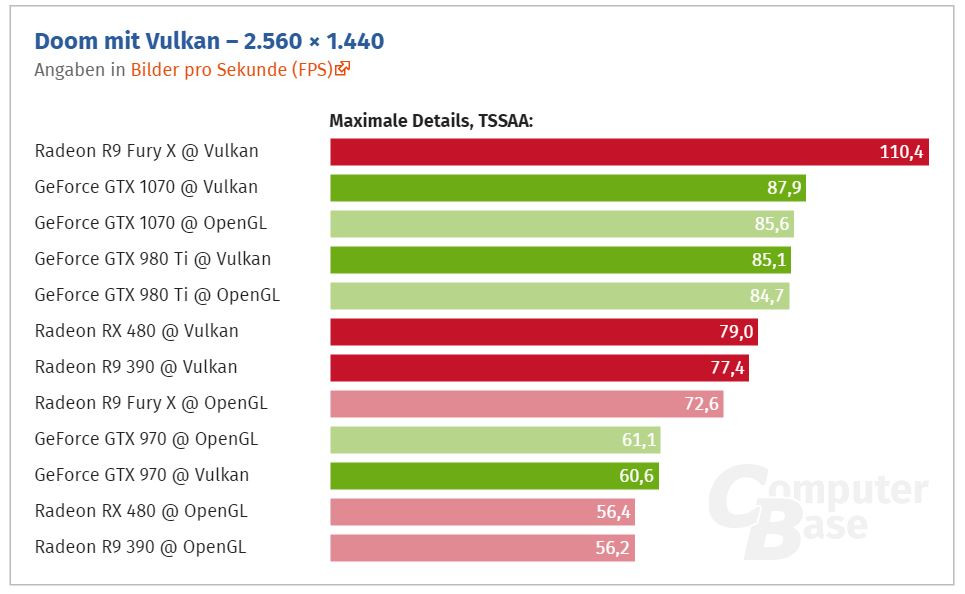

Tar Doom när vi ändå håller på med low-level API'er

1440p

https://www.techpowerup.com/img/16-07-13/45a.jpg

En liten notis till dig från utvecklare som är så emot low-level API'er:

https://twitter.com/idSoftwareTiago/status/738409682415411200

https://twitter.com/idSoftwareTiago/status/738428331788378112

https://twitter.com/dankbaker/status/738215078747635714

Oles Shishkovstov på A4 games:

No, it's important. All the dependency tracking takes a huge slice of CPU power. And if we are talking about the multi-threaded command buffer chunks generation - the DX11 model was essentially a 'flop', while DX12 should be the right one.

Ett typiskt beteende hos Pascal är också att ju fler SP's du har aktiva i arkitekturen, ju mer tjänar dom på DX12 för att förlusten blir mindre med dess partitionering som dom gör av SP's/SM's. Det förklarar precis det jag beskrev innan, att alla SP's är fullt upptagna av att köra grafik. Det finns en stor och enda anledning till varför dom måste göra det, och det är för att kunna köra async compute vilket dom oftast tappar på istället. Ett fruktansvärt ineffektivt lösning och knappast en lika nativ lösning som på GCN där varje enskild SP/CU kan räkna på grafik+data i princip kompromisslöst och med hjälp av ACE, där nvidia låter sig göra samma jobb genom sin driver. Jösses... Du gör liknelser med flertrådsteknologi hos processorer. Där snackar vi om att parallellismen är patetiskt i förhållande till en GPU, men sett till en tråd per beräkningsenhet så kan nyttan av flertrådsteknologi i sällsynta fall vara obefintlig. I det fallet som när du kör en liknelse med att köra Linpack på en CPU-kärna så visst, men det finns extremt ofta bubblor i en CPU pipeline, men speciellt i en GPU.

Skillnaden mot en CPU är att du har 4096SP's i en Fury X GPU. Många av dessa är som bekant inte upptagna och med det sagt finns det massor av beräkningskapacitet som inte har använts/används vilket det inte gör på nvidia-kort av samma rang som snarare har ett underskott på beräkningskapacitet, men det tycker du inte, för det är en lag på att en GPU ska vara konstruerad efter DX11, och allt med unified shaders och parallellism kan vi bara skrota. På vilket sätt man nu inte ser att det är välkomnande att inte låta dessa sträcka på benen förstår jag inte Resultaten är som man ser rätt rejäla och mer kommer.

Fury korten är snart 1½år gamla och gamle 290 (390) serien presterar sjukt bra för sin ålder/pris och som jag länge sagt är starka arkitekturer som bromsats hårt av DX11/gameworks, vilket vi ser är ett faktum av resultatet från DX12 titlarna ovan.

DX12 och Vulkan behöver mer mognad, drivrutiner förbättras i snabb takt. Detta är nvidia's nya arkitektur mot AMD's gamla på en urgammal tillverkningsnod. Blir desto mer intressant att se hur det kommer se ut när Vega lanseras och fler och fler DX12 spel kommer, bättre drivrutiner och uppdaterade patchar för att lägga till funktioner som SIF vilken också fungerar i DX11 titlar om utvecklaren vill.

Tack till initiativet GPUOpen!

https://i2.wp.com/techaltar.com/wp-content/uploads/2016/05/IMG_2835.jpg?resize=768%2C432&ssl=1

Jag skulle kunna hålla på hur länge som helst men här är tiden slut. Kan du inte se det jag och många andra ser så är det lönlöst att diskutera som jag redan gjort flertalet gånger. Vi har samma hårdvara i alla dagens konsoler som i en PC med AMD grafikkort. Bevisligen finns det stora vinster att hämta och på samma arkitektur så tar vi spelen till PC och konsol närmare varandra vilket är fantastiskt och på tiden efter alla fruktansvärda portar genom tiderna. Detta verkar vara det som oroar dig då det sätter ett enormt gruskorn i nvidia's maskineri. Ska tilläggas att jag förespråkar framgången av Vulkan, men DX12 är mer än välkomnande också.