Min musik

@albinloan

Allt vi kan tänka, kan vi skapa.

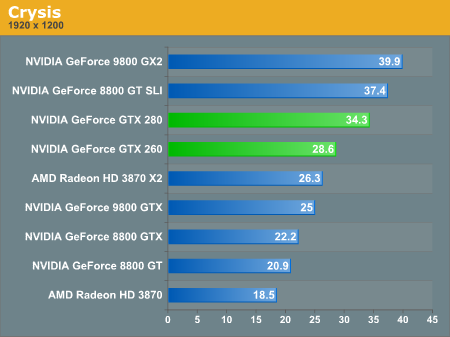

Nvidia lanserar Geforce GTX 200

PSN: ZlimJim (adda gärna)

Live Olimp (adda gärna)

Wii Vetifan :P

Min musik

@albinloan

Allt vi kan tänka, kan vi skapa.

Studio Artcore Tattoo

[i7 9700k@5.3ghz - MSI OC 2080ti - Vive Pro - SRD rig - NLv3 - Fanatec CSW2.5]

Min:ABIT NF7-S V2.0,Barton 2500+AQXEA XPMW@2,35Ghz,2x521Mb Adata Cas 2-3-3-6,Lt 6800LE 1,3v 16x1,6@440-930,SLK900A,Mustek A806 5:1 Dolby Digital Amp. Frugans:ESC K7-SEM,Duron1600,512Mb DDR. Antons:Aopen AK73(A)-V,512Mb Sdr,Xp1600+Parlomino AGOIA GREEN@1875Mhz@1.9v,Volcano7+Moddad@92mm,Gf 4200Ti@305-610 Zalman HP-80.

Min musik

@albinloan

Allt vi kan tänka, kan vi skapa.

Min:ABIT NF7-S V2.0,Barton 2500+AQXEA XPMW@2,35Ghz,2x521Mb Adata Cas 2-3-3-6,Lt 6800LE 1,3v 16x1,6@440-930,SLK900A,Mustek A806 5:1 Dolby Digital Amp. Frugans:ESC K7-SEM,Duron1600,512Mb DDR. Antons:Aopen AK73(A)-V,512Mb Sdr,Xp1600+Parlomino AGOIA GREEN@1875Mhz@1.9v,Volcano7+Moddad@92mm,Gf 4200Ti@305-610 Zalman HP-80.

1: Win7, i7 920@4GHz, 12GB Dominator, Gainward 4870x2, CM Cosmos, 150GB Raptor + 750GB HDD

2. SuSE 11.1, Q9550@400x8½, 8GB A-Data, GeForce 8500GT, Antec 1200, 4TB HDD

Vägra fx 3of4 Pi 1M 1.84 s Memory remapping

Minnen har ingen egen hastighet. Märkningen anger bara vilken hastighet minnena uppges klara

Ryzen 5800X ROG STRIX X570-f GAMING FlareX DDR43600 cl 14-14-14-34 EVGA FTW3 Ultra RTX 3090

Dator 1 i7 920 @ 3,2 ghz, GTX480

Dator 2 Phenom II 940 @ 3 ghz, GTX280

Dator 1 i7 920 @ 3,2 ghz, GTX480

Dator 2 Phenom II 940 @ 3 ghz, GTX280

Memento mori...

Vägra fx 3of4 Pi 1M 1.84 s Memory remapping

Minnen har ingen egen hastighet. Märkningen anger bara vilken hastighet minnena uppges klara

Memento mori...

Min musik

@albinloan

Allt vi kan tänka, kan vi skapa.

Memento mori...

Is it "for fucks sake" or "for fuck sake"? Its for a work email so it has to sound professional.

Min musik

@albinloan

Allt vi kan tänka, kan vi skapa.

P182 | Asus Z170-A | i7 6700k | R9 290X | 2x8GB Corsair 2400MHz Cl14 | Intel 750 400MB | TBs of diskstorage

Min musik

@albinloan

Allt vi kan tänka, kan vi skapa.

NEW ::i7 920 || GTX 295 1792MB || 1600MHz 6GB ||P6T Deluxe V2 || P182 || NH-U12P || TX 850W - LG - W3000H LCD MONITOR

--------

OLD :: X2 4400+ @ 2420Mhz x11 || Corsair TWINX2048-3200C2 @ 220Mhz || A lot of HDD-space ;) || A8N-SLI Premium || 6800GT Leadtek || OCZ 520 Modstream || - KÖPA ?

Min:ABIT NF7-S V2.0,Barton 2500+AQXEA XPMW@2,35Ghz,2x521Mb Adata Cas 2-3-3-6,Lt 6800LE 1,3v 16x1,6@440-930,SLK900A,Mustek A806 5:1 Dolby Digital Amp. Frugans:ESC K7-SEM,Duron1600,512Mb DDR. Antons:Aopen AK73(A)-V,512Mb Sdr,Xp1600+Parlomino AGOIA GREEN@1875Mhz@1.9v,Volcano7+Moddad@92mm,Gf 4200Ti@305-610 Zalman HP-80.

USA har aldrig varit på månen, Sverige hade aldrig vm 1958 och 9/11 har aldrig inträffat och därmed basta.

P4 2,6C@<3,0Ghz + CNPS7000A-CU|AI7|1,5Gb BH5 & BH6|Antec Sonata|R9800np(BBA) + VF700-CU@425/258|HP LP2465|Logitech MX500, Seasonic S12 500W

Core i5 2500K 103MHz*45, Asus P8Z68-V Pro, 4x4GB 103MHz*16, Intel 320 120GB*2, Fractal Design R2, Fractal Design Newton 650W, Asus Xonar mm