System: CPU: AMD Ryzen 9 3900X, MB: Gigabyte X570 Aorus Elite, Minne: Corsair 32GB DDR4 3200MHz, GPU: Asus GeForce RTX 2080 Super ROG Strix Gaming OC

Datortillverkare: "Intel-processorer bristvara till 2019 års andra hälft"

Visa signatur

Skrivet av Paddanx:

Tappar med vad?

2080Ti?

1080ti?

Varför kör du 1080 upplösning med dessa kort?

Tappar du 20% även på 1060?

Eller på 1440 upplösning?

Och är detta räknat med ASUS MCE i testet, eller äkta Intel spec?

Inlägg som det du gör här är varför folk lägger satans massa pengar på något som verkligen inte ger 20% i praktiken. För att få de 20% behöver du ha lagt en förmögenhet på GPUn redan, + snabbt RAM + troligen optimerat frekvenser. Så att köpa en CPU ger inte per automatik "20%" mer prestanda.

Om du dock har tajt budget så kan skillnaden i pris mellan tex 2600k och andra alt ge en hel del pengar över till andra saker. Så då börjar kompromissen. Om pengar inte är problemet, varför kör du inte 7980XE, eller någon annan värsting?

Så inga tvivel på att du kan hitta udda fall där 20% är skillnaden... frågan är, hur mycket kostar de extra 20% i snabb GPU, snabb CPU och RAM, och kommer du ens märka det om de flesta ändå sitter på 60Hz paneler?

Jag kör 1440 med ett RTX 2080 Ti. Min propp i7 6700k flaskar i BF1 samt även under BF5 Alpha 1, BF5 Alpha 2 samt BF5 Beta (BF5 med 1080ti). Mina lows är sisådär. Men som sagt alla har vi våra egna preferenser. Jag kör 1440p med medium till low preset plus en extremt modifierad config, detta ger en avg på 165 fps+ med lows (0.1%) runt 140fps.

Som sagt tidigare i den här tråden lirar man competitive så är det faktiskt värt att lägga pengarna på en bra propp. Lirar man witcher 3 lite slentrianmässigt casual i jalingarna så spelar det givetvis ingen roll alls.

Visa signatur

der8auer Core i9-9900K - delidded @ 5.1 ghz | ASUS ROG Maximus XI Hero | ASUS ROG STRIX GeForce RTX 3090 24GB Gaming OC | Rog Swift PG35VQ && Rog Swift PG27VQ | LPX Black 3200MHz 32gb | Logitech G Pro Wireless | Logitech G915 TKL Tactile | Sennheiser HDV820 | Sennheiser HD 800S | Swedish Match Ettan Orginal Portion | "-DICE please!?"|Min senaste youtube video -> https://youtu.be/OqIq_hh0BI8

Citera flera

Citera

Skrivet av hg:

Det tror många men historiskt sett så stämmer det inte.

Snarare är det så att den CPU med fler cores och fler threads knappar in på en CPU med färre cores/threads över tid, då spelmotorer utvecklas och blir mer multitrådade. Kolla t.ex jämförelser mellan i5-2600k och FX-8350. 2600k är fortfarande generellt snabbare i spel men skillnaden mot 8350 har krympt jämfört med vid lansering. 2600k var ju enormt mycket snabbare speciellt i låga upplösningar vid lansering.

Alla förutsägelser om framtiden är per definition mer eller mindre kvalificerade gissningar.

Kan någon komma på någon metod som har haft bättre träffsäkerhet kring att förutsäga framtida spelprestanda i "normal" upplösning på dagens CPUer med framtida GPUer än att titta på hur dagens CPUer/GPUer presterar i låg upplösning?

Du skrev 2600K två gånger så utgår från att det inte är ett skrivfel. Stämmer verkligen det du skriver om man jämför FX-8350 och i7-2600K? Jämför man SweC test av FX-8350 med sista gången de hade med den CPU (testet av i7-8700K) så är det inom rimlig felmarginal exakt samma spelprestanda i 720p, ca 20 % fördel för i7-2600K.

Vad som däremot hänt sedan lansering av Sandy Bridge är att i5-2500K och andra CPU-modeller med fyra CPU-trådar har börjat tappa i moderna spel när de paras med en relativt stark GPU och man håller sig borta från 4k.

Så uttalandet att spel blir bättre på att använda fler kärnor är i sak rätt, det väldigt många helt missar är tidsaspekten. Redan 2011 fanns det enstaka spel där 4C/8T gav en viss fördel över 4C/4T, sju år senare finns relativt många AAA-titlar där så är fallet. Idag finns enstaka titlar där 6C/12T ger en liten fördel över 4C/8T samt 6C/6T, fem till tio år från nu kan man nog förvänta sig att relativt många AAA-titlar uppvisar detta.

Problemet med att titta så långt i framtiden är att andra saker kan ändra ekvationen. En sådan sak är att SIMD (SSE/AVX på x86) har funnits i ~20 års tid, men var först 2017 som man i någon mainstream programmeringsspråk (C++) faktiskt kan skriva generell kod som effektivt kan kompileras till SIMD (alla moderna high-end CPUer har idag SIMD, man vill inte skriva assembler).

För skrivbordsapplikationer tror jag personligen att SIMD har betydligt högre prestandapotential jämfört med att slänga in ännu fler CPU-kärnor. Många CPU-trådar är mer generellt än SIMD, men SIMD kan användas i rätt många fall där det i teorin finns parallellism men där kostnaden att lägga ut saker på flera kärnor vida överstiger vinsten i att använda flera kärnor.

Ett exempel: multiplicera en 4x4 matris. Varje cell i svaret kan beräknas helt oberoende av alla andra celler, så i teorin skulle 16 CPU-trådar kunna användas. Använder man fler än en CPU-tråd kommer det bli rejält mycket långsammare (har man däremot en tillräckligt stor matris fungerar det att använda flera kärnor, 4x4 är dock inte i närheten tillräckligt stort).

Samma sak kan även göras parallellt med SIMD, där ser man en prestandavinst på flera heltalsfaktorer!

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Citera flera

Citera

(3)

Skrivet av FredrikMH:

Finns där någon logisk förklaring alls till det resultatet?

Resultatet känns inte riktigt konsekvent.

I DX11 presterar 2700X sämre än 8700K.

I DX12 presterar 2700X Bättre än 8700K, fast bara om du väljer Vega 64. Med 1080 Ti presterar de likvärt.

Uppenbarligen är det inte processorn som begränsar antal fps eftersom båda får mycket högre och ungefär samma med 1080 Ti. Går man över till Vega 64 presterar Intels 8700K sämre än 2700X. Hur kommer det sig?

Jag har helt enkelt svårt att förstå resultatet.

Detta känns ju inte bara som Cherry-picking utan t.o.m. ett resultat som är svårt att argumentera för.

Ja visst är det ett lite udda resultat.

Vet inte varför det blir som det blir, men spelet är ju nytt och är väl optimerat för dx12, en skillnad mellan AMD och Nvidia är att AMD är bättre på att sprida sin grafik på många trådar i Dx12.

Kanske 2700x fler kärnor kommer till nytta pga detta? eller är det att det syns mindre eftersom den starkare GTX1080Ti bottnar CPU:n?

Intressant är det i alla fall och visar vad som kan hända när man testar utanför ramarna, det skall ju jämnt testas GPU med starkast möjliga CPU, och CPU med starkast möjliga GPU.

Visa signatur

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

Citera flera

Citera

Skrivet av Radolov:

Jag vet inte vad de gjort, men jag skulle gissa att de med sitt "sechzehn gigabyte Arbeitsspeicher" (dvs 16 GB RAM, det är nämligen alla detaljer du får) har standardinställningar på kanske 2133mhz? Ser ingen annan förklaring hur de fått de resultaten som de fått.

Största felindikatorn är Wolfenstein 2. Jag har testat det rätt så mycket, så jag vet var de krävande sektionerna är i det spelet. Med 1700X (3,8Ghz), 16 GB ARBEITSPEICHER (satt till 3066 CL14) , RX480 (nästan lika stark som 2080ti, jag vet. Har kompenserat med 720p, vilket i sig är otillräckligt för att få samma prestanda som en 2080ti, men jag accepterar gladeligen utmaningen) på ultra.

Problemet är bara att jag har svårt att få ett genomsnitt under 160 FPS. Det var miniminivån jag kunde få ut när jag såg på ett ställe som möjligtvis GPU begränsade mig, då jag kunde få genomsnitt 200 FPS om jag drog ner upplösningen till 1 steg neråt på 16:9 aspect ratio:n. Så inte ens det var säkert att jag stötte på en CPU flaskhals.

Efter det sprang jag runt för att få ett tiotal personer att vilja jaga efter mig och på så sätt försöka få en CPU bottleneck. Då lyckades jag få ner FPS till 140, under ett ögonblick, för att sedan gå tillbaka till ~170-180FPS.

Computerbase får ett AVG på 132FPS.

De visar inte vilken scen som testades, en video som visade att så var fallet eller ens någon annan som fått liknande resultat. Jag tror på dem när jag får se faktiska bevis, men fram tills dess så ställer jag mig skeptisk till resultaten.

Kan hålla med om att de definitivt kunde vara tydligare. Vad man säger är att man testar allt i standardutförande och så länkar man till sina respektive tester av de CPUer som ingår.

Till skillnad från de flesta andra teknikwebbplatser, men likt SweC, så kör ComputerBase alltid med RAM på den officiella hastigheten. Så i detta fall kör R5-2600X och R7-2700X med DDR4-2933 (15-15-15-35-2T) medan i7-8400 och i7-8700K använder DDR4-2666 (15-15-15-35-1T).

Men ser definitivt inget konstigt med resultatet. Skattar man relativ IPC mellan i7-8700K (med antagandet att den kör på 4,3 GHz) och R7-2700X (med antagandet att den kör 4,1 GHz då det är vad ComputerBase såg när alla kärnor jobbade) så blir resultatet att i7-8700K ligger runt 22-23 % högre i IPC.

Har tidigare jämfört i5-7400 samt R3-1200 / R3-1300X i 720p baserat på TechPowerUps tester. Rensar man bort de spel som är uppenbart GPU-bundna får man faktiskt exakt samma 22-23 % IPC fördel för i5-7400. Använde dessa tre då i5-7400 är klockad rätt mycket mitt emellan de två andra, så man slipper kompensera för skillnad i klockfrekvens.

Har gjort en del "riktiga" IPC mätningar, d.v.s verkligen mätt IPC i stället för att skatta det. Dessa laster är väldigt nära 100 % CPU-bundna och de är alla enbart beroende av heltalsprestanda (så flyttalsprestanda och SIMD-prestanda är irrelevant). I genomsnitt över det som testades fick i7-6770HQ 28 % högre IPC över R7-2700X Alla tester kördes här med 4C/4T då jag även jämförde mot J5005 och i5-4570 som båda är 4C/4T modeller.

Tittar man på Geekbench 4 resultat, t.ex. i5-7400 vs R3-1300X, där båda har DDR4-2400 minnen, och plockar ut heltalstesterna och kompenserar för skillnad i klockfrekvens är det 21 % över de 12 tester där flaskhalsen är heltalskapacitet.

Gissar att många fått en skev bild av IPC-skillnaden mellan Zen och Skylake då dels "IPC" är ett koncept som rätt många missförstår. Men primärt tror jag orsaken är därför att många teknikwebbplatser pratar idag om IPC i samband med CPU-tester, sedan mäter man det m.h.a. Cinebench single thread...

Där ligger en supertabbe då relativ IPC mellan Skylake och Zen varierar rätt mycket beroende på om primär flaskhals är heltal, flyttal eller SIMD. För flyttal är det rätt mycket jämt skägg, så Cinebench ger en helt förväntat värde.

Tar man Geekbench 4 resultatet jag länkade ovan och plockar ut de sju tester där flaskhalsen är (skalära)flyttal så är blir skillnaden i IPC endast 5 % (skiljer bara 3 % i median). Finns tyvärr bara två SIMD tester så lite vingligt värde, där är skillnaden i IPC 60 %.

tl;dr när CPU-delen är flaskhals i spel beror prestanda primärt på, i fallande relevans: klockfrekvens, IPC för heltal samt antal CPU-trådar (men över 8 trådar är denna skillnad i praktiken noll). Så sett till resultat är resultatet ComputerBase fått helt förväntat.

Skrivet av Ratatosk:

En RTX2080Ti?

Bah! de borde testa på en riktig GPU, Vega 64!

https://www.gamestar.de/artikel/shadow-of-the-tomb-raider-per...

I det testet sparkar 2700x stjärt!

Enda jag ser där är: när man kör med Vega 64 så är man rejält GPU-bunden. Det eller så måste AMD ha en av historiens sämsta drivers då vi ser på GTX 1080Ti resultaten att CPUerna är fullt kapabla att driva spelet i rätt mycket högre hastighet när GPU-hastigheten skruvas upp.

Ja, rent numeriskt ger R7-2700X ett högre resultat med Vega 64 men kollar man på hur stor den skillnaden är relativt sett borde det framgå rätt bra att en full rimlig förklaring till resultatet är mätosäkerhet (precis som att R3-1200 kan få ett högre resultat än i7-7700K i 4k).

Det är definitivt möjligt att Vega-drivers gör något som är billigare på Zen, så i ett strikt GPU-bundet fall kan det då bli en konstant fördel för Zen. Lite som det var något spel som gjorde något korkat med x86 non-temporal SSE instruktioner, när det fixades ökade prestanda klart mer på Zen (men det ökade även på Skylake). D.v.s. det kan finnas prestandabuggar i koden som drabbar en viss CPU-mikroarkitektur hårdare.

I fallet du postar känns ändå mätosäkerhet alt. en starkare CPU just i denna titel ger en något lägre genomsnittlig GPU-frekvens. Dagens GPUer har ju inte en konstant frekvens, de påverkas av aktuell arbetslast och aktuell GPU-temperatur. Den skillnad som finns mellan CPUerna med Vega64 är definitivt inte större än att det kan förklaras med sådana effekter (är trots allt >20 % skillnad i garanterad frekvens och maxfrekvens på ett stock Vega64).

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Citera flera

Citera

(2)

@Yoshman: Vi pratar om 7-8%, jag tror inte på mätosäkerhet.

Visa signatur

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

Citera flera

Citera

Skrivet av Ratatosk:

@Yoshman: Vi pratar om 7-8%, jag tror inte på mätosäkerhet.

Så historiens sämsta driver team då

Så du tror alltså det är helt uteslutet att mätosäkerheten är större än 3,7 %? Större än så behöver den inte vara för att intervallen mellan de två resultaten ska överlappa. När intervallen överlappar kan man ju inte längre säga att den ena är större än den andra.

Och 3,7 % innefattar ju den osäkerhet man får mellan körningar då t.ex. grafikkortet har en dynamisk frekvens. SweC skruvar ju tydligen upp "power limit" just för att variansen är relativt stor annars. Vet du om GameStar gjorde samma sak?

Det kombinerat med att detta är ett enda spel! Drar man slutsatser från en enda applikation kan man t.ex. komma fram till att:

i7-4790K presterar bättre än i7-8700K i spel

"Skylake har 40 % högre IPC i heltalsprestanda jämfört med Zen" Det är något jag har på att-göra-listan att undersöka, Zen presterar konsekvent dåligt i skriptspråk jämfört med Core. Har sett det i Python, BASH, Perl samt Lua så verkar inte vara en slump (har en teori, men inte haft tid att undersöka teorin än).

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Citera flera

Citera

(2)

Skrivet av Yoshman:

Så historiens sämsta driver team då

Så du tror alltså det är helt uteslutet att mätosäkerheten är större än 3,7 %? Större än så behöver den inte vara för att intervallen mellan de två resultaten ska överlappa. När intervallen överlappar kan man ju inte längre säga att den ena är större än den andra.

Och 3,7 % innefattar ju den osäkerhet man får mellan körningar då t.ex. grafikkortet har en dynamisk frekvens. SweC skruvar ju tydligen upp "power limit" just för att variansen är relativt stor annars. Vet du om GameStar gjorde samma sak?

Det kombinerat med att detta är ett enda spel! Drar man slutsatser från en enda applikation kan man t.ex. komma fram till att:

i7-4790K presterar bättre än i7-8700K i spel

"Skylake har 40 % högre IPC i heltalsprestanda jämfört med Zen" Det är något jag har på att-göra-listan att undersöka, Zen presterar konsekvent dåligt i skriptspråk jämfört med Core. Har sett det i Python, BASH, Perl samt Lua så verkar inte vara en slump (har en teori, men inte haft tid att undersöka teorin än).

Helt uteslutet är ett starkt ord och inget jag hävdar, men min gissning är att osäkerheten är mindre än så.

Nej jag drar inte slutsatser från ett enda spel, jag drar fram resultatet eftersom det är intressant.

Mitt inlägg till dig var skämtsamt utformat, trodde att det var klart att även jag inte anser att man kan dra stora växlar på ett enda test.

Vad jag dock skulle vilja, är att någon grävde lite djupare, för att se om något ligger bakom det.

edit kanske Shadow of Tomb Raider använder mycket flyttal.

Senast redigerat

Visa signatur

AMD Ryzen 7 1700 | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/z2ljhr | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/5krwxf

HTPC | https://valid.x86.fr/uuzli0 |

Citera flera

Citera

Skrivet av Yoshman:

Du skrev 2600K två gånger så utgår från att det inte är ett skrivfel. Stämmer verkligen det du skriver om man jämför FX-8350 och i7-2600K? Jämför man SweC test av FX-8350 med sista gången de hade med den CPU (testet av i7-8700K) så är det inom rimlig felmarginal exakt samma spelprestanda i 720p, ca 20 % fördel för i7-2600K.

Vad som däremot hänt sedan lansering av Sandy Bridge är att i5-2500K och andra CPU-modeller med fyra CPU-trådar har börjat tappa i moderna spel när de paras med en relativt stark GPU och man håller sig borta från 4k.

Jag menade nog i5:an. Glömde bort att den tydligen hette 2500k och inte x600 som alla senare i5 modeller.

Citera flera

Citera

@Yoshman: Så det som du nyss skrev, vad har det att göra med rimliga resultat i Wolfenstein 2? Det kan användas som förklaringsmodell om dessa skillnader påvisas, men inte ens det är 100% säkert att det är av just de anledningarna.

Det jag ställer mig kritisk till är att de säger sig ha hittat "svarta CPU hål" som jag aktivt letade efter i ca 2h igår. Det närmaste jag kom var 160FPS AVG. Då kunde jag inte ens utesluta att jag var GPU bunden, då jag lätt kunde få konstant 200 FPS med 600p.

Men totalt har jag kört 24h, och har aldrig någonsin sett det som de påstår hände dem. Då kollade jag även igenom youtube videos för resultat som andra har fått. Inte ens de kunde jag hitta prestanda som liknade resultaten CB fått. Inte ens när jag sökte på threadripper så gick det att få till siffrorna som de hade.

Då duger inte förklaringen "alltså, det här resultaten går inte att jämföra med något. Men jag tänker inte säga hur jag fått fram dem siffrorna", vilket är mer eller mindre det CB säger. Artikeln har 1300 kommentarer på tre dagar, jämfört med deras 2080ti review med 1780 kommentarer på sex dagar. Många tycker att resultaten är skumma. Att en artikel är kontroversiell är ju iofs ingenting som gör den felaktig, men det är tillräckligt för att framkalla transparens.

Kommer man med resultat som ingen annan kan reproducera, så bör man bistå med all information som man har tillgänglig. Det behöver inte betyda att resultaten är fabricerade eller så, men det är inte uteslutet att resultaten är ohederliga. En 43% skillnad i AVG FPS mellan 2700x och 8700k har mig veterligen ingen annan hittat i Wolfenstein 2.

Med det sagt, tomb raider. Det är intressant att du hoppar över 1080p siffrorna, som faktiskt är det som testas i gamestar. Här har ju techpowerup radat upp Ryzen i prestandatoppen för 1080p. Ett liknande resultat finner man i 1440p. För 4k är allting så GPU-begränsat att skillnaden är för osäker. Men vi kan se en svag trend att ju högre upplösning, ju större relativt övertag får Ryzen. Hur ser det ut för det nya tomb raider enligt computerbase?

Låt oss vara överens om att 4k AVG är för osäkra att dra några slutsatser från. Men 99:de percentilen berättar en historia som jag skulle påstå är intressant. Vid 1080p har intel övertag i alla API:n (ställer 8100 mot 2400g och 8700k mot 2700x, för att det är de som finns tillgängliga i testet). Men när man går upp till 4k så gynnar samtliga API:n Ryzen. I tre av fyra fall med 5%. Detta har nödvändigtvis ingenting med API:erna att göra, utan kan t.ex vara kod som är mer lämpad för Ryzen under en (delvis) GPU bottleneck. Vega kan möjligtvis ha lagt sig mellan där Intel gör bra från sig och där ingen skillnad visas

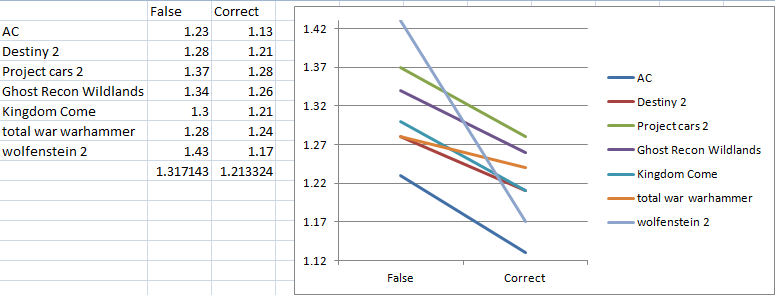

Hur ser det ut överlag då? Är det alltid så att 99:de percentilen konvergerar mot 0 skillnad om vi går från 1080p till 4k? Jag tog siffrorna för de spel som jag kunde hitta som computerbase testat 2700x och 8700k, (tror jag missade en, men den visade konvergens mot 0). Vi ser att i normalfallet så konvergerar faktiskt 99:de percentilen mot 0 skillnad vid 4k. Utom i två fall, ena är Age of empires remake (kan ej förklara denna) och *trumvirvel* Tomb raider. Alltså är den cherry pickad, nog mest för att resultatet är intressant.

Civilization hade förresten problem med NVIDIA:s drivers. Det första tecknet var när hardware unboxed fick mycket bättre siffror för 1600x än 7700k , men enbart med Vega64 och inte med GTX 1080. Detta korrigerades långt senare. Också den dåliga prestanda när man gick från 16 kärnor till 32 (till den mån det var möjligt, då 2990WX kommer ha stora latensproblem i alla fall). Poängen är att AMD har haft en hel del otur med NVIDIA:s drivers tidigare. Kanske Intel har motsvarande problem med AMD:s drivers ibland?

Citera flera

Citera

(4)

Skrivet av Radolov:

@Yoshman: Så det som du nyss skrev, vad har det att göra med rimliga resultat i Wolfenstein 2? Det kan användas som förklaringsmodell om dessa skillnader påvisas, men inte ens det är 100% säkert att det är av just de anledningarna.

Det jag ställer mig kritisk till är att de säger sig ha hittat "svarta CPU hål" som jag aktivt letade efter i ca 2h igår. Det närmaste jag kom var 160FPS AVG. Då kunde jag inte ens utesluta att jag var GPU bunden, då jag lätt kunde få konstant 200 FPS med 600p.

Men totalt har jag kört 24h, och har aldrig någonsin sett det som de påstår hände dem. Då kollade jag även igenom youtube videos för resultat som andra har fått. Inte ens de kunde jag hitta prestanda som liknade resultaten CB fått. Inte ens när jag sökte på threadripper så gick det att få till siffrorna som de hade.

Då duger inte förklaringen "alltså, det här resultaten går inte att jämföra med något. Men jag tänker inte säga hur jag fått fram dem siffrorna", vilket är mer eller mindre det CB säger. Artikeln har 1300 kommentarer på tre dagar, jämfört med deras 2080ti review med 1780 kommentarer på sex dagar. Många tycker att resultaten är skumma. Att en artikel är kontroversiell är ju iofs ingenting som gör den felaktig, men det är tillräckligt för att framkalla transparens.

Kommer man med resultat som ingen annan kan reproducera, så bör man bistå med all information som man har tillgänglig. Det behöver inte betyda att resultaten är fabricerade eller så, men det är inte uteslutet att resultaten är ohederliga. En 43% skillnad i AVG FPS mellan 2700x och 8700k har mig veterligen ingen annan hittat i Wolfenstein 2.

Med det sagt, tomb raider. Det är intressant att du hoppar över 1080p siffrorna, som faktiskt är det som testas i gamestar. Här har ju techpowerup radat upp Ryzen i prestandatoppen för 1080p. Ett liknande resultat finner man i 1440p. För 4k är allting så GPU-begränsat att skillnaden är för osäker. Men vi kan se en svag trend att ju högre upplösning, ju större relativt övertag får Ryzen. Hur ser det ut för det nya tomb raider enligt computerbase?

Låt oss vara överens om att 4k AVG är för osäkra att dra några slutsatser från. Men 99:de percentilen berättar en historia som jag skulle påstå är intressant. Vid 1080p har intel övertag i alla API:n (ställer 8100 mot 2400g och 8700k mot 2700x, för att det är de som finns tillgängliga i testet). Men när man går upp till 4k så gynnar samtliga API:n Ryzen. I tre av fyra fall med 5%. Detta har nödvändigtvis ingenting med API:erna att göra, utan kan t.ex vara kod som är mer lämpad för Ryzen under en (delvis) GPU bottleneck. Vega kan möjligtvis ha lagt sig mellan där Intel gör bra från sig och där ingen skillnad visas

Hur ser det ut överlag då? Är det alltid så att 99:de percentilen konvergerar mot 0 skillnad om vi går från 1080p till 4k? Jag tog siffrorna för de spel som jag kunde hitta som computerbase testat 2700x och 8700k, (tror jag missade en, men den visade konvergens mot 0). Vi ser att i normalfallet så konvergerar faktiskt 99:de percentilen mot 0 skillnad vid 4k. Utom i två fall, ena är Age of empires remake (kan ej förklara denna) och *trumvirvel* Tomb raider. Alltså är den cherry pickad, nog mest för att resultatet är intressant.

Civilization hade förresten problem med NVIDIA:s drivers. Det första tecknet var när hardware unboxed fick mycket bättre siffror för 1600x än 7700k , men enbart med Vega64 och inte med GTX 1080. Detta korrigerades långt senare. Också den dåliga prestanda när man gick från 16 kärnor till 32 (till den mån det var möjligt, då 2990WX kommer ha stora latensproblem i alla fall). Poängen är att AMD har haft en hel del otur med NVIDIA:s drivers tidigare. Kanske Intel har motsvarande problem med AMD:s drivers ibland?

Vad jag försökte säga i inlägget innan att om man tittar på resultatet i sin helhet känns det fullt rimligt då CB får precis det genomsnittliga resultat andra får när man är helt CPU-bunden och primärflaskhalsen är heltalsberäkningar.

Är så vitt jag vet ingen annan som jämfört R7-2700X och i7-8700K ihop med RTX 2080Ti så här långt, men vi lär få ett gäng sådana resultat när Intels 9000-serie lanseras. Har ändå försökt kolla runt vad andra fått för genomsnittlig FPS när de testade RTX 2080Ti, just Wolfenstein 2 sticker ut då CB fått rätt låg genomsnittlig FPS där.

Vad man dock direkt kan säga om Wolfensten 2 är att variansen mellan olika webbplatser resultat i denna titel är väldigt hög, betydligt högre än i princip alla andra titlar.

Däremot så stämmer GTA 5 och Warhammer bra överens med vad AnandTech fått. Assassin's Creed Origins, GTAV är i linje med t.ex. TechPowerUp (TPU ligger något högre). I Ghost Recon Wildlands ligger CB högre jämfört med TechPowerUp.

Här får man dock tänka på att TPU kör ju med DDR4-3867 medan AnandTech kör med DDR4-3200. CB använder snabbaste officiell hastigheten, så DDR4-2933 för Ryzen och DDR4-2666 för Coffee Lake.

Vidare kör ju CB inte med inbyggd benchmark i något läge utan en egenkomponerad slinga. Det är både bra och dåligt. Bra då man kör det "riktiga" spelet (även om man garanterat valt "intressanta" fall som i detta fall är extra CPU-tunga). Dåligt då det blir väldigt svårt för andra att reproducera, här borde man i alla fall lagt upp videos på varje testslinga.

Angående kommentarerna så är en väldigt stor andel av dessa gnäll om orimligt resultat, t.ex. med motiveringar som "varför testar man RTX 2080Ti i 1920x1080 och inte 4k" och andra som visar att man totalt missat poängen med testet.

Andra försöker sig på en lite djupare analys, där tror jag man ser en annan stor orsak till varför folk upplever resultat som orimligt

"man sollte sich mal gedanken drüber machen, wieso der 8700k mit so einem geringen taktvorteil (single 4,7 vs 4,3 - multi 4,3 vs 4,1 ghz) bei quasi identischer IPC einen abstand zum 2700x von 30% erreicht."

D.v.s. man är helt övertygad över att IPC är mer eller mindre lika mellan Zen och Coffee Lake, vilket är helt sant om man använder Cinebench som referens (eller något annat program där primär flaskhals är skalära flyttal). Det är inte i närheten sant när flaskhalsen är heltalsberäkningar, vilket är fallet för spel.

Som jag pekade på i förra inlägget finns en lång rad olika tester som pekar på att IPC-skillnaden där är 20-25 %, det visar 720p tester med GTX 1080 och även tester som inte har något med spel att göra men där flaskhalsen ändå är heltal (t.ex. heltalstesterna i Geekbench 4, ser också ungefär den skillnaden för de CPU-tunga uppgifter i mitt arbete).

Det kopplat mot att CB så här långt är rätt ensamma om att använt RTX 2080Ti som GPU i speltester som fokuserar på CPU-bundna fall ger självklart ett resultat som inte direkt liknar något annat (det liknar definitivt inga tidigare tester i 1920x1080, men finns liknande i 1280x720).

I CB tråden finns även spekulationer om att man skulle köra utan Meltdown-patchar på Intel. Finns ju inte något som tyder på det, men det berör en relevant punkt. När 2700X/2600X testerna utfördes hade AMD precis fått ut sina patchar mot Spectre variant 2, de kom i Windows-uppdateringen 10:e april och lanseringen av 2000-serien var den 19:e.

Spectre variant 2 patchar kräver dock också uppdatering av firmware, något som rullades ut i form av moderkortsuppdateringar. Dessa uppdateringar fanns inte tillgängliga den 19:e, d.v.s. alla tester utfördes i praktiken utan patchar för Spectre variant 2 på Ryzen (medan Intel-system patchades i mars mot detta, man fick ju dra tillbaka den patch som lanserades i januari).

Fixarna för Spectre variant 2 ger precis som Meltdown patchar rätt stor prestandapåverkan i vissa lägen. Ovanpå det har Intel gjort flera justeringar av patcharna för Meltdown, primärt för Skylake. Man har lyckats minska prestandapåverkan.

Så även på samma plattform kan bör man idag förvänta sig något lägre prestanda på Ryzen (p.g.a. att ett fullt patchat system har numera Spectre varaiant 2 fixar rullande) medan Skylake baserade CPUer fått lite bättre prestanda (p.g.a. bättre optimerade Meltdown-fixar). Ingen aning hur stor denna påverkan är, det borde vi få en bra känsla för när testerna för Intels 9000-serie rullas ut. Vad jag sett är att spel ser en viss påverkan, men den är liten jämfört med vad man får i vissa server-laster.

Ser väldigt lite värde i att nagelfara enskilda resultat. Gillar man inte Wolfenstein 2 resultatet, ta bort det: totalresultatet blir ju i sak ändå detsamma.

Just att resultatet i sin helhet är fullt rimligt säger borde ju endera betyda att

man har fabricerat siffrorna, men man har ändå haft koll på vad man borde få för resultat

man har gjort något helt galet och bara av ren slump råkat få det som ändå känns rätt rimligt i ett nära nog rent CPU-bundet fall (d.v.s. i genomsnitt stämmer resultatet men vad andra fått)

alla mätningar där heltalberäkningar är primär flaskhals är fel

Inget av ovan är omöjlig, men inget känns heller speciellt sannolikt.

Angående konvergens när GPU blir flaskhals. Finns överhuvudtaget något teknisk rimligt förklaring till att man kan förvänta sig ett annat resultat än att skillnaden mellan CPU-modeller går mot noll-ish här?

Kommer självklart finnas en viss varians, kan definitivt även finnas en en viss konstant prestandaskillnad. Men dessa skillnader kommer ligga väl under 10 %. Jobbar väldigt mycket med prestandakritisk programvara och vi har internt väldigt mycket debatterat hur stor skillnaden i prestanda måste vara mellan två releaser för att det ska vara värt att behandla som en defekt.

Vi hade 5 % som cut-off i något läge, men det visade sig vara för lite då man ofta fick falska defekter. Fast bara på vissa plattformar och när man undersökte det fanns egentligen ingen rimligt förklaring mer än att saker skiftat runt lite i minne och därmed ändrade runtime beteende. I nästa release kunde samma konfiguration slå åt andra hållet...

Så vi kör med 10 % som cut-off, däremot måste man självklart även mäta prestanda över flera releaser så man upptäcker när saker sakta men säkert blir långsammare.

I min värld känns därför resultat plus/minus 5% som "cirkulera, inget att se". Vilket då rätt entydigt säger att i höga upplösningar blir CPU-delen irrelevant.

Man ska också ha i bakhuvudet att 99 % percentilen är känslig för oväntade händelser under mätningen. Enda sättet att dra några vettiga slutsatser kring detta är när man har ett gäng resultat som visar samma sak. Ett enstaka lågt/högt värde säger egentligen ingenting.

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Citera flera

Citera

(2)

Jag tycker att man gärna pratar om cpu flaskhalsar och i många fall är det ju så att en cpu jobbar i 100% och inte kan utföra fler beräkningar än så, men tex min Ryzen kan i vissa spel ligga på 50-60 % på 4 kärnor medans resterande 2 nästan inte gör något alls och gpun ligger på 76-85 % . Sen har jag andra spel där alla kärnor och trådar jobbar i 50-65 % och gpun i 98-100,% . Ju nyare spel desto bättre är oftast multicore användningen , i Monster Hunter world ligger alla kärnor och trådar i 55- 65,% och gpun i 95-100 % (oftast 98-100,%) , asassins creed spelet och frostbite engine är också bra på att utnyttja många kärnor. Jag hävdar att det snarare är spelet som är flaskhalsen om en cpu har mer än 30-40 ,% kvar att ge och gpun inte jobbar till fullo än att det är cpun som är flaskhalsen, annars så skulle alla spel ligga lika lågt i multicore använding med resultatet att inte gpun jobbar i 100%

Battlefield v är ju fortfarande i beta så där lär det hända saker innan det släpps.

Jag kör med en Ryzen 1600x i 3950Mhz och 16 Gb g-skill 3200Mhz klockat till 3333Mhz cl 14 14 14 28 och ett Asus 1080Ti 2025Mhz boost. Nästa år blir det Zen 2

Skickades från m.sweclockers.com

Senast redigerat

Visa signatur

Färdiga projekt The legacy of king Khufu.

https://www.sweclockers.com/galleri/2346-the-legacy-of-king-k...

Noctua ramkylare i aluminium: https://youtu.be/JmzCWlq3FKA

Chassie kylning: https://youtu.be/muxjWN7avwA

Citera flera

Citera

(1)

Skrivet av Yoshman:

Vad jag försökte säga i inlägget innan att om man tittar på resultatet i sin helhet känns det fullt rimligt då CB får precis det genomsnittliga resultat andra får när man är helt CPU-bunden och primärflaskhalsen är heltalsberäkningar.

Är så vitt jag vet ingen annan som jämfört R7-2700X och i7-8700K ihop med RTX 2080Ti så här långt, men vi lär få ett gäng sådana resultat när Intels 9000-serie lanseras. Har ändå försökt kolla runt vad andra fått för genomsnittlig FPS när de testade RTX 2080Ti, just Wolfenstein 2 sticker ut då CB fått rätt låg genomsnittlig FPS där.

Vad man dock direkt kan säga om Wolfensten 2 är att variansen mellan olika webbplatser resultat i denna titel är väldigt hög, betydligt högre än i princip alla andra titlar.

Däremot så stämmer GTA 5 och Warhammer bra överens med vad AnandTech fått. Assassin's Creed Origins, GTAV är i linje med t.ex. TechPowerUp (TPU ligger något högre). I Ghost Recon Wildlands ligger CB högre jämfört med TechPowerUp.

Här får man dock tänka på att TPU kör ju med DDR4-3867 medan AnandTech kör med DDR4-3200. CB använder snabbaste officiell hastigheten, så DDR4-2933 för Ryzen och DDR4-2666 för Coffee Lake.

Vidare kör ju CB inte med inbyggd benchmark i något läge utan en egenkomponerad slinga. Det är både bra och dåligt. Bra då man kör det "riktiga" spelet (även om man garanterat valt "intressanta" fall som i detta fall är extra CPU-tunga). Dåligt då det blir väldigt svårt för andra att reproducera, här borde man i alla fall lagt upp videos på varje testslinga.

Angående kommentarerna så är en väldigt stor andel av dessa gnäll om orimligt resultat, t.ex. med motiveringar som "varför testar man RTX 2080Ti i 1920x1080 och inte 4k" och andra som visar att man totalt missat poängen med testet.

Andra försöker sig på en lite djupare analys, där tror jag man ser en annan stor orsak till varför folk upplever resultat som orimligt

"man sollte sich mal gedanken drüber machen, wieso der 8700k mit so einem geringen taktvorteil (single 4,7 vs 4,3 - multi 4,3 vs 4,1 ghz) bei quasi identischer IPC einen abstand zum 2700x von 30% erreicht."

D.v.s. man är helt övertygad över att IPC är mer eller mindre lika mellan Zen och Coffee Lake, vilket är helt sant om man använder Cinebench som referens (eller något annat program där primär flaskhals är skalära flyttal). Det är inte i närheten sant när flaskhalsen är heltalsberäkningar, vilket är fallet för spel.

Som jag pekade på i förra inlägget finns en lång rad olika tester som pekar på att IPC-skillnaden där är 20-25 %, det visar 720p tester med GTX 1080 och även tester som inte har något med spel att göra men där flaskhalsen ändå är heltal (t.ex. heltalstesterna i Geekbench 4, ser också ungefär den skillnaden för de CPU-tunga uppgifter i mitt arbete).

Det kopplat mot att CB så här långt är rätt ensamma om att använt RTX 2080Ti som GPU i speltester som fokuserar på CPU-bundna fall ger självklart ett resultat som inte direkt liknar något annat (det liknar definitivt inga tidigare tester i 1920x1080, men finns liknande i 1280x720).

I CB tråden finns även spekulationer om att man skulle köra utan Meltdown-patchar på Intel. Finns ju inte något som tyder på det, men det berör en relevant punkt. När 2700X/2600X testerna utfördes hade AMD precis fått ut sina patchar mot Spectre variant 2, de kom i Windows-uppdateringen 10:e april och lanseringen av 2000-serien var den 19:e.

Spectre variant 2 patchar kräver dock också uppdatering av firmware, något som rullades ut i form av moderkortsuppdateringar. Dessa uppdateringar fanns inte tillgängliga den 19:e, d.v.s. alla tester utfördes i praktiken utan patchar för Spectre variant 2 på Ryzen (medan Intel-system patchades i mars mot detta, man fick ju dra tillbaka den patch som lanserades i januari).

Fixarna för Spectre variant 2 ger precis som Meltdown patchar rätt stor prestandapåverkan i vissa lägen. Ovanpå det har Intel gjort flera justeringar av patcharna för Meltdown, primärt för Skylake. Man har lyckats minska prestandapåverkan.

Så även på samma plattform kan bör man idag förvänta sig något lägre prestanda på Ryzen (p.g.a. att ett fullt patchat system har numera Spectre varaiant 2 fixar rullande) medan Skylake baserade CPUer fått lite bättre prestanda (p.g.a. bättre optimerade Meltdown-fixar). Ingen aning hur stor denna påverkan är, det borde vi få en bra känsla för när testerna för Intels 9000-serie rullas ut. Vad jag sett är att spel ser en viss påverkan, men den är liten jämfört med vad man får i vissa server-laster.

Ser väldigt lite värde i att nagelfara enskilda resultat. Gillar man inte Wolfenstein 2 resultatet, ta bort det: totalresultatet blir ju i sak ändå detsamma.

Just att resultatet i sin helhet är fullt rimligt säger borde ju endera betyda att

man har fabricerat siffrorna, men man har ändå haft koll på vad man borde få för resultat

man har gjort något helt galet och bara av ren slump råkat få det som ändå känns rätt rimligt i ett nära nog rent CPU-bundet fall (d.v.s. i genomsnitt stämmer resultatet men vad andra fått)

alla mätningar där heltalberäkningar är primär flaskhals är fel

Inget av ovan är omöjlig, men inget känns heller speciellt sannolikt.

Att Wolfenstein 2 har olika resultat är p.g.a att ALLA har en egen testslinga, men INGEN har fått så låga resultat för 2700x som CB utan en klar GPU bottleneck. Om man testar med 2700x och 8700k så är de fortfarande jämförbara, givet att man kör samma slinga.

Det här handlar inte om "Presterar 8700k bättre än 2700x?". Vi kan redan svaret på den frågan, att 8700k > 2700x. Det är inte heller relevant att leta efter 2080ti jämförelser mellan 2700x och 8700k. CB får bara ett 4% högre resultat med 2080ti än 1080ti, så varför skulle det vara relevant? (Jag tycker även det är en orättvis beskrivning mot NVIDIA, då testet säger att 2080ti är pengar i sjön när man kan köpa ett 1080ti). Man kan inte heller slänga bort resultat som man inte gillar, det är cherry picking. Sedan så kan ju felet som ett resultat i stor mån berodde på fortplanta sig i de andra testen. Anandtech fick stor kritik p.g.a att de hade en HPET bug som gjorde så att Intel fick mycket sämre resultat än vad de fått tidigare. Ibland var skillnaden enorm, ibland var den försumbar. Somliga har även auto överklockning utanför specifikationen utan att de vet om det. Vad jag försöker säga är att resultat som inte är relaterbara till alla andra kan ha att göra med möjliga fel. Det har hänt förut, och det kommer hända igen.

Sedan om jag ska gå igenom alla deras resultat. GTA5 har jag inga problem med, likaså har jag inga problem med overwatch. Det är inte för att resultaten är låga, utan för att de påminner om andra resultat jag sett.

I de andra spelen så finns det vissa osäkerheter, även om jag inte kan bevisa det då så många variabler varierar.

Här är t.ex överklockade 8700k mot 2700x.

Här är en som kört med 2700x , 8700k och 2080ti i överklockade tillstånd i 1080p och 4k (VARNING LJUD). Men även här saknas transparens, men får resultat som många andra får om man enbart ser på 8700k.

Här finns lite resultat i bland annat AC:O , Wolfenstein 2, Kingdom Come (men resultatet där känns orimligt?). Vet inte vilken GPU de använt.

Jämför gärna deras nuvarande resultat med de gamla. Även om de säger att det är "omöjligt".

Sedan så var väl en av styrkorna med 8700k (och även många andra av Intel processorer) att de även gjorde mycket bra från sig i spel med 2666 minne? 9% maximal skillnad med techpowerups setup. Givetvis var detta med en 1080, hade hellre sett större test och med 1080ti eller 2080ti. Svårt att hitta dessa dock...

En 43% skillnad i AVG och minimum i wolfenstein 2 mellan 2700x och 8700k tror jag någon aldrig kommer att hitta. Jag kan inte replikera deras låga 132 FPS AVG med 98 FPS 1% min. Jag har även kontrollerat att jag är GPU bunden. Det skulle dock vara mycket lättare att mäta om de inte sabbat performance profiler från DOOM till Wolfenstein 2. CPU siffrorna är synkroniserade mot GPU siffrorna, vilket gör det svårt att avgöra om man verkligen är CPU bunden. I de fall som jag sett är 8700k max ~17% snabbare.

Skrivet av Yoshman:

Angående konvergens när GPU blir flaskhals. Finns överhuvudtaget något teknisk rimligt förklaring till att man kan förvänta sig ett annat resultat än att skillnaden mellan CPU-modeller går mot noll-ish här?

Kommer självklart finnas en viss varians, kan definitivt även finnas en en viss konstant prestandaskillnad. Men dessa skillnader kommer ligga väl under 10 %. Jobbar väldigt mycket med prestandakritisk programvara och vi har internt väldigt mycket debatterat hur stor skillnaden i prestanda måste vara mellan två releaser för att det ska vara värt att behandla som en defekt.

Vi hade 5 % som cut-off i något läge, men det visade sig vara för lite då man ofta fick falska defekter. Fast bara på vissa plattformar och när man undersökte det fanns egentligen ingen rimligt förklaring mer än att saker skiftat runt lite i minne och därmed ändrade runtime beteende. I nästa release kunde samma konfiguration slå åt andra hållet...

Så vi kör med 10 % som cut-off, däremot måste man självklart även mäta prestanda över flera releaser så man upptäcker när saker sakta men säkert blir långsammare.

I min värld känns därför resultat plus/minus 5% som "cirkulera, inget att se". Vilket då rätt entydigt säger att i höga upplösningar blir CPU-delen irrelevant.

Man ska också ha i bakhuvudet att 99 % percentilen är känslig för oväntade händelser under mätningen. Enda sättet att dra några vettiga slutsatser kring detta är när man har ett gäng resultat som visar samma sak. Ett enstaka lågt/högt värde säger egentligen ingenting.

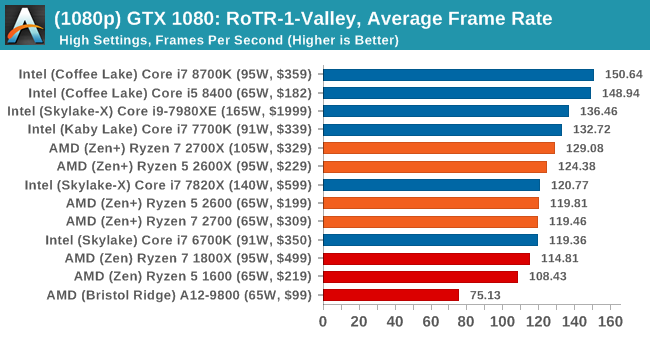

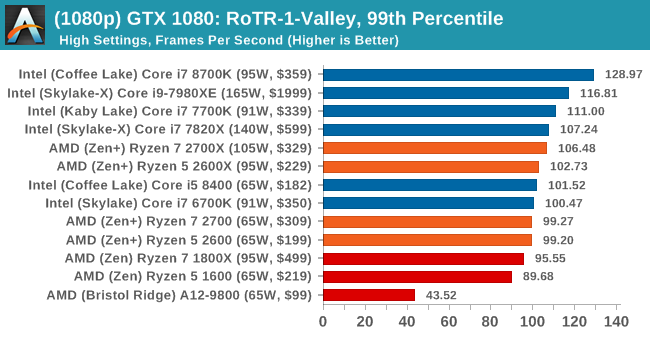

Ja, det ska konvergera mot 0 skillnad. Sedan så finns det fall som inte gör det. RoTR hade 2700X 8,5% högre AVG än 8700k i 1080p med 11 Ryzen modeller på topp, och 8,8% i 1440p med 13 Ryzen modeller på topp. Det känns liiiiite för osannolikt att det skulle vara varians som orsakade detta. Speciellt när Intels modeller var såpass ledande i 720p. Att sedan det nya tomb raider, som är mer tunggående och segare (tanke: som om upplösningen vore högre med samma kort) får ungefär lika bra relativa resultat med ryzen är inte så jättekonstigt. Det är ändå bara ett undantagsfall så det är inte så värt att lägga alltför mycket krut på det.

Citera flera

Citera

(1)

Skrivet av Radolov:

Ja, det ska konvergera mot 0 skillnad. Sedan så finns det fall som inte gör det. RoTR hade 2700X 8,5% högre AVG än 8700k i 1080p med 11 Ryzen modeller på topp, och 8,8% i 1440p med 13 Ryzen modeller på topp. Det känns liiiiite för osannolikt att det skulle vara varians som orsakade detta. Speciellt när Intels modeller var såpass ledande i 720p. Att sedan det nya tomb raider, som är mer tunggående och segare (tanke: som om upplösningen vore högre med samma kort) får ungefär lika bra relativa resultat med ryzen är inte så jättekonstigt. Det är ändå bara ett undantagsfall så det är inte så värt att lägga alltför mycket krut på det.

Enligt vilket test (TechPowerUp?)? Har läst en del i CB-tråden och där pekar väldigt många till att PC Games Hardware vet minsann hur man mäter för de får mycket mindre skillnad i prestanda mellan i7-8700k och R7-2700X (tror de flesta som säger det fortfarande helt missat poängen med mätningen CB gjorde där, det är inte ett test i förväntad spelprestanda utan ett rent test på CPU-råkraft om man explicit orsakar ett rent CPU-bundet fall).

Detta är i alla fall vad PCWH får när de testar just RoTR (notera att man har uppdaterat just detta resultatet efter patchar som förbättrade Ryzen-prestanda)

Dold text

Notera också att 99 % percentilen är lägre med DDR4-3400 jämfört med DDR-2667 för R7-2700X.

Edit: läste fel, såg att du sa att 720p gav fördel för Intel, men att de föll efter i 1080. Ska leta på något som visar det omvända

AnandTech får det omvända, d.v.s. i7-8700K är snabbare även i 1920x1080

Guru3D får i princip helt raka grafer i det spelet redan då de testar med GTX 1080 (vilket även AnandTech gjorde, men fick inte raka grafer...), inte någon fördel för Ryzen då det är GPU-bundet

Sett över alla testade titlar får även TechPowerUp exakt vad man förväntar sig, i princip samma prestanda på alla CPU-toppmodeller, det både i 1440p och 1800p. Så helt förväntat resultat när man tittar över flera titlar!

Inse hur totalt värdelöst ett enskilt värde är, går nästan alltid att gräva fram specifika resultat som visar precis vad som helst. Däremot kan man definitivt dra slutsatser när genomsnittet av många resultat pekar i en relativt entydigt riktigt.

Som t.ex. att snabbare RAM absolut hjälper till i spel förutsatt att man är CPU-bunden. Det sista är orsaken till att så många felaktigt dragit slutsatsen att Intel skulle skala sämre med snabbar RAM, orsaken är i stället att det är färre fall där man blir CPU-bunden så effekten av snabbare RAM blir därför lägre.

Sen ser man i CB tråden att många har en helt orealistiskt bild över hur stor effekten av snabbare RAM är. Vissa argumenterar för att om man bara stoppade i snabba DDR4-3200 minnen i Ryzen-systemet så skulle det gå ikapp i7-8700K.

Edit2: TechReport testade effekten av snabbare RAM i deras R7-2700X test. Man ser definitivt en fördel, rätt liten sådan men helt klart en fördel, med snabbare RAM i CPU-tunga spel. AC: Origins är känt för att vara väldigt tungt på 4C CPUer, vi ser också att i7-7700K är den modell som ser klart störts vinst från snabbare RAM i det testet (mycket större än både Ryzen och i7-8700K). Deus Ex (som också skalar rätt bra med CPU-kärnor) uppvisar en liknande trend.

Man får ta CB testet för vad det är: en form av syntetiskt test där man specifikt skapat extremt CPU-bunda spelfall. På många sätt kommer resultaten här inte likna vad man sett på andra håll, men givet CPU-kraft för skalära heltal är deras resultat fullt rimligt.

Senast redigerat

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Citera flera

Citera

(2)

@Yoshman: Ja det var techpowerup som jag länkat förut. De visade de resultaten.

Anandtech såg jag också, vilket även visade att 7980XE gjorde bra från sig. Det finns en möjlighet att AMD gjort vissa NUMA optimeringar, om jag måste spekulera. I techpowerups 2950X review så hamnar den också på samma ställen som alla andra ryzens, men 7900X, som den jämförs med, får bra resultat med.

Anandtech visar dock en tredjedel av resultaten (då benchmarket innehåller 3 scener, de tog bara resultatet från första scenen.) Som du ser så är även Ryzen på topp i 4k minimum. Men 4k var inom varians redan med ett 1080ti, så 1080 får man inte ut så mycket relevant info från. Flaska med måtta, I suppose . PCGH gav inte heller någon specifikation, annat än att de testade "Assassin's Creed Origins: "Alexandria"" i tomb raider, vilket höjer ett eller annat ögonbryn. Det finns många av dessa tomb raider benchmarks på youtube, det är bara att kolla om man är intresserad av det. Kan TP få ett resultat så kan även andra få det också, inklusive gamestar. Som jag sagt tidigare, det är inte så mycket att hänga upp sig på.

Men om du hittar ett 2700X benchmark som inte är GPU bundet i wolfenstein 2 som får ett genomsnitt på 135 FPS och minimum på 100 med någon av R7/R5 2600+ så är det bara att hojta till så lovar jag att testa om så är fallet. Om 8700k kan köra harpan 200ggr snabbare än 2700x påverkar inte detta resultat.

Citera flera

Citera

(1)

Skrivet av ramlösa:

Suck!!!! Whut???

Läste du ens mitt första inlägg och vad jag svarade på??

Han hade ett RTX2080 som i princip presterar som ett överklockat 1080ti och jag refererade Sweclockers test i BFV för att han var intresserad av BFV, vad är det du saknar???

https://cdn.sweclockers.com/artikel/diagram/14916?key=4c892ae92460b6e8f43f5a23ef7b3980

Är så nära en objektiv sanning du kommer med de uppsatta parametrarna.

"Varför kör du 1080 upplösning med dessa kort?" Vet inte om du spelar Xbox 30fps och tycker det är okej, men vi som spelar FPS-religiöst sitter oftast på 144hz skärmar. Tittar du i grafen så är du inte i närheten av 144fps, så en högre upplösning hade varit ett ganska dåligt alternativ.

Är alltid en balans, men om målet är 144fps i 1080p i BFV är Ryzen 5 2600X en extrem flaskhals.

Sen finns också andra sidan av myntet, en 8700k behöver kanske inte bytas ut vid nästa GPU byte, istället för en 2600x som flaskar redan idag. Plötsligt går också ekonomin ihop när du kanske kan hoppa över en uppgraderingscykel.

PS, största vinsten i ram är upp till 3000mhz och prisskillnaden är typ en hundralapp för 16gb.

Det jag reagerade på dock när jag läste den artikeln var hur otroligt avvikande prestandanivåer de fick.

https://cdn.sweclockers.com/artikel/diagram/14914?key=5546696...

Ta en titt på denna, ur samma artikel.

Detta är med 8600k från vinterdatorn och olika kort.

116/69 vs 104/61.

Samma karta

Båda 1080

Båda DX11

Båda Ultra

Så... du kan inte ta tester på dessa tidiga stadier på allvar för 5-öre. Det är för mycket variationer... med 10%+!

Sen kan jag hålla med om att för det spelet, i nuvarande status iaf, är 2600X, inte optimalt om du jagar hög FPS (och jag tror inte det ändras).

Det jag reagerade på är... vad säger att dyraste Intel CPUn är värt pengarna?

9700k eller 8700k kan vara fasens mycket mer värt pengarna. För den lilla vinst du får, även i din länkade bild, på 6 fps snitt, kan du lätt få med snabbare RAM, även över 3000Mhz, om du trimmar timings. Speciellt i minimum FPS märker du skillnad på detta, då det är när flaskhalser sätts in, som all extra marginal märks.

Så vad jag inte kan respektera här är, då BF1 testerna inte flaskas av CPUn (tom en i7 av den broadwell han har får snarlik prestanda som 8700k) och du kommer och säger att det är "självklart" att köpa det bästa.

Kan hålla med dig dock att man inte bör köpa dumsnålt... så hade han köpt 5775c hade han kunnat sitta kvar lite längre, men om det är som du säger, "FPS-religiöst" kan du aldrig hoppa över en generation. För du förlorar ju prestanda...

Så antingen som jag sa, om pengar inte är problemet, köp det bästa, eller... titta på vad som är mer prisvärt. För att lägga 4000kr på en ny CPU kan vara rätt dumt, om du kan få andra alternativ mer prisvärt. I hans fall hade detta varit en 5775c...

Skrivet av Doorfen:

Jag kör 1440 med ett RTX 2080 Ti. Min propp i7 6700k flaskar i BF1 samt även under BF5 Alpha 1, BF5 Alpha 2 samt BF5 Beta (BF5 med 1080ti). Mina lows är sisådär. Men som sagt alla har vi våra egna preferenser. Jag kör 1440p med medium till low preset plus en extremt modifierad config, detta ger en avg på 165 fps+ med lows (0.1%) runt 140fps.

Som sagt tidigare i den här tråden lirar man competitive så är det faktiskt värt att lägga pengarna på en bra propp. Lirar man witcher 3 lite slentrianmässigt casual i jalingarna så spelar det givetvis ingen roll alls.

Låt mig gissa... 2133 RAM? Kanske 2400?

Där har du varför din CPU flaskar.

Skylake blir slagen av både vettig haswell och broadwell om du har rätt RAM prestanda, och skylake kör på det skit som fanns när de kom. Och alla... inkl 9700k/9900k kommer flaska som F * N om du kör det med så långsamt RAM.

Du har i bästa fall 2133CL15 eller kanske 2400CL16 vilket ger ca 13-14ns. Detta är i klass med tidigt DDR3 1333/1066 eller och tom sämre än DDR2 800 CL5.

I normalt bruk, spelar detta mindre roll, men i DX11 spel, hamras den minnesbussen något enormt. Detta är varför Broadwell 5775c kan tom bråka med Kaby-Lake nivåer ibland, trots bara 1600Mhz RAM, för den har en cache som mildrar detta problem. Det sätt andra Intel CPU "löser detta" är med ren "bruteforce", i att CPUn kör så hög frekvens så även om den väntar på data hela tiden, får du hyfsad prestanda. Du tappar i frametimes och 1% low dock.

Så klocka upp eller byt ut ditt RAM, ska du se att du får upp rätt massivt i bandbredd.

Detta är äldre BF4, men samma grund i motorn, och lite olika setups. De kör 6500, men ändå bas vs OC vs RAM. Ta en titt på framt-times med låg RAM prestanda, vs bara stock... 6500 med 3200 vs OCad CPU... ofta vinner du mer på snabbare RAM än OC av tom den CPUn. https://youtu.be/Er_Fuz54U0Y?t=446

Inser självklart att mycket hänt sedan dess. Men spelens krav blir tyngre och tyngre. Våra GPUer har mer och mer VRAM och texturer i Ultra nivå blir bara större och större. Detta är var RAM mängd och RAM prestanda kommer in. För när du hade 1GB VRAM, medium texturer i 1080-60Hz, spelade det ingen roll. Men med 100+ FPS med 16GB RAM och 8GB VRAM, spelar det sabla stor roll.

Så "lirar man competitive" är det värt att veta vad fan man ska lägga pengarna på. Och snabbare CPU är inte allt... det är bara en del av byggstenarna.

Citera flera

Citera

(1)

Skrivet av Paddanx:

Det jag reagerade på dock när jag läste den artikeln var hur otroligt avvikande prestandanivåer de fick.

https://cdn.sweclockers.com/artikel/diagram/14914?key=5546696...

Ta en titt på denna, ur samma artikel.

Detta är med 8600k från vinterdatorn och olika kort.

116/69 vs 104/61.

Samma karta

Båda 1080

Båda DX11

Båda Ultra

Så... du kan inte ta tester på dessa tidiga stadier på allvar för 5-öre. Det är för mycket variationer... med 10%+!

Sen kan jag hålla med om att för det spelet, i nuvarande status iaf, är 2600X, inte optimalt om du jagar hög FPS (och jag tror inte det ändras).

Det jag reagerade på är... vad säger att dyraste Intel CPUn är värt pengarna?

9700k eller 8700k kan vara fasens mycket mer värt pengarna. För den lilla vinst du får, även i din länkade bild, på 6 fps snitt, kan du lätt få med snabbare RAM, även över 3000Mhz, om du trimmar timings. Speciellt i minimum FPS märker du skillnad på detta, då det är när flaskhalser sätts in, som all extra marginal märks.

Så vad jag inte kan respektera här är, då BF1 testerna inte flaskas av CPUn (tom en i7 av den broadwell han har får snarlik prestanda som 8700k) och du kommer och säger att det är "självklart" att köpa det bästa.

Kan hålla med dig dock att man inte bör köpa dumsnålt... så hade han köpt 5775c hade han kunnat sitta kvar lite längre, men om det är som du säger, "FPS-religiöst" kan du aldrig hoppa över en generation. För du förlorar ju prestanda...

Så antingen som jag sa, om pengar inte är problemet, köp det bästa, eller... titta på vad som är mer prisvärt. För att lägga 4000kr på en ny CPU kan vara rätt dumt, om du kan få andra alternativ mer prisvärt. I hans fall hade detta varit en 5775c...

Låt mig gissa... 2133 RAM? Kanske 2400?

Där har du varför din CPU flaskar.

Skylake blir slagen av både vettig haswell och broadwell om du har rätt RAM prestanda, och skylake kör på det skit som fanns när de kom. Och alla... inkl 9700k/9900k kommer flaska som F * N om du kör det med så långsamt RAM.

Du har i bästa fall 2133CL15 eller kanske 2400CL16 vilket ger ca 13-14ns. Detta är i klass med tidigt DDR3 1333/1066 eller och tom sämre än DDR2 800 CL5.

I normalt bruk, spelar detta mindre roll, men i DX11 spel, hamras den minnesbussen något enormt. Detta är varför Broadwell 5775c kan tom bråka med Kaby-Lake nivåer ibland, trots bara 1600Mhz RAM, för den har en cache som mildrar detta problem. Det sätt andra Intel CPU "löser detta" är med ren "bruteforce", i att CPUn kör så hög frekvens så även om den väntar på data hela tiden, får du hyfsad prestanda. Du tappar i frametimes och 1% low dock.

Så klocka upp eller byt ut ditt RAM, ska du se att du får upp rätt massivt i bandbredd.

Detta är äldre BF4, men samma grund i motorn, och lite olika setups. De kör 6500, men ändå bas vs OC vs RAM. Ta en titt på framt-times med låg RAM prestanda, vs bara stock... 6500 med 3200 vs OCad CPU... ofta vinner du mer på snabbare RAM än OC av tom den CPUn. https://youtu.be/Er_Fuz54U0Y?t=446

Inser självklart att mycket hänt sedan dess. Men spelens krav blir tyngre och tyngre. Våra GPUer har mer och mer VRAM och texturer i Ultra nivå blir bara större och större. Detta är var RAM mängd och RAM prestanda kommer in. För när du hade 1GB VRAM, medium texturer i 1080-60Hz, spelade det ingen roll. Men med 100+ FPS med 16GB RAM och 8GB VRAM, spelar det sabla stor roll.

Så "lirar man competitive" är det värt att veta vad fan man ska lägga pengarna på. Och snabbare CPU är inte allt... det är bara en del av byggstenarna.

haha.. jo jag har rätt bra koll på vad man ska lägga pengarna på... läste du ens mitt inlägg?. LPX Black 16GB 3200MHz cl16. Står även i signaturen... Det är min propp som flaskar. Behöver fler kärnor.

Visa signatur

der8auer Core i9-9900K - delidded @ 5.1 ghz | ASUS ROG Maximus XI Hero | ASUS ROG STRIX GeForce RTX 3090 24GB Gaming OC | Rog Swift PG35VQ && Rog Swift PG27VQ | LPX Black 3200MHz 32gb | Logitech G Pro Wireless | Logitech G915 TKL Tactile | Sennheiser HDV820 | Sennheiser HD 800S | Swedish Match Ettan Orginal Portion | "-DICE please!?"|Min senaste youtube video -> https://youtu.be/OqIq_hh0BI8

Citera flera

Citera

Skrivet av Doorfen:

haha.. jo jag har rätt bra koll på vad man ska lägga pengarna på... läste du ens mitt inlägg?. LPX Black 16GB 3200MHz cl16. Står även i signaturen... Det är min propp som flaskar. Behöver fler kärnor.

Fler kärnor låter lite fel sagt dock, då som sagt 2600X med 12 trådar inte nödvändigtvis är bättre.

Jag tror mer på ineffektivt spel, helt ärligt då BF1, med i grunden samma motor inte har dessa problem på samma sätt. Sitter du redan på DDR4 dock så kan jag förstå att det är värt att gå upp till nyare plattform.

Ang din kunskap med minne, du sitter på 10ns moduler... mao grattis till att matcha DDR3 1600 CL8, eller lite bättre än 2133 CL11. Detta är nivån jag klockar upp beg no-name DDR3 moduler. Du behöver inte mer frekvens... 3000-3200 räcker troligen rätt bra, men latensen vill du ha ner för DX11 spel och hög fps.

Justera deras timeings... så får du dina FPS. För din CPU "väntar" rätt mycket på RAM latensen när du har så hög frekvens som du har (4.8Ghz) på CPU och bokstavligt talat är det precis lika segt som att vänta på postnord, för CPUn. Är du prestanda jagande, vill du ha ner det till iaf 9ns, för även 8700k flaskas rätt hårt i 5Ghz+ av dessa när man vill ha ner frame-time. Är bra början med 3200 minne dock

Citera flera

Citera

Skrivet av Paddanx:

Fler kärnor låter lite fel sagt dock, då som sagt 2600X med 12 trådar inte nödvändigtvis är bättre.

Jag tror mer på ineffektivt spel, helt ärligt då BF1, med i grunden samma motor inte har dessa problem på samma sätt. Sitter du redan på DDR4 dock så kan jag förstå att det är värt att gå upp till nyare plattform.

Ang din kunskap med minne, du sitter på 10ns moduler... mao grattis till att matcha DDR3 1600 CL8, eller lite bättre än 2133 CL11. Detta är nivån jag klockar upp beg no-name DDR3 moduler. Du behöver inte mer frekvens... 3000-3200 räcker troligen rätt bra, men latensen vill du ha ner för DX11 spel och hög fps.

Justera deras timeings... så får du dina FPS. För din CPU "väntar" rätt mycket på RAM latensen när du har så hög frekvens som du har (4.8Ghz) på CPU och bokstavligt talat är det precis lika segt som att vänta på postnord, för CPUn. Är du prestanda jagande, vill du ha ner det till iaf 9ns, för även 8700k flaskas rätt hårt i 5Ghz+ av dessa när man vill ha ner frame-time. Är bra början med 3200 minne dock

Jahap den ordbajsande kvacksalvaren slår till igen.... Har du lässvårigheter ? Jag kör XMP profilen rakt av. Läste du vilka siffror jag presenterade för 1440p? De är exakt i linje med vad man kan förvänta sig med en 6700k samt 2080ti i kombination med LPX Black CL16 3200mhz.

Sedan till mina lows, som inträffar då flera kärnor lastar 100 eller runt 100% ( eller mer exakt när någon logisk kärna. dvs någon tråd taxar runt 100%). Det är också förväntat beteende, spelar ingen roll om man sitter på en 6700k, 7700k. Möjligtvis så inträffar det mer sällan för 8700k pga två extra kärnor relativt min prop. BF serien är välkänd för att taxa CPUn hårt..

Blir spännande att se hur BF1, BF5 skalar med en i9 9900k ( 8 kärnor, 16 trådar)

Senast redigerat

Visa signatur

der8auer Core i9-9900K - delidded @ 5.1 ghz | ASUS ROG Maximus XI Hero | ASUS ROG STRIX GeForce RTX 3090 24GB Gaming OC | Rog Swift PG35VQ && Rog Swift PG27VQ | LPX Black 3200MHz 32gb | Logitech G Pro Wireless | Logitech G915 TKL Tactile | Sennheiser HDV820 | Sennheiser HD 800S | Swedish Match Ettan Orginal Portion | "-DICE please!?"|Min senaste youtube video -> https://youtu.be/OqIq_hh0BI8

Citera flera

Citera

Skrivet av Doorfen:

Jahap den ordbajsande kvacksalvaren slår till igen.... Har du lässvårigheter ? Jag kör XMP profilen rakt av. Läste du vilka siffror jag presenterade för 1440p? De är exakt i linje med vad man kan förvänta sig med en 6700k samt 2080ti i kombination med LPX Black CL16 3200mhz.

Sedan till mina lows, som inträffar då flera kärnor lastar 100 eller runt 100% ( eller mer exakt när någon logisk kärna. dvs någon tråd taxar runt 100%). Det är också förväntat beteende, spelar ingen roll om man sitter på en 6700k, 7700k. Möjligtvis så inträffar det mer sällan för 8700k pga två extra kärnor relativt min prop. BF serien är välkänd för att taxa CPUn hårt..

Blir spännande att se hur BF1, BF5 skalar med en i9 9900k ( 8 kärnor, 16 trådar)

Förlåt då, jag försökte bara ge dig tips att XMP "Stock" inte alltid är bästa.

Vet mycket väl att BF är kända för att taxa CPUn hårt. Och därför vill du maximera hur mycket CPUn jobbar... inte sitter IDLE väntan på RAM.

Köp nytt då, om du blir glad

Citera flera

Citera

Skrivet av Paddanx:

Det jag reagerade på dock när jag läste den artikeln var hur otroligt avvikande prestandanivåer de fick.

https://cdn.sweclockers.com/artikel/diagram/14914?key=5546696...

Ta en titt på denna, ur samma artikel.

Detta är med 8600k från vinterdatorn och olika kort.

116/69 vs 104/61.

Samma karta

Båda 1080

Båda DX11

Båda Ultra

Så... du kan inte ta tester på dessa tidiga stadier på allvar för 5-öre. Det är för mycket variationer... med 10%+!

Sen kan jag hålla med om att för det spelet, i nuvarande status iaf, är 2600X, inte optimalt om du jagar hög FPS (och jag tror inte det ändras).

Det jag reagerade på är... vad säger att dyraste Intel CPUn är värt pengarna?

9700k eller 8700k kan vara fasens mycket mer värt pengarna. För den lilla vinst du får, även i din länkade bild, på 6 fps snitt, kan du lätt få med snabbare RAM, även över 3000Mhz, om du trimmar timings. Speciellt i minimum FPS märker du skillnad på detta, då det är när flaskhalser sätts in, som all extra marginal märks.

Så vad jag inte kan respektera här är, då BF1 testerna inte flaskas av CPUn (tom en i7 av den broadwell han har får snarlik prestanda som 8700k) och du kommer och säger att det är "självklart" att köpa det bästa.

Kan hålla med dig dock att man inte bör köpa dumsnålt... så hade han köpt 5775c hade han kunnat sitta kvar lite längre, men om det är som du säger, "FPS-religiöst" kan du aldrig hoppa över en generation. För du förlorar ju prestanda...

Så antingen som jag sa, om pengar inte är problemet, köp det bästa, eller... titta på vad som är mer prisvärt. För att lägga 4000kr på en ny CPU kan vara rätt dumt, om du kan få andra alternativ mer prisvärt. I hans fall hade detta varit en 5775c...

Som sagt allt är en balans men om vi sätter ett (ti) efter 2080 så har du plötsligt en GPU för 14k och då är 4k för en CPU inga större pengar.

Helt sjuka ockerpriser från Nvidia, min smärtgräns ligger vid max 6k för en GPU, men skulle jag lägga 10k för en GPU känns inte 4k för en CPU helt orimligt heller.

Citera flera

Citera

Skrivet av ramlösa:

Som sagt allt är en balans men om vi sätter ett (ti) efter 2080 så har du plötsligt en GPU för 14k och då är 4k för en CPU inga större pengar.

Helt sjuka ockerpriser från Nvidia, min smärtgräns ligger vid max 6k för en GPU, men skulle jag lägga 10k för en GPU känns inte 4k för en CPU helt orimligt heller.

Jo jag kan förstå det tankesättet, även om jag också anser det väldigt oprisvärt för att kunna köra någon inställning "lite högre" på samma FPS. För det är ju inga problem att få 144Hz normalt på ett spel. Frågan är vilka inställningar du är villig att lägga "10kkr extra" på. Men som jag sa i första svaret till dig. Är pengar inte problemet, så köper man så klart det bästa.

Citera flera

Citera

Skrivet av Ozzed:

Man får hoppas att AMD lyckas motstå frestelsen att höja priserna, som annars kanske är fördelaktigt kortsiktigt. Men här har de ju fördelen att Intel måste ha de priser de har, medans AMD har kapacitet nog att ligga kvar på nuvarande prisnivå. Så småningom kommer fler och fler börja fundra på om premiumpriset för Intel verkligen är värt den extra prestandad främst i spel.

Det är väl bra för alla om AMD böjar tjäna lite pengar? Det lär ju aldrig bli några investeringar eller nya konkurrenter om det inte är någon som tjänar pengar

Skickades från m.sweclockers.com

Citera flera

Citera

@Yoshman Vi har fått ett uppdaterat resultat. De hade fel, helt enkelt. Det stora problemet var windows installationen.

Skrivet av Radolov:

Man kan inte heller slänga bort resultat som man inte gillar, det är cherry picking. Sedan så kan ju felet som ett resultat i stor mån berodde på fortplanta sig i de andra testen. Anandtech fick stor kritik p.g.a att de hade en HPET bug som gjorde så att Intel fick mycket sämre resultat än vad de fått tidigare. Ibland var skillnaden enorm, ibland var den försumbar. Somliga har även auto överklockning utanför specifikationen utan att de vet om det. Vad jag försöker säga är att resultat som inte är relaterbara till alla andra kan ha att göra med möjliga fel. Det har hänt förut, och det kommer hända igen.

Såhär ser skillnaderna ut (på de spel som de jämfört med, 2700x mot 8700k). Geometriskt medelvärde från 31% snabbare till 21% snabbare.

Nu kan du förstå varför jag reagerade så starkt mot Wolfenstein 2. Gör det någon större skillnad att de ändrat till Mein Leben för den relativa skillnaden? Tror inte det, 2080ti är så brutalt snabb i wolfenstein 2 ändå att det skulle motsvara ett 720p test i vilket annat spel som helst. Men under 20% skillnad har jag sett där som mest.

Citera flera

Citera

(1)

Skrivet av Yoshman:

Du skrev 2600K två gånger så utgår från att det inte är ett skrivfel. Stämmer verkligen det du skriver om man jämför FX-8350 och i7-2600K? Jämför man SweC test av FX-8350 med sista gången de hade med den CPU (testet av i7-8700K) så är det inom rimlig felmarginal exakt samma spelprestanda i 720p, ca 20 % fördel för i7-2600K.

AdoredTV stod och cherry-picka resultat från olika testsajter för att framhäva 8350 som den där smarta framtidssäkra arkitekturen i en video en gång och sen började det tas som något faktum i vissa trådar

(Never mind också att man förbiser faktum att 8350 inte ens lanserades i närheten av när 2500K/2600K gjorde.. 83** var ju deras år-senare refresh, så jämförelsen var vägd till Intels nackdel från början och trots det så ja..)

Visa signatur

i7-2700K 5GHz | 16GB DDR3-1600 | ASUS Maximus V Gene | GTX 980

Citera flera

Citera

Skrivet av Radolov:

@Yoshman Vi har fått ett uppdaterat resultat. De hade fel, helt enkelt. Det stora problemet var windows installationen.

Såhär ser skillnaderna ut (på de spel som de jämfört med, 2700x mot 8700k). Geometriskt medelvärde från 31% snabbare till 21% snabbare.

https://i.gyazo.com/37b9d1931889c7437a6a0bc4b0e354a3.png

Nu kan du förstå varför jag reagerade så starkt mot Wolfenstein 2. Gör det någon större skillnad att de ändrat till Mein Leben för den relativa skillnaden? Tror inte det, 2080ti är så brutalt snabb i wolfenstein 2 ändå att det skulle motsvara ett 720p test i vilket annat spel som helst. Men under 20% skillnad har jag sett där som mest.

Well, kolla in dagens test av i9-9900K och i7-9700K. Med RTX 2080Ti + 1280x720 kan vi vara hyfsat säkra på att flaskhalsen är CPU och inte GPU.

i7-8700K är över de spel man testar 26 % snabbare, då har Intel (som sig bör då man kör "stock") långsammare RAM. D.v.s. resultatet man får nu verkar inte heller helt korrekt (om vi nu antar att SweC är korrekt, men tror ändå det då det är rätt mycket vad Geekbench 4 visar när man kollar heltalstesterna och där har man tagit bort GPU som felkälla).

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Citera flera

Citera

Skrivet av Yoshman:

Well, kolla in dagens test av i9-9900K och i7-9700K. Med RTX 2080Ti + 1280x720 kan vi vara hyfsat säkra på att flaskhalsen är CPU och inte GPU.

Oja, något annat hade varit rätt så tragiskt.

Skrivet av Yoshman:

i7-8700K är över de spel man testar 26 % snabbare, då har Intel (som sig bör då man kör "stock") långsammare RAM. D.v.s. resultatet man får nu verkar inte heller helt korrekt (om vi nu antar att SweC är korrekt, men tror ändå det då det är rätt mycket vad Geekbench 4 visar när man kollar heltalstesterna och där har man tagit bort GPU som felkälla).

CB körde 14-14-14-34-1T medan Swec 15-15-15-35 samt olika urva av spell och scener. Men jag hade gärna sett resultaten vid 14-14-14-34-1T för sweclockers tester också. Helst hade jag sett mer in depth på subtimings också, fast de har med största säkerhet tidspress på att få ut recensionen. 26% och 21% är förvånansvärt nära, givet alla olika spel/testslingor och så. Mig gör det ingen skillnad om 21% eller 26% är "sant". Jag kunde bara konstatera att resultaten från CB:s första test var felaktiga, då inget sådant resultat existerade i Wolfenstein 2 varken när jag letade efter det eller som uppmätts av någon annan.

Jag skulle inte direkt säga att någon bild är sannare än den andra i det här fallet. Bara att olika konfigurationer, som testats under olika förutsättningar får olika resultat. (Talar om swec i relation till CB).

Citera flera

Citera

Skrivet av Radolov:

Oja, något annat hade varit rätt så tragiskt.

CB körde 14-14-14-34-1T medan Swec 15-15-15-35 samt olika urva av spell och scener. Men jag hade gärna sett resultaten vid 14-14-14-34-1T för sweclockers tester också. Helst hade jag sett mer in depth på subtimings också, fast de har med största säkerhet tidspress på att få ut recensionen. 26% och 21% är förvånansvärt nära, givet alla olika spel/testslingor och så. Mig gör det ingen skillnad om 21% eller 26% är "sant". Jag kunde bara konstatera att resultaten från CB:s första test var felaktiga, då inget sådant resultat existerade i Wolfenstein 2 varken när jag letade efter det eller som uppmätts av någon annan.

Jag skulle inte direkt säga att någon bild är sannare än den andra i det här fallet. Bara att olika konfigurationer, som testats under olika förutsättningar får olika resultat. (Talar om swec i relation till CB).

Visst kan man bolla procentsiffror, sedan är man inte heller helt GPU-bunden i 1920x1080 om man kör "ultra" ens med RTX 2080Ti (vilket vi också ser i SweC tester).

SweC siffror visar ändå det jag försökte visa med CB resultaten: spelprestanda i Skylake är ~20 % högre vid isofrekvens jämfört med Zen. Det kan varierar mellan 15-25 % lite beroende exakt på vad flaskhalsen är, så vilka titlar man testar har absolut relevans om man har en litet utbud (och fem titlar är statistisk sett ett väldigt litet utbud). 25 % har jag nog bara sett i fall där Intel-systemet har lika snabbt RAM, både SC och CB kör ju med 2666 MT/s vs 2933 MT/s, något som är en fördel i spel.

Gissningsvis fanns det något i CB initiala system som gjorde att spelen blev mer CPU-bundna än normalt, då fick man det resultat som är helt förväntat när GPU-delen i praktiken är helt ute ur ekvationen.

SC körde 1280x720 "medium", det visar två saker jag försökt belysa. Dels var "IPC" skillnaden i spel ungefär ligger på, men tycker det är mer värt att det också visar att GB4 resultaten faktiskt är en riktigt bra indikator på prestanda i "verkliga" program.

Plockar man ut resultaten från de deltester som mäter heltal ser man väldigt mycket samma relativa skillnad mellan Intel/AMD som man ser i spel, det förutsatt att man jämför modeller med samma mängd CPU-trådar (GB4 resultaten skalar bättre med CPU-kärnor än vad spel gör).

Kan från egna mätningar säga att LLVM testet är en väldigt bra indikator på kompileringsprestanda samt att "Lua" testet är en hyfsad indikator på relativ prestanda i interpreterade språk som Python, BASH, m.fl. (men inte JavaScript då i princip alla JS motorer är JIT:ade, relativ prestanda där är mer lik spelprestanda).

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Citera flera

Citera

Hårdvara

- Igår Corsair Platform 6: För dig som inte nöjer dig med Ikea-skrivbord 5

- Igår Rykte: Switch 2 släpps i höst – OLED-variant dröjer 26

- Igår Iphones marknadsandel faller i USA 42

- 25 / 4 Airtec Pro Type1 – batteridrivet alternativ till tryckluft på burk 79

- 25 / 4 Nu stiger hårddiskpriserna med uppemot 10 procent 21

Mjukvara

Datorkomponenter

Ljud, bild och kommunikation

- Corsair Platform 6: För dig som inte nöjer dig med Ikea-skrivbord6

- någon som använder Xpenology ? (NAS)3

- Köpråd för ny gaming dator, runt 25k11

- Elbilar - Tråden för intresserade23189

- Vilket VR-headset ska jag köpa?881

- NetonNet varnar om läckta kunduppgifter18

- Oskäligt negativt omdöme Tradera24

- Okänd enhet i enhetshanteraren5

- Rykte: Switch 2 släpps i höst – OLED-variant dröjer26

- Tråden för hörlursgalningar! Lurar, förstärkare, dacs, pads osv osv It´s all here!19835

- Säljes ASUS ROG STRIX GeForce GTX 1080 Ti 11GB Gaming OC

- Säljes Gamingdator, 7800X3D, RTX 4080 Super

- Säljes Samsung Galaxy Tab S9 Wi-Fi

- Köpes 24 eller 27 tum minst 144hz

- Säljes MSI GeForce GTX 1070 GAMING X 8G

- Säljes Garderobsrensning, möss och keycaps

- Säljes Acer 4K 144Hz XB273KGP - Gaming Prylar - Aio

- Säljes Spelkoder säljes

- Köpes NUC - gärna Intel 8th gen (Iris) men allt intressant

- Skänkes i386 Laptop Skänkes!

- Ny caps lock-symbol i Windows förbryllar HP-användare9

- Corsair Platform 6: För dig som inte nöjer dig med Ikea-skrivbord6

- Rykte: Switch 2 släpps i höst – OLED-variant dröjer26

- NetonNet varnar om läckta kunduppgifter18

- Premiär på SweClockers! Månadens drop med gamingskärm hos Elgiganten62

- IT-bolag: Teknikstrul är största tidsboven idag38

- Därför blockerar Windows 11 24H2 Start‑menyhack39

- Iphones marknadsandel faller i USA42

- Konsumentverket granskar tio nätbutiker som lurat kunder18

- Airtec Pro Type1 – batteridrivet alternativ till tryckluft på burk79

Externa nyheter

Spelnyheter från FZ

- Xbox-försäljningen dök 31 % årets första kvartal igår

- PS Plus-ägare får vänta på Fallout 4-uppdateringen igår

- Spelhelgen knackar på – den kommer med spel! igår

- Switch 2-rykten – Kan släppas 2024, kontrollerna får magnetfästen igår

- People Can Fly har skrotat sitt "banbrytande" action-RPG Project Dagger igår