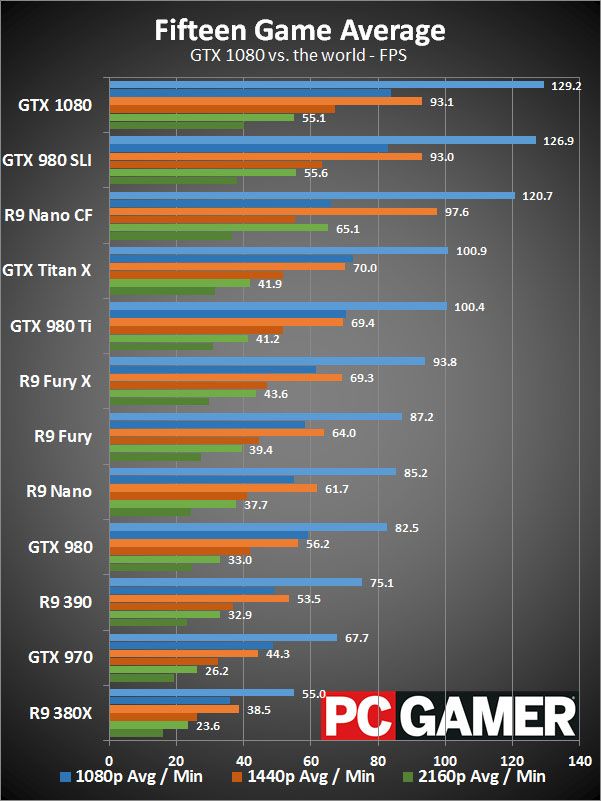

Ja, alltså det verkar ju som att nvidia hävdar att de fixat fram betydligt mer beräkningskraft per core.

Kan ha något med hur deras nya boostfrekvens funkar att göra:

"One of the new exciting features that Nvidia is debuting with the GTX 1080 and GTX 1070 is GPU Boost 3.0. The feature builds on GPU Boost 2.0 but is cleverer and more granular. The frequency curve is now dynamic and follows per voltage points as opposed to a fixed margin. The result is higher clock speeds and better voltage utilization which translates to superior performance per watt. And what it means is that while the GTX 1080’s boost clock is rated at around 1.7Ghz the card will on average boost to nearly 1.9Ghz. And the GTX 1070 will be no different, despite its lower boost clock of 1.6Ghz we should see a similar 200mhz uplift in average clocks while gaming."

Från: http://wccftech.com/gtx-1070-1920-cuda-cores/#ixzz48znMG7LS

Men 6.5 TFLOPS är nvidias officiella siffra:

http://images.nvidia.com/geforce-com/international/images/050...

Den där hade jag inte sett, om det stämmer att Polaris 10 ligger i paritet med Fury X så låter det nästan för bra för att vara sant (så jag är fortfarande lite skeptisk just därför).

6.5TFLOPS var deras officiella siffra. Du hittar inte den nu när de spikat antal kärnor. Så det kan vara så att de backat från det.

Och nä, det är nog inte relaterat till hur de räknar boost. I så fall skulle vi få se betydligt högre beräkningskapacitet på GTX 1080. De anger beräkningskapaciteten på 1080 vid basfrekvens. Eftersom 1070 har en basfrekvens under 1.7GHz så är dess beräkningskapacitet under 6.5 TFLOPS.