former wow addict

former daoc addict

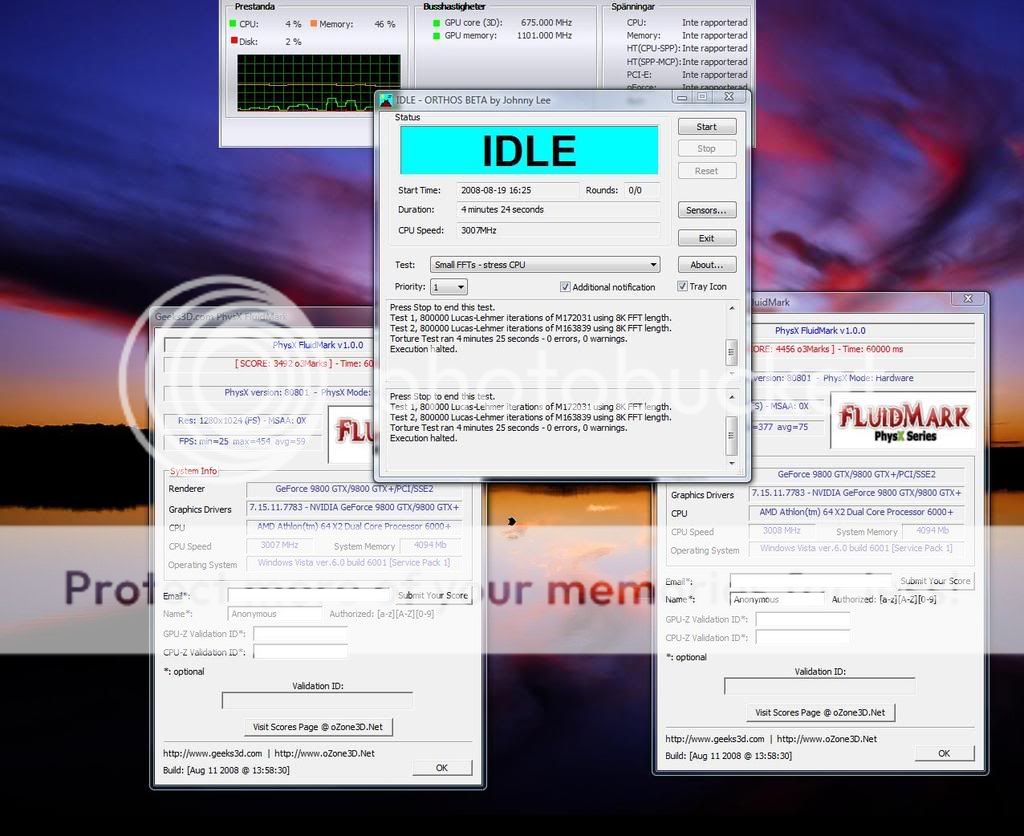

Nvidia PhysX beroende av CPU

Silverstone FT03B | Dell U2711 | Be-quiet E9 580w CM | ASUS GENE-Z | AMD 7970 | Intel 2500k @ 4,4 Ghz| Corsair H80i | 8GB Corsair LP

Xbox Live - Firaphex

Jag har inte alltid rätt, men jag utgår från det tills jag ser bevis på annat. Citera för svar

2008-06-18, Dagen då integriteten ställdes tå mot tå med maktmissbruket och förlorade.

Arch | 1440p 165Hz IPS | 7800X3D | 1080ti | 64GB@6GHz | SN850 2TB

Knowledge is not achieved until shared.

Xbox Live - Firaphex

Jag har inte alltid rätt, men jag utgår från det tills jag ser bevis på annat. Citera för svar

2008-06-18, Dagen då integriteten ställdes tå mot tå med maktmissbruket och förlorade.

WS:/ASUS M4A78-E/Phenom 940BE/OCZ Reaper DDR2 PC8500 6Gb/CF Ati 4870 1GB//Server: AMD Phenom 9550/MSI K9A2 CF-F/OCZ Reaper PC8500 2Gb/XFX GTS 250 Nvidia

"En enskild människas död är en tragedi, en miljon döda är statistik" -Josef Stalin

Athlon x2 5000+ BE_Stepping G2_14x200 = 2800mhz_ VCore 1.15

Vilka jävla nötter det finns här!

| nVidia RTX3090FE | R9 5950x | MSI x570 Unify | Ballistix sport 3000c15 32GB DR@3800c16 | Custom Loop EKWB | 9TB nvme, 3TB sata SSD | RM1000x | Creative X4 | Lian Li o11 Dynamic | Alienware aw3821dw | >Zen2 på 3-400 mobo< | >x570 VRM< | :::AMD Zen Minnesguide:::|:::AMD Zen & Zen+ Överklockningsguide:::

"The flames of freedom. How lovely. How just. Ahh, my precious anarchy.."

Gammal Värsting/ Core 2 Duo E6850 @3.6ghz / EVGA 680i Sli / Corsair Dominator 1066 4gb/ Gainward 8800 Ultra

Asus TUF Gaming WiFi | Ryzen 5600X | 32 GB Ballistix| Vega 56 | Newton R2 650 W

6700K @ 4,8GHz | 32GB | 3070

Fear only Fear itself. I am fear!

Amd Phenom II 965@4Ghz, Asus Crosshair II, 6Gb ddr2@6400, Corsair 620 WX, Antec P182B, Ati 5870, Intel X-25M G2 SSD, raptor m.m diskar :P

Asus P8Z68 Deluxe/Gen Sock 1155 -- Inte Core I7 2700K@4.5Ghz -- EVGA GeForce GTX 970 SSC GAMING ACX 2.0+ -- Corsair 16GB DDR3 Vengeance 1.5V Low Blue -- SSD OCZ Agility 3 120GB -- Microsoft Windows 7 -- Foldar med cirka 180k PPD (körs ej 24/7)

Gam dator: Rampage 3 Extrem, 6x4GB Ram lägsta hastighet på minnet är 1600mhz Högsta G.skill ripjaws 2133mhz + ramkylare, Processor(ER) 6Core12Trådig Xeon x5660 Men eftersom jag haft så jädra ont i ryggen har jag bara kommit till att ta ut gamla processorn den nya ligger ihopklistrad i ett brev en x5670(Kan vara 75) Iaf många multipliers högre. Ljudkort Asus Z. Några normala diskar + 2ssd Intel 730 mm. Gfx Asus matrix platinum 290x. Corsair hx650 ca 3 år gammalt. Fractal design R4 window. Skärm phillips brilliance 29" 2560x1080p Finfin skärm :)

Min musik

@albinloan

Allt vi kan tänka, kan vi skapa.

Att förespråka Mac på Swec är som att förespråka hybridbilar på en raggarträff i Mora.

Jag stavar inte fel, tangenterna sitter bara inte på rätt ställe!

Datorn: |Asus Rampage Extreme| |Intel Core 2 Extreme QX9650 @4.2GHz | |Corsair Dominator 1800Mhz 8Gb DDR3(4x2Gb)| |2xHIS Radeon HD4870| |300Gb WD VelociRaptor +1,53 TiB HDD| |Corsair 1KW PSU

Skärmar: |LG W2452V-PF 24" (Full HD)| |LG M228WA-BZ 22"| |LG 32LB75 32" LCD-TV|