Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

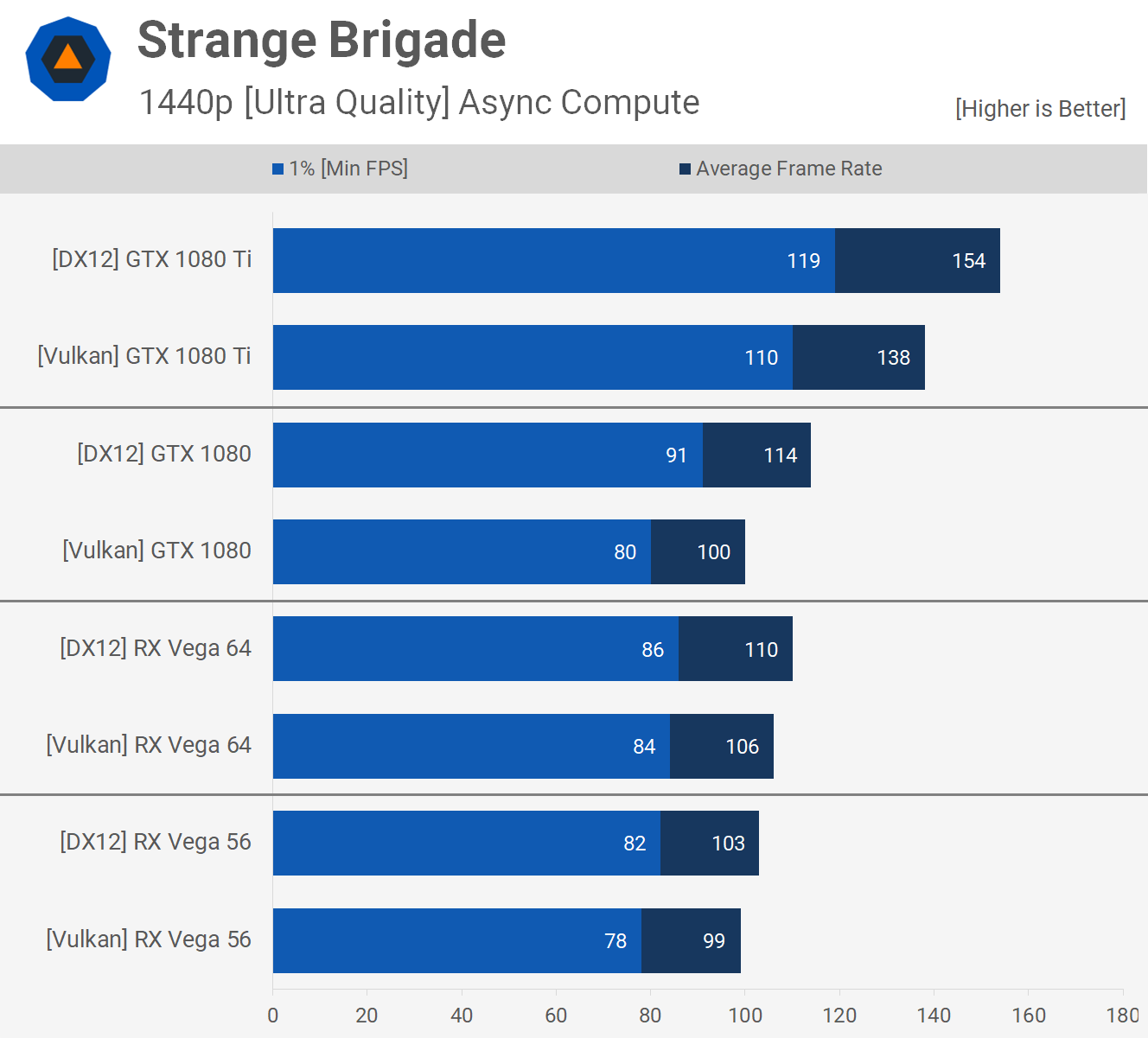

DX12 vs Vulkan jämförelse - Techspot tittar på Strange Brigade

Visa signatur

Visa signatur

Efter 10 kommer 11.

Efter 99 kommer 100.

Visa signatur

CPU: I9 10900KF -Kylare: Arctic Freezer 360 - Moderkort: ASRock Velozita Z590 PG.

GPU: RX 9070 XT Reaper @2 st 120mm cf-v12hp hydro dynamic fläktar. 👍

RAM: 32GB DDR4 3466 MHz Ballistix Elite. HÅRDDISK: 4 st SSD, 2 Mekaniska.

MONITOR:1 Xiaomi MI 34"- 3440x1440 144Hz MONITOR:2 Optix MAG274R 27" 1080p 144Hz MONITOR/Tv:3 LG 47lv355n-ZB 47". Nätagg: Asus TUF 1000w Gold Atx 3.1. Allt i ett Cooler Master CM Storm Stryker.

Visa signatur

CPU: I9 10900KF -Kylare: Arctic Freezer 360 - Moderkort: ASRock Velozita Z590 PG.

GPU: RX 9070 XT Reaper @2 st 120mm cf-v12hp hydro dynamic fläktar. 👍

RAM: 32GB DDR4 3466 MHz Ballistix Elite. HÅRDDISK: 4 st SSD, 2 Mekaniska.

MONITOR:1 Xiaomi MI 34"- 3440x1440 144Hz MONITOR:2 Optix MAG274R 27" 1080p 144Hz MONITOR/Tv:3 LG 47lv355n-ZB 47". Nätagg: Asus TUF 1000w Gold Atx 3.1. Allt i ett Cooler Master CM Storm Stryker.

Visa signatur

"There are 10 kinds of people, those

that understand binary, and those

that do not"

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Senast redigerat

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Visa signatur

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Visa signatur

AMD Ryzen 7 5700X | Saphire RX 5700 Pulse XT (Silent Mode) | 64 GB Kingston ECC | https://valid.x86.fr/51gntq | Stockkylaren | Bitfenix Whisper M 750W.

AMD Ryzen 9 5900X | AMD RX 5700 | 64 GB Micron ECC | https://valid.x86.fr/gwcxfs

HTPC | https://valid.x86.fr/gqtxws |