Stationär: AMD Ryzen 7 7800X3D | ASUS ROG Strix B650E-F Gaming WIFI | G.Skill 32GB DDR5 6000MHz CL30 Trident Z5 Neo RGB | Gigabyte 5090 Gaming OC | BeQuiet! Dark Rock 4 Pro | Samsung 980 Pro 1TB M.2 & Intel 660P 1TB M.2 | Corsair RM1000x | Antec Flux Pro | MSI 321URX QD-OLED | Corsair Strafe RGB MX Silent | Razer Deathadder v.2 | Logitech PRO X 7.1

Laptop: AMD Ryzen 7 6800HS | 16GB 4800MHz DDR5 | RTX 3060 140W | 15,6" 144Hz FHD IPS 16:9

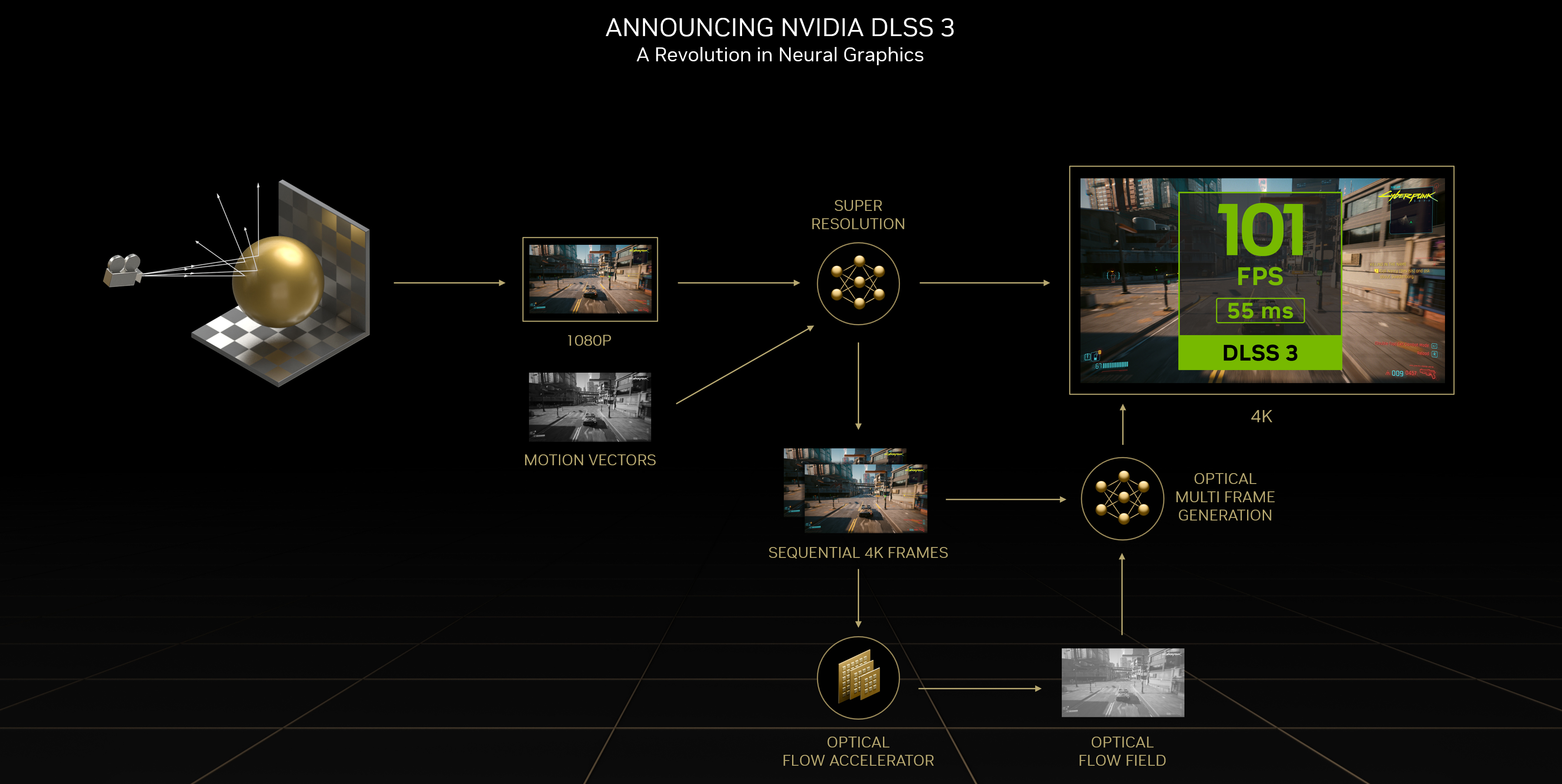

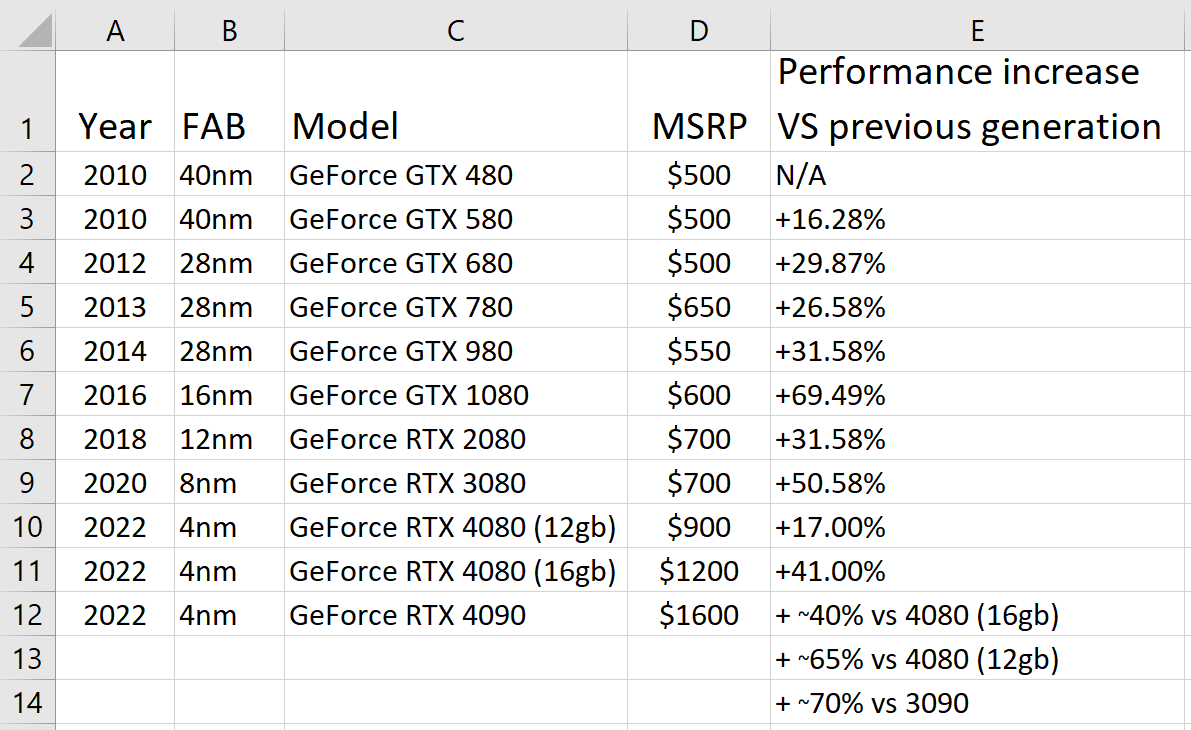

Nvidia avtäcker Geforce RTX 4000 och arkitekturen "Ada Lovelace"

MB: MSI MAG B650 Tomahawk Wifi CPU: AMD Ryzen 5 7600X RAM: G.Skill 32GB (2x16GB) DDR5 6000MHz CL30 GPU: MSI Radeon RX 6650 XT GAMING X 8G SSD: WD Black SN850X 2TB Chassi: be quiet! Silent Base 802 TG PSU: Cooler Master XG850 Platinum 850W Monitor: Alienware AW2723DF

Skärm: Acer XB271 HU, Keyboard: Corsair k95

Moderkort: Asus Prime-A Z690, GPU: RTX 4080

CPU: Intel i7 13700k, Ram: 32Gb DDR5 6000Hz

Chassi: Lian Li Lancool 3, Högtalare: ALTEC LANSING 5.1 THX

Disk 1: WD 850x 1Tb, Disk 2: WD 850x 2Tb,PSU: Seasonic Prime 1000w

Skärm: Acer XB271 HU, Keyboard: Corsair k95

Moderkort: Asus Prime-A Z690, GPU: RTX 4080

CPU: Intel i7 13700k, Ram: 32Gb DDR5 6000Hz

Chassi: Lian Li Lancool 3, Högtalare: ALTEC LANSING 5.1 THX

Disk 1: WD 850x 1Tb, Disk 2: WD 850x 2Tb,PSU: Seasonic Prime 1000w

There can be only ONE...

9950X3D X870E HERO 96/6400c30/2200 RTX5090 Gaming OC || 7950X B650 Gaming Plus WIFI 32/6000c30 RTX5080 TUF OC(450w) UBUNTU || 12900KF Z690 Tomahawk WIFI 64/3600c16 Gear1 RTX4080 Ventus 3X OC(400W) || 5900X(B2) B550-F 32/3800c18 RTX3080 TUF OC V2 || 5800X3D CH VIII EXT. 32/3800c18 RTX3080 Gaming OC || 3700X X570 HERO 32/3000c16 RTX3070 FTW3 Ultra || Thinkpad P16s G2 PRO7840U 32/6400

Skärm: Acer XB271 HU, Keyboard: Corsair k95

Moderkort: Asus Prime-A Z690, GPU: RTX 4080

CPU: Intel i7 13700k, Ram: 32Gb DDR5 6000Hz

Chassi: Lian Li Lancool 3, Högtalare: ALTEC LANSING 5.1 THX

Disk 1: WD 850x 1Tb, Disk 2: WD 850x 2Tb,PSU: Seasonic Prime 1000w

Rigg: Intel i7 4790K @ 4,7 GHz delid | Noctua NH-U12S | Asus Z97-A | Corsair 2x4+2x8 GB 2133 MHz DDR3 RAM | EVGA RTX 2080 XC Ultra GPU | Intel SSD 2x 800 GB | Acer Predator XB271HU IPS skärm | M-Audio AV42 monitorer | HyperX Cloud 2-lurar | HyperX Pulsefire FPS mus

Skärm: Acer XB271 HU, Keyboard: Corsair k95

Moderkort: Asus Prime-A Z690, GPU: RTX 4080

CPU: Intel i7 13700k, Ram: 32Gb DDR5 6000Hz

Chassi: Lian Li Lancool 3, Högtalare: ALTEC LANSING 5.1 THX

Disk 1: WD 850x 1Tb, Disk 2: WD 850x 2Tb,PSU: Seasonic Prime 1000w

A modest man is usually admired, if people ever hear of him.

Stationär: AMD Ryzen 7 7800X3D | ASUS ROG Strix B650E-F Gaming WIFI | G.Skill 32GB DDR5 6000MHz CL30 Trident Z5 Neo RGB | Gigabyte 5090 Gaming OC | BeQuiet! Dark Rock 4 Pro | Samsung 980 Pro 1TB M.2 & Intel 660P 1TB M.2 | Corsair RM1000x | Antec Flux Pro | MSI 321URX QD-OLED | Corsair Strafe RGB MX Silent | Razer Deathadder v.2 | Logitech PRO X 7.1

Laptop: AMD Ryzen 7 6800HS | 16GB 4800MHz DDR5 | RTX 3060 140W | 15,6" 144Hz FHD IPS 16:9

9950X3D X870E HERO 96/6400c30/2200 RTX5090 Gaming OC || 7950X B650 Gaming Plus WIFI 32/6000c30 RTX5080 TUF OC(450w) UBUNTU || 12900KF Z690 Tomahawk WIFI 64/3600c16 Gear1 RTX4080 Ventus 3X OC(400W) || 5900X(B2) B550-F 32/3800c18 RTX3080 TUF OC V2 || 5800X3D CH VIII EXT. 32/3800c18 RTX3080 Gaming OC || 3700X X570 HERO 32/3000c16 RTX3070 FTW3 Ultra || Thinkpad P16s G2 PRO7840U 32/6400

5900X | 6700XT