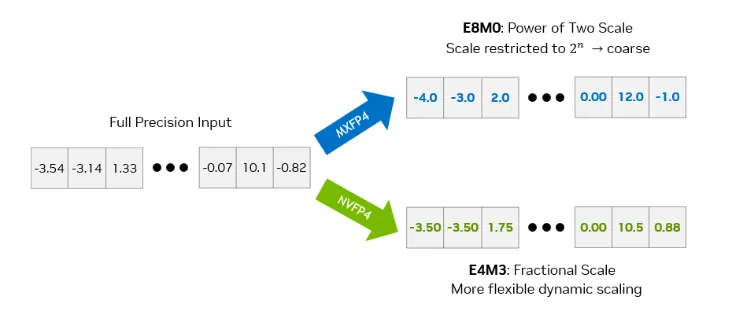

Nu är detta en väldigt nischad produkt, precis som nämnts i tråden lär huvudpoängen vara en CUDA (programvaran) kapabel lab-maskin där man kan experimentera till än lägre kostnad än de rätt svindyra Nvidia GPU datacenter-instanserna som finns.

Denna är för att tweak:a, för att sedan köra på big-iron GPUer.

Det sagt, ändå kul att se hur denna plattform står sig jämfört med t.ex. Ryzen 395 på CPU-sidan. Ser ut att vara väldigt jämt

https://browser.geekbench.com/v6/cpu/compare/14437985?baselin...

Nvidias GPU är bättre på t.ex. kompilering, medan Ryzen drar ifrån i fall som är AVX/AVX-512 optimerade (DGX Spark kör Arm X925/A725 som båda saknar SME2, det finns i årets Arm CPUer som lanserades förra månaden).

DGX Spark känns lite "meh" CPU-mässigt nu när både Qualcomm och Arm avtäckt nya modeller, som båda når nästan 4000 poäng i ST när de sitter i mobiler. Förseningen för DGX Spark så Arm han få ut en ny generation kapade en hel del av wow-faktorn...

Det jag ändå ser som viktigt att ha med sig med DGX Spark är att det är en produkt som specifikt är designad för att köra Linux!!! Den Linux den kommer med har jag förstått rätt mycket är Ubuntu Server, fast med alla drivers för plattformen förinstallerat + ett gäng CUDA-verktyg förinstallerat.

Statistiskt "ingen" kör dessa arbetslaster på Windows, så avsaknad av Windows-stöd är långt mindre viktigt än att veta att man får första klassens Linux-stöd. Sen kommer ju rätt mycket samma SoC för Windows längre fram, Nvidia/Mediatek ska ju göra en laptop-plattform (där kanske man kapat en del av 10+10 kärnorna, vi får se).

Skrivet av superapan:

Förhandstittarna visar på usel prestanda jämfört med både alternativ från Apple och AMD. Läser jag Redditposten korrent nedan är AMD 395 "AI PLUS MAX" (eller vad den heter) typ 4 ggr snabbare än DGX Spark för t.ex gpt-oss-120B (och då i nivå med RTX 3090).

https://www.reddit.com/r/LocalLLaMA/comments/1o6163l/dgx_spar...

Men man kanske vill betala för ekosystemet.

Endera har den personen gjort något misstag, alt. så är det något som gör prestandan sämre i pre-produktions versionen (han säger att det är sådan han har). I L1Techs review testas samma fall med rätt mycket bättre prestanda

Sen är det tyvärr så att den viktigare delen av detta, kapaciteten att generera tokens till svaret, är primärt begränsat av bandbredd så pass att det rätt mycket går att räkna ut vilken prestanda man kommer få när drivers/programvaran nått OK nivå.

Där är L1-Techs "bara" 2,4 gånger snabbare än reddit-resultatet. Att läsa in prompten, prefill, är L1-Techs resultat nästan 17x högre (dock svårt att se detta vara något stor flaskhals i praktiken, typiskt är svaret betydligt längre än frågan).

För de som inte använder DGX Spark specifikt för att testa CUDA-saker blir då denna lite "meh". För liknande prislapp kan man få MacStudio med M4 Max som har mer än dubbla RAM-bandbredden, eller för betydligt lägre prislapp man kan få Strix Halo (och MacMini med M4 Pro, då max 64 GB) där RAM-bandbredd är likartad.

Skrivet av Thermion:

Rent spontant så känns produkten dyr, för vad du får. Då du kan köpa konkurrentens (AMD) för halva priset, och du får x86 processor istället för ARM.

Mjukvaran till AMD's ekosystem utvecklas väldigt fort. AMD har blivit partner med Open AI dessutom som kommer hjälpa dem med mjukvaran.

Och det här väl anledningen till att Nvidia investerade i Intel, för att kunna köra ett Intel(x86)/Nvidia chip. Det lär komma om något år.

Jag hoppas ha råd med en sån här produkt i framtiden..

Värt att veta kring AMD här är att de primärt pushar HIP. I nuläget saknar Ryzen 395 AI MAX stöd för HIP, ollama går ändå att köra då det också finns en Vulkan-baserad back-end.

Tycker mognadsgrad på programvaran fortfarande är: Nvidia är #1, Apple klar #2. AMD har bättre stöd än Intel förutsatt att man har en AMD GPU som stöds. Intel stödjer typ alla deras GPUer lanserade senaste generationerna, men fick greja rätt mycket för att komma igång med deras programvara ihop med Xe2 på en NUC med U5 225H.

Är helt trivialt att komma igång med Nvidia/CUDA på Linux, likaså att komma igång med M-serie kretsarna på MacOS.