''Man får betala för kvalitet och stabilitet'' //Pantburk 2024.

Poor 9800X3D + RTX 5090 user.

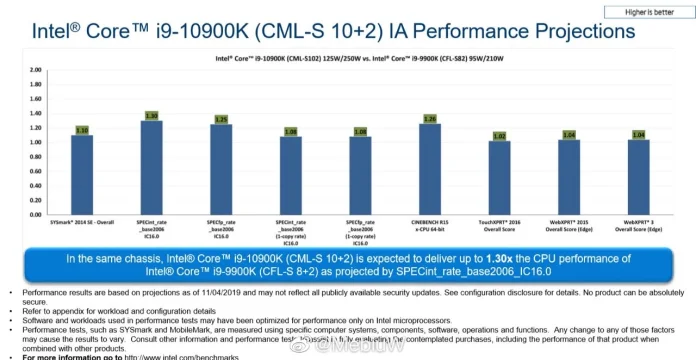

Intel Core i9-10900K "Comet Lake" – upp till 30 procent snabbare än Core i9-9900K

Hur många datorer är för många?

''Man får betala för kvalitet och stabilitet'' //Pantburk 2024.

Poor 9800X3D + RTX 5090 user.

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

Hur många datorer är för många?

New: Asus x370 prime pro, Ryzen 1700 (@3.925ghz) , Ripjaws V 16GB 3600 MHz (@3200mhz 14c). https://valid.x86.fr/curj7r

Radeon VII.

"Nobody smart would play fair"

''Man får betala för kvalitet och stabilitet'' //Pantburk 2024.

Poor 9800X3D + RTX 5090 user.

| CPU: Intel i7 7700k | RAM: Crucial DDR4 OC @2400mhz 16GB (2x8GB) | GPU: EVGA GeForce RTX 2080 XC GAMING| Mobo: MSI H110I Pro | SSD: Crucial BX200 240GB 2.5" SSD | SSD2: Samsung 850 EVO 500GB 2.5" SSD | Nätagg: be quiet! SFX L Power 600W | Kylare: NZXT Kraken X62 | Chassi: Fractal Design Nano S | OS: Windows 10 Pro

There is grandeur in this view of life, with its several powers, having been originally breathed into a few forms or into one; and that whilst this planet has gone cycling on according to the fixed law of gravity, from so simple a beginning endless forms most beautiful and most wonderful have been, and are being, evolved.

Huvudriggen är en Gigabyte Aorus Xtreme | 96gb DDR5 6000 | Ryzen 9950X3D | 5090

Utöver det är det för många datorer, boxar och servar för att lista :P

ozzed.net Min egenkomponerade 8-bit musik. Gillar du musiken från gamla klassiska NES eller Gameboy och liknande är det värt ett besök. :) Jag finns också på Spotify, Bandcamp, Jamendo, Youtube, och du kan även följa mig på Twitter och Facebook.

Vet du att du har fel? Signalera detta tydligt med Argumentationsfel och gärna Whataboutism.

''Man får betala för kvalitet och stabilitet'' //Pantburk 2024.

Poor 9800X3D + RTX 5090 user.

Fractal Design Pop XL Air RGB | ASRock Z690 Taichi | i5-12600k | Corsair 32GB (2x16GB) DDR5 6000MHz CL30 | Gigabyte RTX 5070 12GB Gaming OC

Nintendo Switch | PlayStation 5 +PS4 Pro | Xbox Series X + One X

Min FZ Profil

Fractal Design Meshify 2 Compact w/ Dark Tint | AMD R7 9800X3D | MSI MAG X870 Tomahawk WIFI | 64 GB Corsair DDR5 6000 MHz CL30 | Asus Prime RTX 5070 Ti OC 16GB GDDR7 | 512 GB Samsung Pro 850 SSD + 2TB WD Black + SN850 NVME PCI-E 4.0 | Corsair RM750X |

New: Asus x370 prime pro, Ryzen 1700 (@3.925ghz) , Ripjaws V 16GB 3600 MHz (@3200mhz 14c). https://valid.x86.fr/curj7r

Radeon VII.

WS1: | Gigabyte X670 G AX | Ryzen 9 7950x3D | 32GB G.Skill Trident Z5 NeoRGB | Sapphire RX 7800XT Pure | Corsair RM650i | FD North XL | EK Nucleus CR360 | WS2: | Asus RoG Strix X470-F | Ryzen 7 5600x | 16gb G.skill Trident Z Neo 3600mhz | Asus RoG Strix 3070 | Lian-Li Lancool 205 | ESX Srvr1 | MSI B450-A Pro Max | Ryzen 7 3700x | 64GB Corsair Vengence | Jonsbo UMX4 | Srvr2 MacMini | ClearOS

9950X3D X870E HERO 96/6400c30/2200 RTX5090 Gaming OC || 7950X B650 Gaming Plus WIFI 32/6000c30 RTX5080 TUF OC(450w) UBUNTU || 12900KF Z690 Tomahawk WIFI 64/3600c16 Gear1 RTX4080 Ventus 3X OC(400W) || 5900X(B2) B550-F 32/3800c18 RTX3080 TUF OC V2 || 5800X3D CH VIII EXT. 32/3800c18 RTX3080 Gaming OC || 3700X X570 HERO 32/3000c16 RTX3070 FTW3 Ultra || Thinkpad P16s G2 PRO7840U 32/6400

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer