Finns det någon tillförlitlig information kring exakt hur mycket kretsyta RT-kärnorna och Tensor-kärnorna skulle ta? Jämförelser mellan 1600-serien och 2000-serien pekar ju på att det inte handlar om speciellt mycket yta.

Är ju några som gett sig på att försöka lura ut detta från die-shots, t.ex. denna. Om den stämmer tar ju RT-kärnor + tensor-kärnor ~10 % extra kretsyta, väsentligt mer av tillskottet kommer från (enligt dig själv) de mer användbara tensor-kärnorna.

Om man tittar vad RT-kärnorna faktiskt utför borde de ta väldigt lite kisel, det är en extremt specifik uppgift de har och för att få till hela ray tracing delen används en kombination av RT-kärnor och de vanliga CUDA-kärnorna. Det borde vara goda nyheter även för de som inte ser värdet i ray tracing, detta då Nvidia har ett väldigt starkt incitament att fortsätta öka kapaciteten för de "vanliga" CUDA-kärnorna även för att förbättra ray tracing stödet.

Jag baserar mig på vaga minnen av nånting jag såg i närheten av release, har tyvärr knappast någon länk tyvärr. Troligen adoredtv eller liknande.

Min bild av RT är att det är en helt annan form av beräkningar än en vanlig gpu och kan därför dela väldigt lite resurser med resterande gpu. Förenklat kan man säga att en vanlig gpu last kör samma program på varierad data (rotera alla punkter via en fast matris, men alla punkter kan vara olika) medan rt är helt annorlunda. Vanliga operationer i rt är att beräkna studsar av strålar och hitta objekt i närheten av dom, dessa operationer är extremt svåra att köra på en gpu eftersom varje stråle studsar (troligen) i en egen vinkel på en annan yta än alla andra, dessutom sprider sig alla strålar åt olika håll vilket gör att de är nära och interagerar med helt olika objekt. Enklaste sättet är att se rt som singeltrådat, därför räknade jag med att det var separat kisel som behövdes...

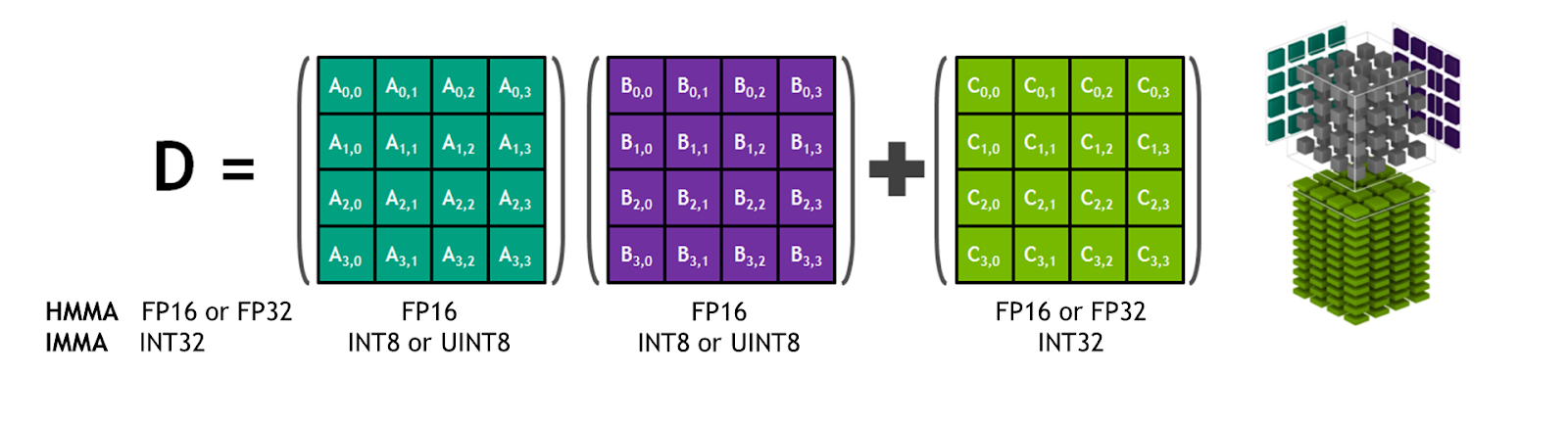

Något liknande denna bild:

Skickades från m.sweclockers.com