Det är inte frågan om att ens försöka träna algoritmen på alla potentiella bilder från spel, eller ha med alla tänkbara positioner för saker som rör sig. Vad den gör är i princip att lära sig generellt skilja på lågupplösta bilder mot högupplösta, för att sen skala/interpolera lågupplösta bilder så att de hamnar så nära högupplösta som möjligt.

Inte heller är det frågan om att försöka framställa perfekta bildrutor av främst tomma miljöer och från huvudstråken av spelvärlden. Det är inte så deep learning fungerar. Alls. Snarare tvärtom med massor av träningsdata där det finns både stor och liten variation mellan bilder.

Jag är ganska säker att du har fel här, men det är ganska lite som är öppet med hur Nvidia tränar sina nätverk.

Med det sagt så finns det inte några direkta skillnader mellan upplösning vs avstånd, så det är lite konstigt att kalla det för att känna igen lågupplöst innehåll.

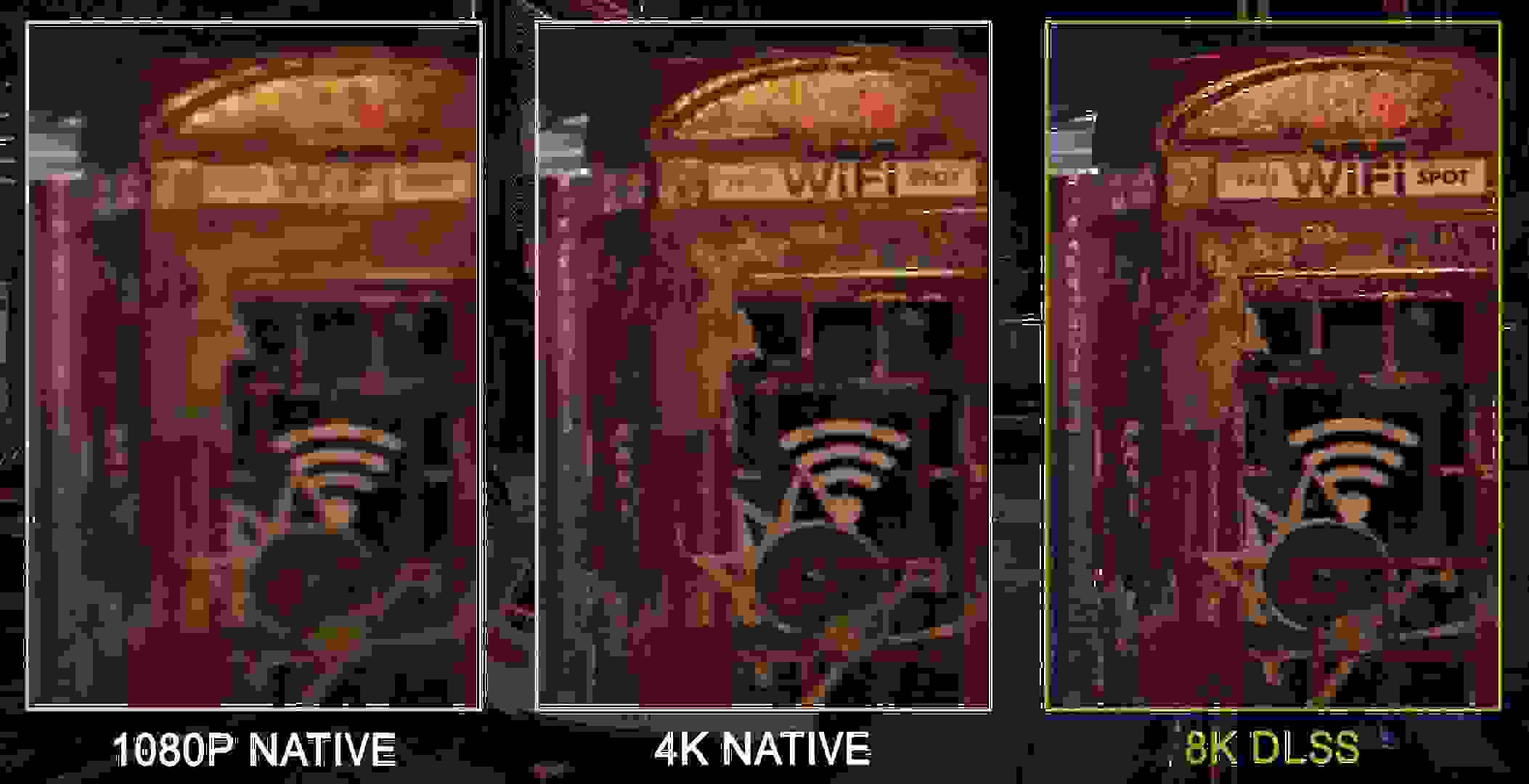

De skalar ju x*y pixlar till cx*cy pixlar genom att ’vikta in’ hur spelet ser ut. Just hur spelet generellt ser ut är ju just träningen. Det går helt enkelt inte att träna generellt på allt som kan visas på skärmen i ett visst spel, alldeles för mycket är dynamiskt innehåll som inte går att träna för på ett bra sätt (jag gav några exempel ovan). Det finns många videos på nätet redan som visar hur dåligt DLSS fungerar i flera av dessa scenarios.

Jag sade inte att målet som nätverket har är tomma miljöer, med det är den typ av bilder som är säkrast och bäst att träna med, se så klart finns det mer dynamiska träningsbilder också, men de kan lätt framställa felaktiga resultat om man tränar för hårt på dessa (som rök eller partiklar). Det finns såklart inget mål i sig med att göra det såhär, men det är helt enkelt så verktygen ser ut för just bildanalyserande nätverk