Ifall Input Signal Plus *INTE* är aktiverad, så kommer EDID beskriva 4K/60 som högsta möjliga signal. FRL och DSC kommer inte beskrivas. Man kan normalt inte ens välja 4K/120 i inställningarna som följd.

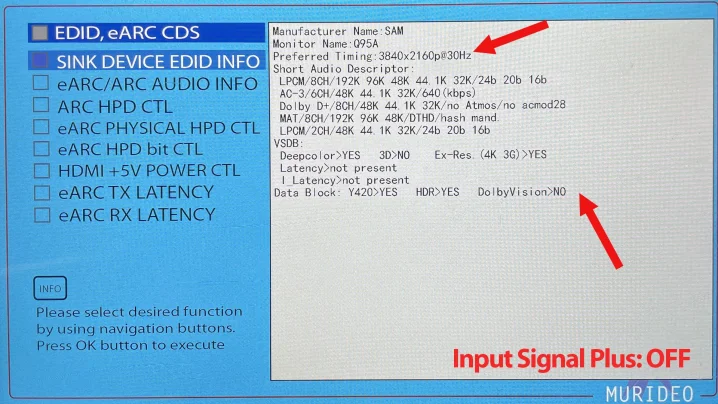

Informationen vid pilarna saknas om man *INTE* aktiverat Input Signal Plus

https://cdn.sweclockers.com/artikel/bild/105828?l=eyJyZXNvdXJjZS...

Detta från min artikel om Samsung TV som PC-skärm: https://www.sweclockers.com/artikel/35091-guide-samsungs-tv-s...

Detta är EDID när man kör med Input Signal Plus: OFF – eller icke fylld cirkel i TV:ns gränssnitt.

Notera att information om FRL och DSC är borta, liksom att rekommenderad timing är 4K/30 Hz. Grafikkortet får aldrig information om att högre bandbredd är möjligt. Då ska de försvinna från inställningarna i datorn, men man kan inte vara helt säker.

Om man kan få till PC: 3840x2160, 120 Hz, 10 bitar och RGB-signal i grafikkortets inställningar är det ett tecken på att Input Signal Plus är aktiverad. Rätt EDID når GPU:n så att den signalen kan väljas i Nvidia Controlpanel etc. Kommer bilden i vilket fall inte fram, "no signal", är det ett tecken på att kabeln inte är tillräckligt bra.

Om man då testar med fler kablar och flera Ultra High Speed-certifierade kablar och ändå får problemet är det ett tecken på att det inte fungerar till 100 procent på kretsnivå mellan sink och source. Där har då AOC-kablar en teknisk fördel med att de re-clockar signalen i sink-änden och tar hand om transporten.

Min erfarenhet baserat på egna försök men också forumdiskussioner som dessa, är att det är lite YMMV med Nvidia-kort och passiva kablar. Inte bara för Samsung. Jag får som skrivet det att fungera med alla Samsung med mitt 3080Ti och en UHS-certad AOC-kabel på 10 meter. Men det är ändå lite wonky med Samsung. Återkommande "no signal", Input Signal Plus stänger av sig själv och jag måste dra kabeln in och ut regelbundet.

När jag dragit ut kabeln brukar Input Signal Plus stängas av. Då måste man aktivera det igen på nytt. Finns då en möjlighet att GPU/Windows fortfarande har en buffrad EDID som tror att FRL/40Gbps etc. fungerar, så att 4K/120-alternativen syns i menyer, medan Samsungen vägrar ta emot den signalen.

Andra TV-tillverkare, specifikt LG och Panasonic (on top of my head) har samarbetat med Nvidia och därför säkrat funktionen den vägen.

----

Jag bara nördpostulerar här men detta är inget nytt med Nvidia-kort. Liknande problem förekommer med bildskärmar där det pekas på olika klocktoleranser runt signalens mellan sink och source. Nvidia generellt större toleranser medan TV:n och bildskärmens kretsar kan ha snävare toleranser. Den tillverkaren som går till Nvidia och säkrar funktionen, likt G-Sync Compatible, etc. lär antagligen styra upp toleransnivåerna. Andra tillverkare gör det inte och det kan finnas diverse olika skäl bakom, med detta blir off topic rätt snabbt...

Vad en AOC-kabel gör är just detta med klockningen av signalen. Det är inte längre source (nvidia-GPU:n) som styr klockningen mot TV:n utan AOC-kabelns egna kretsar. Re-clock direkt i den opto-elektriska omvandlingen vilket sker i den bokstavliga HDMI-kontakten som sitter i själva TV:n.

Vet inte ifall AOC är den definitiva lösningen. Men det vore trevligt att få det bekräftat med lite fler Nvidia-kort än mitt eget.