My Rig https://classic.prisjakt.nu/list.php?ftg_check=on&exclude_ftg...

Fel av mig! Men sjutton vad snabba ni är på att kommentera vad andra gör och inte gör rätt och fel... :/

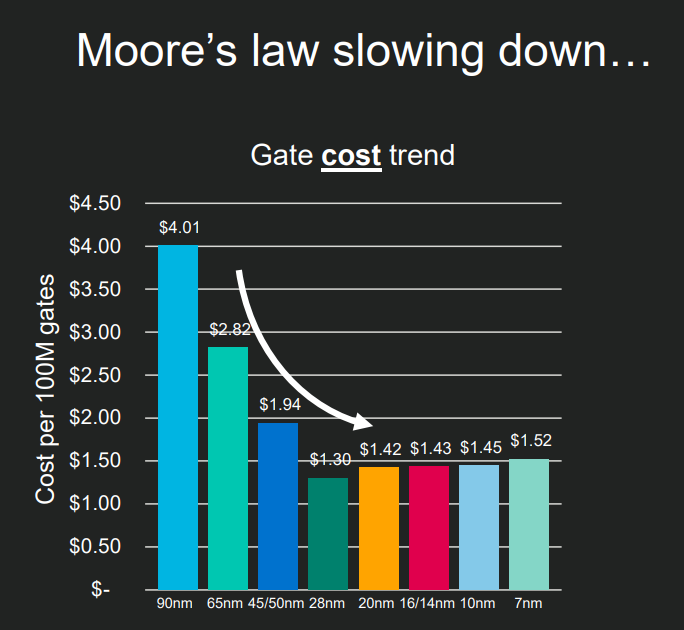

Nvidia: "Moores lag är död"

| 9800X3D | MSI B650 Tomahawk | 2x16 GB 6400 cl36 | Intel 600p 512GB | RTX 4070 TUF

Asus X470 gaming-f, 5800x, 7900xt, g.skill 32gb 3200 cl 14.

Desktop

AMD Ryzen 7 5800x @ 4.8 GHz --- ASUS B450-F Gaming --- Kingston Hyperx Fury Black 32 GB DDR4 3000MHz --- ASUS RTX 3080 Rog Strix --- AOC Agon AG352UCG6 35" + ASUS PA238Q 24" --- Thermaltake Core X5 TG --- EVGA SuperNova G2 750W --- Noctua NH-D15

Server

Intel i5 4670K med Be-Quiet Pure Rock --- MSI B85M-E45 --- Crucial BallistiX Sport 16 GB --- Bitfenix Phenom Micro-ATX --- Cooler Master G500 500W

| 9800X3D | MSI B650 Tomahawk | 2x16 GB 6400 cl36 | Intel 600p 512GB | RTX 4070 TUF

Registrerad 2001-12-24 15:10

Jul med Kalle Anka och Sweclockers

| 9800X3D | MSI B650 Tomahawk | 2x16 GB 6400 cl36 | Intel 600p 512GB | RTX 4070 TUF

ASUS ROG STRIX B450-F GAMING - AMD Ryzen 7 5700X3D - Thermalright Phantom Spirit 120 SE - Corsair 32GB (4x8GB) DDR4 3200Mhz CL16 Vengeance LPX - Kingston A2000 500GB M.2 NVMe - Samsung 990 PRO 1TB M.2 - Fractal Design Define C Svart - 2 X Noctua NF-P14s redux-1200 140mm PWM - Corsair RM650X 650W v2 - Asus Radeon RX7800 XT DUAL OC 16 GB - OS Debian Sid

| Corsair Obsidian 500D | Intel Xeon E5-1680 v2 3.9GHz med Corsair iCUE H115i Elite Capellix XT | Asus Rampage IV Black Edition | G.Skill Sniper 4x8GB 2133MHz CL10 | 2x EVGA GeForce GTX TITAN X 12GB, SLI | X-Fi Titanium Fatal1ty Pro | Samsung 870 EVO 2TB, Samsung 870 EVO 1TB, 2x Seagate Barracuda 2TB | Corsair AX860i | DELL P991 Trinitron | Windows XP/10 Dual-Boot |

AMD Ryzen 7 5800X3D | EVGA GeForce RTX 3080 10GB FTW3 ULTRA | ASUS ROG Strix B450-F Gaming | Corsair RM750X V2 | Crucial Ballistix Sport LT 3200MHz 16GB | Samsung 980 Pro 1TB | Crucial MX500 2TB | NZXT H500

5800X - 2080ti - DDR4 32gb 3200mhz - B550-F - Arctic LF II 240 - RM750X - H510 flow

Engineer who prefer thinking out of the box and isn't fishing likes, fishing likes is like fishing proudness for those without ;-)

If U don't like it, bite the dust :D

--

I can Explain it to you, but I can't Understand it for you!

PC: B550 TOMAHAWK | 5800X3D | Palit 4090 GameRock @2520 MHz, 925 mV | G.Skill Trident Z 2x16GB 3600MHz CL16 | Peerless Assassin | WD Black SN850 1TB | Intel 660P 1TB | Seasonic Prime PX 1300W | Kolink Void X | Corsair iCUE ML120 RGB ELITE x4 | Arctic P12 x2 Kringutrustning: LG OLED55C15LA | Centrum subwoofer | Keychron K2 | Logitech G305 | PS5 DualSense Edge @8000Hz | Xbox trådlöst headset HTPC: Biostar B550MX/E PRO | 3600 @4.05 GHz, 1.22 V | ASUS 1070 Turbo @1822 MHz, 2702 MHz, 943 mV | G.Skill Trident Z 2x16GB 3200MHz CL14 | Dark Rock TF 2 | Crucial P3 1TB | Intel AX200NGW | Cougar GEX 750W | SilverStone GD09 | Finlux 40FLHY127B ROG Zephyrus G14: 4800HS | 1660 Ti Max-Q

[AMD Ryzen 9 3900X] [ASUS GeForce RTX 2080 Ti] [LG OLED 55 C9 som skärm] [Samsung HW-Q96R till ljudet]

PC: B550 TOMAHAWK | 5800X3D | Palit 4090 GameRock @2520 MHz, 925 mV | G.Skill Trident Z 2x16GB 3600MHz CL16 | Peerless Assassin | WD Black SN850 1TB | Intel 660P 1TB | Seasonic Prime PX 1300W | Kolink Void X | Corsair iCUE ML120 RGB ELITE x4 | Arctic P12 x2 Kringutrustning: LG OLED55C15LA | Centrum subwoofer | Keychron K2 | Logitech G305 | PS5 DualSense Edge @8000Hz | Xbox trådlöst headset HTPC: Biostar B550MX/E PRO | 3600 @4.05 GHz, 1.22 V | ASUS 1070 Turbo @1822 MHz, 2702 MHz, 943 mV | G.Skill Trident Z 2x16GB 3200MHz CL14 | Dark Rock TF 2 | Crucial P3 1TB | Intel AX200NGW | Cougar GEX 750W | SilverStone GD09 | Finlux 40FLHY127B ROG Zephyrus G14: 4800HS | 1660 Ti Max-Q

Ryzen 5800X ROG STRIX X570-f GAMING FlareX DDR43600 cl 14-14-14-34 EVGA FTW3 Ultra RTX 3090

E2160 @ 3,2 , scyte infinity, p35 ds3, 4gb corsair 800mhz, Sapphire 5850 1gb. Intel x-25 V 40gb, 1x western digital black. /laptop amd x2 2.2ghz 3gb 5730.

Care About Your Craft: Why spend your life developing software unless you care about doing it well? - The Pragmatic Programmer

||Wintel PC|3*Mac mini|Xbox One S|Synology DS918+||